Avaliar manualmente prompts no playground do portal do Azure AI Foundry

Importante

Os itens marcados (visualização) neste artigo estão atualmente em visualização pública. Essa visualização é fornecida sem um contrato de nível de serviço e não a recomendamos para cargas de trabalho de produção. Algumas funcionalidades poderão não ser suportadas ou poderão ter capacidades limitadas. Para obter mais informações, veja Termos Suplementares de Utilização para Pré-visualizações do Microsoft Azure.

Quando você começa com a engenharia de prompt, você deve testar diferentes entradas, uma de cada vez, para avaliar a eficácia do prompt pode ser muito demorado. Isso porque é importante verificar se os filtros de conteúdo estão funcionando adequadamente, se a resposta é precisa e muito mais.

Para tornar esse processo mais simples, você pode utilizar a avaliação manual no portal do Azure AI Foundry, uma ferramenta de avaliação que permite iterar e avaliar continuamente seu prompt em relação aos dados de teste em uma única interface. Você também pode classificar manualmente as saídas, as respostas do modelo, para ajudá-lo a ganhar confiança em seu prompt.

A avaliação manual pode ajudá-lo a começar a entender o desempenho do seu prompt e iterar no seu prompt para garantir que você atinja o nível desejado de confiança.

Neste artigo você aprende a:

- Gere os resultados da sua avaliação manual

- Classifique as respostas do seu modelo

- Itere em seu prompt e reavalie

- Guardar e comparar resultados

- Avalie com métricas integradas

Pré-requisitos

Para gerar resultados de avaliação manual, você precisa ter o seguinte pronto:

Um conjunto de dados de teste em um destes formatos: csv ou jsonl. Se você não tiver um conjunto de dados disponível, também permitimos que você insira dados manualmente a partir da interface do usuário.

Uma implantação de um desses modelos: modelos GPT 3.5, modelos GPT 4 ou modelos Davinci. Para saber mais sobre como criar uma implantação, consulte Implantar modelos.

Nota

A avaliação manual só é suportada para modelos OpenAI do Azure neste momento para tipos de tarefas de chat e conclusão.

Gere os resultados da sua avaliação manual

No Playground, selecione Avaliação manual para iniciar o processo de revisão manual das respostas do modelo com base nos dados e no prompt do teste. Seu prompt é automaticamente transferido para sua avaliação Manual e agora você só precisa adicionar dados de teste para avaliar o prompt contra.

Isso pode ser feito manualmente usando as caixas de texto na coluna Entrada .

Você também pode Importar dados para escolher um dos conjuntos de dados existentes anteriormente em seu projeto ou carregar um conjunto de dados que esteja no formato CSV ou JSONL. Depois de carregar os dados, você será solicitado a mapear as colunas adequadamente. Depois de concluir e selecionar Importar, os dados serão preenchidos adequadamente nas colunas abaixo.

Nota

Você pode adicionar até 50 linhas de entrada à sua avaliação manual. Se os dados de teste tiverem mais de 50 linhas de entrada, carregaremos as primeiras 50 na coluna de entrada.

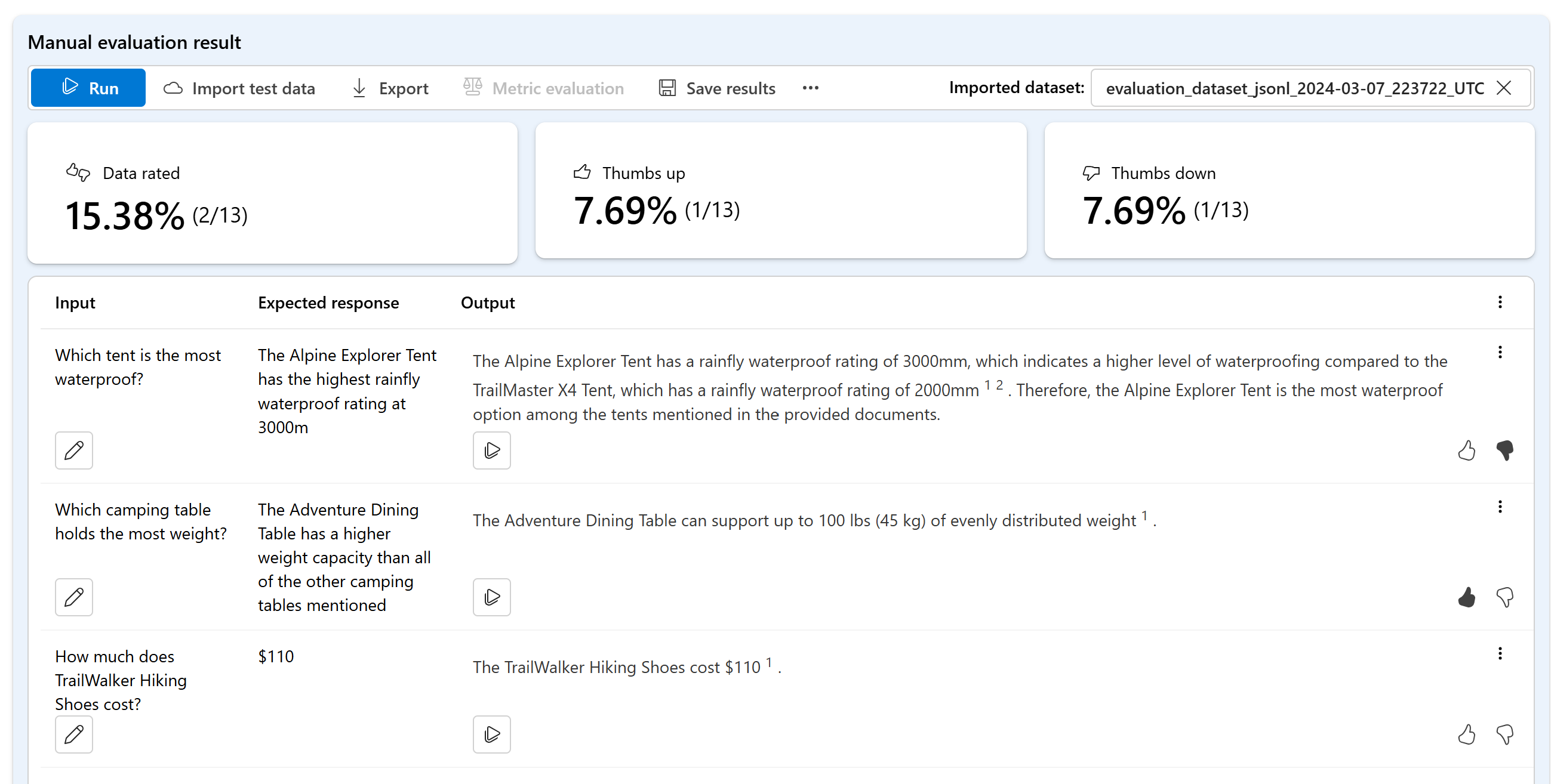

Agora que seus dados foram adicionados, você pode Executar para preencher a coluna de saída com a resposta do modelo.

Classifique as respostas do seu modelo

Você pode fornecer uma classificação de polegar para cima ou para baixo para cada resposta para avaliar a saída do prompt. Com base nas classificações fornecidas, você pode visualizar essas pontuações de resposta nos resumos rápidos.

Itere em seu prompt e reavalie

Com base no resumo, convém fazer alterações no prompt. Você pode usar os controles de prompt acima para editar a configuração do prompt. Isso pode ser atualizar a mensagem do sistema, alterar o modelo ou editar os parâmetros.

Depois de fazer suas edições, você pode optar por executar tudo novamente para atualizar a tabela inteira ou se concentrar em executar novamente linhas específicas que não atenderam às suas expectativas na primeira vez.

Guardar e comparar resultados

Depois de preencher os resultados, você pode salvar os resultados para compartilhar o progresso com sua equipe ou continuar sua avaliação manual de onde parou mais tarde.

Você também pode comparar as classificações de polegar para cima e para baixo em suas diferentes avaliações manuais salvando-as e visualizando-as na guia Avaliação em Avaliação manual.

Próximos passos

Saiba mais sobre como avaliar suas aplicações de IA generativa:

- Avalie seus aplicativos de IA generativa com o portal ou SDK do Azure AI Foundry

- Ver os resultados da avaliação

Saiba mais sobre técnicas de mitigação de danos.