Redimensionar conjuntos de nós no Azure Kubernetes Service (AKS)

Devido a um número crescente de implementações ou à execução de uma carga de trabalho maior, poderá querer alterar o plano do conjunto de dimensionamento de máquinas virtuais ou redimensionar as instâncias do AKS. No entanto, de acordo com as políticas de suporte para AKS:

Os nós do agente AKS aparecem no portal do Azure como recursos regulares de IaaS do Azure. Mas essas máquinas virtuais são implantadas em um grupo de recursos personalizado do Azure (geralmente prefixada com MC_*). Não é possível fazer personalizações diretas nesses nós usando as APIs ou recursos IaaS. Quaisquer alterações personalizadas que não sejam feitas através da API AKS não persistirão através de uma atualização, escala, atualização ou reinicialização.

Essa falta de persistência também se aplica à operação de redimensionamento, portanto, o redimensionamento de instâncias AKS dessa maneira não é suportado. Neste guia de instruções, você aprenderá o método recomendado para lidar com esse cenário.

Importante

Este método é específico para clusters AKS baseados em conjuntos de escala de máquina virtual. Ao usar conjuntos de disponibilidade de máquina virtual, você está limitado a apenas um pool de nós por cluster.

Recursos de exemplo

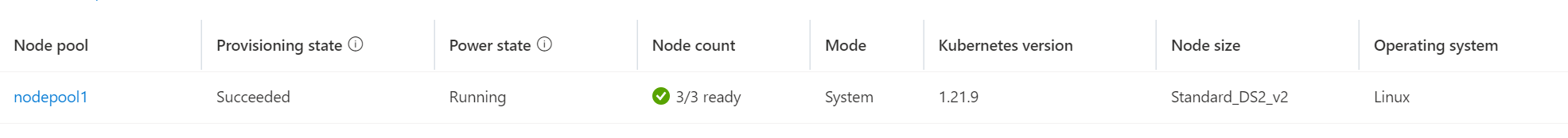

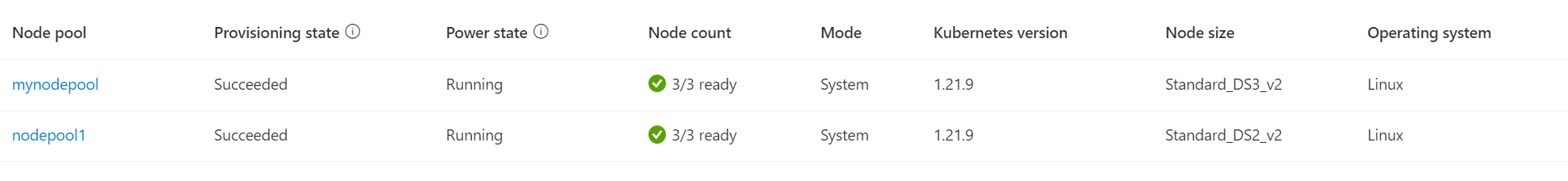

Suponha que você queira redimensionar um pool de nós existente, chamado nodepool1, de tamanho de SKU Standard_DS2_v2 para Standard_DS3_v2. Para realizar essa tarefa, você precisará criar um novo pool de nós usando Standard_DS3_v2, mover cargas de trabalho do novo pool de nodepool1 nós e remover nodepool1o . Neste exemplo, chamaremos esse novo pool de nós mynodepoolde .

kubectl get nodes

NAME STATUS ROLES AGE VERSION

aks-nodepool1-31721111-vmss000000 Ready agent 10d v1.21.9

aks-nodepool1-31721111-vmss000001 Ready agent 10d v1.21.9

aks-nodepool1-31721111-vmss000002 Ready agent 10d v1.21.9

kubectl get pods -o wide -A

NAMESPACE NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE READINESS GATES

default sampleapp2-74b4b974ff-676sz 1/1 Running 0 93m 10.244.1.6 aks-nodepool1-31721111-vmss000002 <none> <none>

default sampleapp2-76b6c4c59b-pfgbh 1/1 Running 0 94m 10.244.1.5 aks-nodepool1-31721111-vmss000002 <none> <none>

kube-system azure-ip-masq-agent-4n66k 1/1 Running 0 10d 10.240.0.6 aks-nodepool1-31721111-vmss000002 <none> <none>

kube-system azure-ip-masq-agent-9p4c8 1/1 Running 0 10d 10.240.0.4 aks-nodepool1-31721111-vmss000000 <none> <none>

kube-system azure-ip-masq-agent-nb7mx 1/1 Running 0 10d 10.240.0.5 aks-nodepool1-31721111-vmss000001 <none> <none>

kube-system coredns-845757d86-dtvvs 1/1 Running 0 10d 10.244.0.2 aks-nodepool1-31721111-vmss000000 <none> <none>

kube-system coredns-845757d86-x27pp 1/1 Running 0 10d 10.244.2.3 aks-nodepool1-31721111-vmss000001 <none> <none>

kube-system coredns-autoscaler-5f85dc856b-nfrmh 1/1 Running 0 10d 10.244.2.4 aks-nodepool1-31721111-vmss000001 <none> <none>

kube-system csi-azuredisk-node-9nfzt 3/3 Running 0 10d 10.240.0.4 aks-nodepool1-31721111-vmss000000 <none> <none>

kube-system csi-azuredisk-node-bblsb 3/3 Running 0 10d 10.240.0.5 aks-nodepool1-31721111-vmss000001 <none> <none>

kube-system csi-azuredisk-node-tjhj4 3/3 Running 0 10d 10.240.0.6 aks-nodepool1-31721111-vmss000002 <none> <none>

kube-system csi-azurefile-node-9pcr8 3/3 Running 0 3d10h 10.240.0.6 aks-nodepool1-31721111-vmss000002 <none> <none>

kube-system csi-azurefile-node-bh2pc 3/3 Running 0 3d10h 10.240.0.5 aks-nodepool1-31721111-vmss000001 <none> <none>

kube-system csi-azurefile-node-h75gq 3/3 Running 0 3d10h 10.240.0.4 aks-nodepool1-31721111-vmss000000 <none> <none>

kube-system konnectivity-agent-6cd55c69cf-ngdlb 1/1 Running 0 10d 10.240.0.6 aks-nodepool1-31721111-vmss000002 <none> <none>

kube-system konnectivity-agent-6cd55c69cf-rvvqt 1/1 Running 0 10d 10.240.0.4 aks-nodepool1-31721111-vmss000000 <none> <none>

kube-system kube-proxy-4wzx7 1/1 Running 0 10d 10.240.0.4 aks-nodepool1-31721111-vmss000000 <none> <none>

kube-system kube-proxy-g5tvr 1/1 Running 0 10d 10.240.0.6 aks-nodepool1-31721111-vmss000002 <none> <none>

kube-system kube-proxy-mrv54 1/1 Running 0 10d 10.240.0.5 aks-nodepool1-31721111-vmss000001 <none> <none>

kube-system metrics-server-774f99dbf4-h52hn 1/1 Running 1 3d10h 10.244.1.3 aks-nodepool1-31721111-vmss000002 <none> <none>

Crie um novo pool de nós com a SKU desejada

Ao redimensionar, considere todos os requisitos de carga de trabalho, como zonas de disponibilidade, e configure o pool de nós de acordo. Talvez seja necessário modificar o comando a seguir para melhor atender às suas necessidades. Para obter uma lista completa das opções de configuração, consulte a az aks nodepool add página de referência.

Use o az aks nodepool add comando para criar um novo pool de nós chamado mynodepool com três nós usando a SKU da Standard_DS3_v2 VM:

az aks nodepool add \

--resource-group myResourceGroup \

--cluster-name myAKSCluster \

--name mynodepool \

--node-count 3 \

--node-vm-size Standard_DS3_v2 \

--mode System \

--no-wait

Nota

Cada cluster AKS deve conter pelo menos um pool de nós do sistema com pelo menos um nó. No exemplo acima, estamos usando um --mode de System, pois supõe-se que o cluster tenha apenas um pool de nós, necessitando de um System pool de nós para substituí-lo. O modo do pool de nós pode ser atualizado a qualquer momento.

Após alguns minutos, o novo pool de nós foi criado:

kubectl get nodes

NAME STATUS ROLES AGE VERSION

aks-mynodepool-20823458-vmss000000 Ready agent 23m v1.21.9

aks-mynodepool-20823458-vmss000001 Ready agent 23m v1.21.9

aks-mynodepool-20823458-vmss000002 Ready agent 23m v1.21.9

aks-nodepool1-31721111-vmss000000 Ready agent 10d v1.21.9

aks-nodepool1-31721111-vmss000001 Ready agent 10d v1.21.9

aks-nodepool1-31721111-vmss000002 Ready agent 10d v1.21.9

Cordão aos nós existentes

Cordoning marca nós especificados como não escalonáveis e impede que mais pods sejam adicionados aos nós.

Primeiro, obtenha os nomes dos nós com os quais você gostaria de fazer cordon .kubectl get nodes Sua saída deve ser semelhante à seguinte:

NAME STATUS ROLES AGE VERSION

aks-nodepool1-31721111-vmss000000 Ready agent 7d21h v1.21.9

aks-nodepool1-31721111-vmss000001 Ready agent 7d21h v1.21.9

aks-nodepool1-31721111-vmss000002 Ready agent 7d21h v1.21.9

Em seguida, usando kubectl cordon <node-names>, especifique os nós desejados em uma lista separada por espaço:

kubectl cordon aks-nodepool1-31721111-vmss000000 aks-nodepool1-31721111-vmss000001 aks-nodepool1-31721111-vmss000002

node/aks-nodepool1-31721111-vmss000000 cordoned

node/aks-nodepool1-31721111-vmss000001 cordoned

node/aks-nodepool1-31721111-vmss000002 cordoned

Drene os nós existentes

Importante

Para drenar com êxito nós e remover pods em execução, certifique-se de que qualquer PodDisruptionBudgets (PDBs) permita que pelo menos uma réplica de pod seja movida de cada vez. Caso contrário, a operação de drenagem/despejo falhará. Para verificar isso, você pode executar kubectl get pdb -A e verificar ALLOWED DISRUPTIONS se é pelo menos um ou superior.

A drenagem de nós fará com que os pods que correm neles sejam removidos e recriados nos outros nós escalonáveis.

Para drenar nós, use kubectl drain <node-names> --ignore-daemonsets --delete-emptydir-data, novamente usando uma lista separada por espaço de nomes de nós:

Importante

O uso --delete-emptydir-data é necessário para remover os pods e metrics-server os pods criados coredns pelo AKS. Se esse sinalizador não for usado, um erro será esperado. Para obter mais informações, consulte a documentação em emptydir.

kubectl drain aks-nodepool1-31721111-vmss000000 aks-nodepool1-31721111-vmss000001 aks-nodepool1-31721111-vmss000002 --ignore-daemonsets --delete-emptydir-data

Depois que a operação de drenagem terminar, todos os pods que não sejam os controlados por conjuntos de daemon serão executados no novo pool de nós:

kubectl get pods -o wide -A

NAMESPACE NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE READINESS GATES

default sampleapp2-74b4b974ff-676sz 1/1 Running 0 15m 10.244.4.5 aks-mynodepool-20823458-vmss000002 <none> <none>

default sampleapp2-76b6c4c59b-rhmzq 1/1 Running 0 16m 10.244.4.3 aks-mynodepool-20823458-vmss000002 <none> <none>

kube-system azure-ip-masq-agent-4n66k 1/1 Running 0 10d 10.240.0.6 aks-nodepool1-31721111-vmss000002 <none> <none>

kube-system azure-ip-masq-agent-9p4c8 1/1 Running 0 10d 10.240.0.4 aks-nodepool1-31721111-vmss000000 <none> <none>

kube-system azure-ip-masq-agent-nb7mx 1/1 Running 0 10d 10.240.0.5 aks-nodepool1-31721111-vmss000001 <none> <none>

kube-system azure-ip-masq-agent-sxn96 1/1 Running 0 49m 10.240.0.9 aks-mynodepool-20823458-vmss000002 <none> <none>

kube-system azure-ip-masq-agent-tsq98 1/1 Running 0 49m 10.240.0.8 aks-mynodepool-20823458-vmss000001 <none> <none>

kube-system azure-ip-masq-agent-xzrdl 1/1 Running 0 49m 10.240.0.7 aks-mynodepool-20823458-vmss000000 <none> <none>

kube-system coredns-845757d86-d2pkc 1/1 Running 0 17m 10.244.3.2 aks-mynodepool-20823458-vmss000000 <none> <none>

kube-system coredns-845757d86-f8g9s 1/1 Running 0 17m 10.244.5.2 aks-mynodepool-20823458-vmss000001 <none> <none>

kube-system coredns-autoscaler-5f85dc856b-f8xh2 1/1 Running 0 17m 10.244.4.2 aks-mynodepool-20823458-vmss000002 <none> <none>

kube-system csi-azuredisk-node-7md2w 3/3 Running 0 49m 10.240.0.7 aks-mynodepool-20823458-vmss000000 <none> <none>

kube-system csi-azuredisk-node-9nfzt 3/3 Running 0 10d 10.240.0.4 aks-nodepool1-31721111-vmss000000 <none> <none>

kube-system csi-azuredisk-node-bblsb 3/3 Running 0 10d 10.240.0.5 aks-nodepool1-31721111-vmss000001 <none> <none>

kube-system csi-azuredisk-node-lcmtz 3/3 Running 0 49m 10.240.0.9 aks-mynodepool-20823458-vmss000002 <none> <none>

kube-system csi-azuredisk-node-mmncr 3/3 Running 0 49m 10.240.0.8 aks-mynodepool-20823458-vmss000001 <none> <none>

kube-system csi-azuredisk-node-tjhj4 3/3 Running 0 10d 10.240.0.6 aks-nodepool1-31721111-vmss000002 <none> <none>

kube-system csi-azurefile-node-29w6z 3/3 Running 0 49m 10.240.0.9 aks-mynodepool-20823458-vmss000002 <none> <none>

kube-system csi-azurefile-node-4nrx7 3/3 Running 0 49m 10.240.0.7 aks-mynodepool-20823458-vmss000000 <none> <none>

kube-system csi-azurefile-node-9pcr8 3/3 Running 0 3d11h 10.240.0.6 aks-nodepool1-31721111-vmss000002 <none> <none>

kube-system csi-azurefile-node-bh2pc 3/3 Running 0 3d11h 10.240.0.5 aks-nodepool1-31721111-vmss000001 <none> <none>

kube-system csi-azurefile-node-gqqnv 3/3 Running 0 49m 10.240.0.8 aks-mynodepool-20823458-vmss000001 <none> <none>

kube-system csi-azurefile-node-h75gq 3/3 Running 0 3d11h 10.240.0.4 aks-nodepool1-31721111-vmss000000 <none> <none>

kube-system konnectivity-agent-6cd55c69cf-2bbp5 1/1 Running 0 17m 10.240.0.7 aks-mynodepool-20823458-vmss000000 <none> <none>

kube-system konnectivity-agent-6cd55c69cf-7xzxj 1/1 Running 0 16m 10.240.0.8 aks-mynodepool-20823458-vmss000001 <none> <none>

kube-system kube-proxy-4wzx7 1/1 Running 0 10d 10.240.0.4 aks-nodepool1-31721111-vmss000000 <none> <none>

kube-system kube-proxy-7h8r5 1/1 Running 0 49m 10.240.0.7 aks-mynodepool-20823458-vmss000000 <none> <none>

kube-system kube-proxy-g5tvr 1/1 Running 0 10d 10.240.0.6 aks-nodepool1-31721111-vmss000002 <none> <none>

kube-system kube-proxy-mrv54 1/1 Running 0 10d 10.240.0.5 aks-nodepool1-31721111-vmss000001 <none> <none>

kube-system kube-proxy-nqmnj 1/1 Running 0 49m 10.240.0.9 aks-mynodepool-20823458-vmss000002 <none> <none>

kube-system kube-proxy-zn77s 1/1 Running 0 49m 10.240.0.8 aks-mynodepool-20823458-vmss000001 <none> <none>

kube-system metrics-server-774f99dbf4-2x6x8 1/1 Running 0 16m 10.244.4.4 aks-mynodepool-20823458-vmss000002 <none> <none>

Resolução de Problemas

Poderá ver um erro como o seguinte:

Erro ao remover pods/[podname] -n [namespace] (tentará novamente após 5s): Não é possível remover pod, pois isso violaria o orçamento de interrupção do pod.

Por padrão, seu cluster tem AKS_managed orçamentos de interrupção de pod (como coredns-pdb ou konnectivity-agent) com um MinAvailable de 1. Se, por exemplo, houver dois coredns pods em execução, enquanto um deles está sendo recriado e está indisponível, o outro não pode ser afetado devido ao orçamento de interrupção do pod. Isso se resolve depois que o pod inicial coredns é programado e executado, permitindo que o segundo pod seja devidamente removido e recriado.

Gorjeta

Considere drenar nós um a um para uma experiência de remoção mais suave e evitar limitação. Para obter mais informações, consulte:

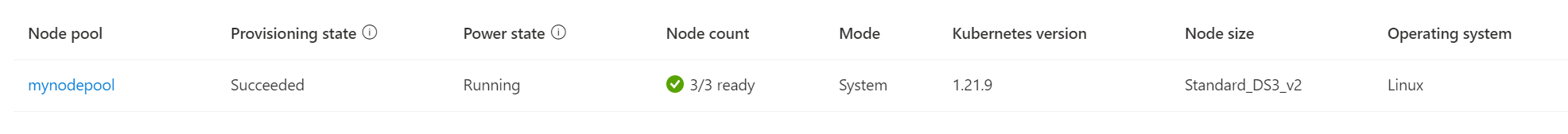

Remover o pool de nós existente

Para excluir o pool de nós existente, use o portal do Azure ou o az aks nodepool delete comando:

az aks nodepool delete \

--resource-group myResourceGroup \

--cluster-name myAKSCluster \

--name nodepool1

Após a conclusão, o resultado final é o cluster AKS ter um único e novo pool de nós com o novo tamanho de SKU desejado e todos os aplicativos e pods funcionando corretamente:

kubectl get nodes

NAME STATUS ROLES AGE VERSION

aks-mynodepool-20823458-vmss000000 Ready agent 63m v1.21.9

aks-mynodepool-20823458-vmss000001 Ready agent 63m v1.21.9

aks-mynodepool-20823458-vmss000002 Ready agent 63m v1.21.9

Próximos passos

Depois de redimensionar um pool de nós por cordão e drenagem, saiba mais sobre como usar vários pools de nós.

Azure Kubernetes Service