Use benchmarks em um espaço Genie

Este artigo explica como usar benchmarks para avaliar a precisão do seu espaço Genie.

Visão geral

Os benchmarks permitem que você crie uma set de perguntas de teste que você pode executar para avaliar a precisão geral da resposta do Genie. Uma set de benchmarks bem projetada, cobrindo as perguntas mais frequentes do usuário, ajuda a avaliar a precisão do seu espaço Genie à medida que você o refina.

As perguntas de referência funcionam como novas conversas. Eles não carregam o mesmo contexto de uma conversa encadeada do Genie. Cada pergunta é processada como uma nova consulta, usando as instruções definidas no espaço, incluindo qualquer exemplo fornecido de funções SQL e SQL.

Adicionar perguntas de referência

As perguntas de referência devem refletir diferentes maneiras de formular as perguntas comuns que seus usuários fazem. Você pode usá-los para verificar a resposta do Genie a variações no fraseado das perguntas ou diferentes formatos de perguntas.

Ao criar uma pergunta de referência, você pode, opcionalmente, incluir uma consulta SQL cujo resultado set é a resposta correta. Durante as execuções de benchmark, a precisão é avaliada comparando o resultado set da sua consulta SQL com o gerado pelo Genie.

Para adicionar uma pergunta de referência, execute as seguintes etapas:

Clique na

barra lateral esquerda em um espaço do Genie.

barra lateral esquerda em um espaço do Genie.Clique na guia Perguntas . Em seguida, clique em Adicionar benchmark.

No campo Pergunta, insira uma pergunta de referência para testar.

(Opcional) Insira a instrução SQL que responde com precisão à pergunta inserida.

Nota

Esta etapa é recomendada. Somente as perguntas que incluem este exemplo de instrução SQL podem ser avaliadas automaticamente quanto à precisão. Quaisquer perguntas que não incluam uma Resposta SQL requerem revisão manual para serem pontuadas.

(Opcional) Clique Executar para executar a consulta e visualizar os resultados.

Quando terminar de editar, clique em Adicionar benchmark.

Para

uma pergunta depois de salvar, clique no ícone Editar .

Use benchmarks para testar frases de perguntas alternativas

Ao avaliar a precisão do seu espaço Genie, é importante estruturar testes para refletir cenários realistas. Os usuários podem fazer a mesma pergunta de maneiras diferentes. O Databricks recomenda adicionar vários sintagmas da mesma pergunta e usar o mesmo exemplo SQL em seus testes de benchmark para avaliar totalmente a precisão. A maioria dos espaços Genie deve incluir 2 a 4 frases da mesma pergunta.

Executar perguntas de benchmark

Os usuários com pelo menos permissões CAN EDIT em um espaço Genie podem criar uma execução de benchmark a qualquer momento, que será avaliada automaticamente em todas as perguntas de benchmark. Para avaliar cada pergunta de benchmark, primeiro enviaremos a pergunta ao Genie e, em seguida, compararemos os resultados do Genie com o benchmark. Um dos seguintes rótulos é aplicado a cada índice de referência:

- Bom: as respostas são marcadas com esse rótulo quando o resultado da consulta gerado pelo Genie corresponde aos resultados da Resposta SQL fornecida. Quando uma resposta é marcada Bom, significa que a linha values corresponde mesmo, independentemente da ordem da classificação ou dos nomes column.

- Precisa de revisão: as respostas são marcadas com este rótulo quando o Genie não pode avaliar a correção ou quando os resultados da consulta gerados pelo Genie não correspondem aos resultados da resposta SQL fornecida. Se houver alterações inesperadas nas dimensões tables na resposta gerada ou na resposta SQL fornecida, a pergunta pode ser marcada para revisão. Todas as perguntas de referência que não incluam uma Resposta SQL devem ser revisadas manualmente.

-

Ruim: as respostas nunca são automaticamente rotuladas como Ruins. Se os resultados da consulta gerados pelo Genie não corresponderem ao resultado

da Resposta SQLfornecida pelo , a pergunta é marcada com Precisa de revisão . Ao revisar esses benchmarks, você pode marcar um resultado como Ruim se achar que os resultados da consulta gerados pelo Genie não respondem à pergunta.

Para executar todas as perguntas de referência:

- Clique em

Benchmarks na barra lateral do espaço Genie, perto do lado esquerdo da tela.

Benchmarks na barra lateral do espaço Genie, perto do lado esquerdo da tela. - Clique em Executar benchmarks para iniciar a execução do teste.

Nota

Se você fechar esta página, a execução do benchmark será pausada automaticamente. Você pode retomar o teste quando reabrir a página.

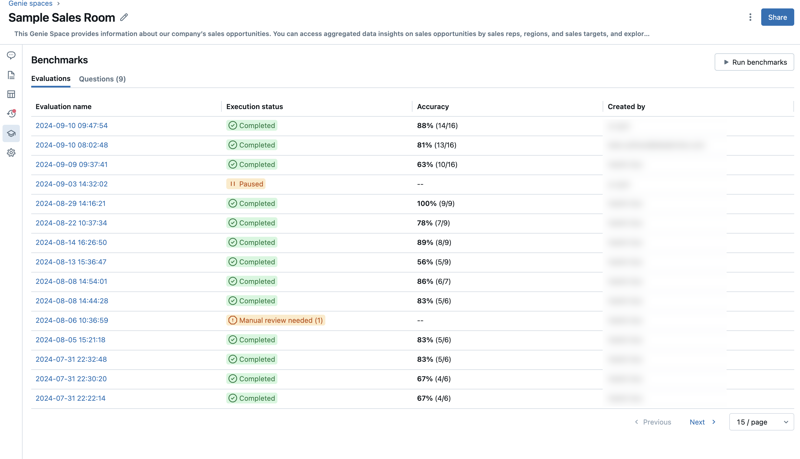

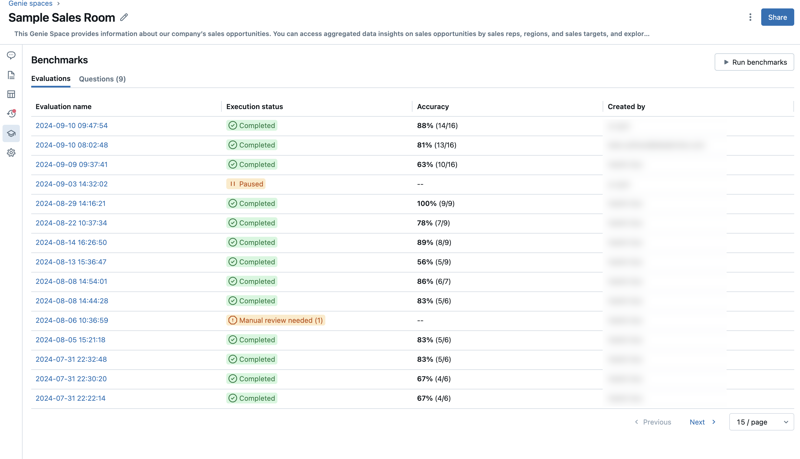

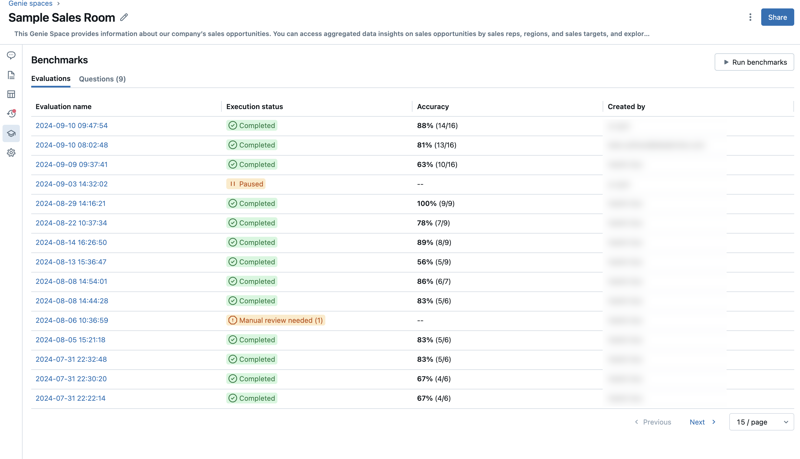

Aceda a avaliações de benchmark

Você pode acessar todas as suas avaliações de benchmark para acompanhar a precisão em seu espaço Genie ao longo do tempo. Quando clicas no ícone ![]() na barra lateral esquerda num espaço Genie, uma execução de avaliação com carimbo de data e hora list aparece no separador Avaliações. Se nenhuma execução de avaliação for encontrada, consulta Adicionar perguntas de benchmark ou Executar perguntas de benchmark.

na barra lateral esquerda num espaço Genie, uma execução de avaliação com carimbo de data e hora list aparece no separador Avaliações. Se nenhuma execução de avaliação for encontrada, consulta Adicionar perguntas de benchmark ou Executar perguntas de benchmark.

A guia Avaliações mostra uma visão geral das avaliações e do seu desempenho, conforme reportado nas seguintes categorias:

Nome da avaliação: um carimbo de data/hora que indica quando ocorreu uma execução de avaliação. Clique no carimbo de data/hora para ver os detalhes dessa avaliação. Status de execução: Indica se a avaliação foi concluída, pausada ou malsucedida. Se uma execução de avaliação incluir perguntas de referência que não tenham respostas SQL predefinidas, ela será marcada para revisão neste column. Precisão: Uma avaliação numérica da precisão em todas as perguntas de referência. Para execuções de avaliação que exigem revisão manual, uma medida de precisão aparece somente depois que essas perguntas foram revisadas. Criado por: Indica o nome do usuário que executou a avaliação.

Rever avaliações individuais

Você pode revisar avaliações individuais para get uma visão detalhada de cada resposta. Você pode editar a avaliação para qualquer pergunta e update quaisquer itens que precisem de revisão manual.

Para rever avaliações individuais:

Clique em

Benchmarks na barra lateral do espaço Genie, perto do lado esquerdo da tela.

Benchmarks na barra lateral do espaço Genie, perto do lado esquerdo da tela.Clique no timestamp de qualquer avaliação no Nome da avaliação column para abrir uma exibição detalhada dessa execução de teste.

Clique numa pergunta junto ao lado esquerdo do ecrã para ver os detalhes associados. Use a tela de detalhes da avaliação e execute as próximas etapas.

Analise e compare a resposta de saída do modelo com a resposta de verdade do solo.

Nota

Os resultados destas respostas aparecem nos detalhes da avaliação durante uma semana. Após uma semana, os resultados já não são visíveis. A instrução SQL gerada e a instrução SQL de exemplo permanecem.

Clique no

rótulo para editar a avaliação.

rótulo para editar a avaliação.Marque cada resultado como Bom ou Ruim para get uma pontuação precisa para esta avaliação.