Tutorial Lakehouse: Ingerir dados na lakehouse

Neste tutorial, você ingere mais tabelas dimensionais e de fatos da Wide World Importers (WWI) na casa do lago.

Pré-requisitos

- Se você não tem uma casa de lago, você deve criar uma casa de lago.

Ingerir dados

Nesta seção, você usa a atividade Copiar dados do pipeline do Data Factory para ingerir dados de exemplo de uma conta de armazenamento do Azure para a seção Arquivos da casa do lago criada anteriormente.

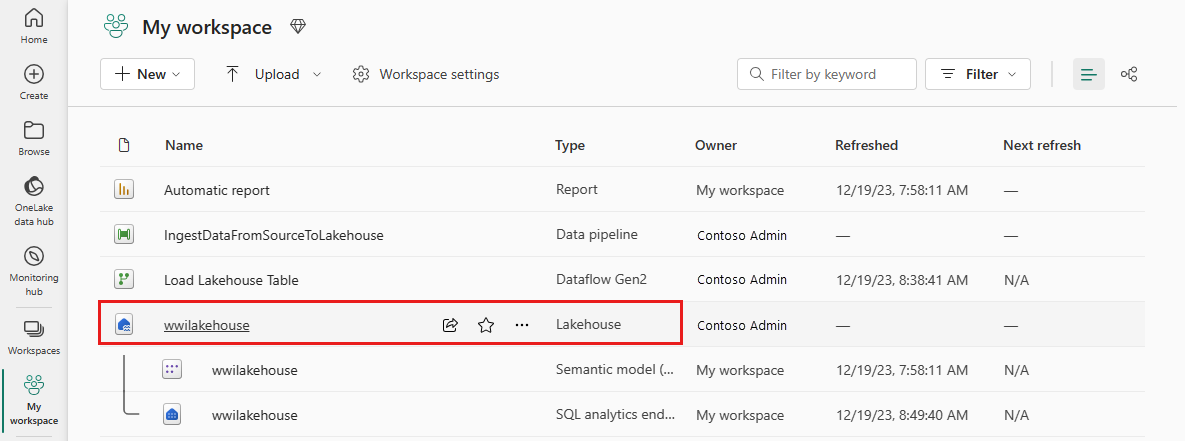

Selecione Espaços de trabalho no painel de navegação esquerdo e, em seguida, selecione o novo espaço de trabalho no menu Espaços de trabalho. A vista de itens da sua área de trabalho é apresentada.

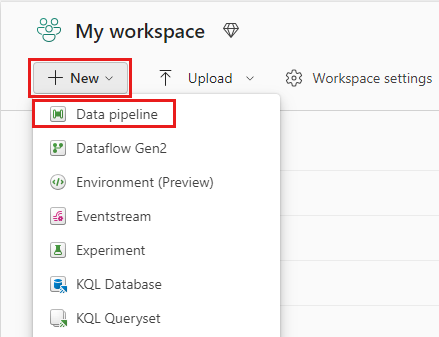

No item de menu +Novo na faixa de opções do espaço de trabalho, selecione Pipeline de dados.

Na caixa de diálogo Novo pipeline, especifique o nome como IngestDataFromSourceToLakehouse e selecione Criar. Um novo pipeline de data factory é criado e aberto.

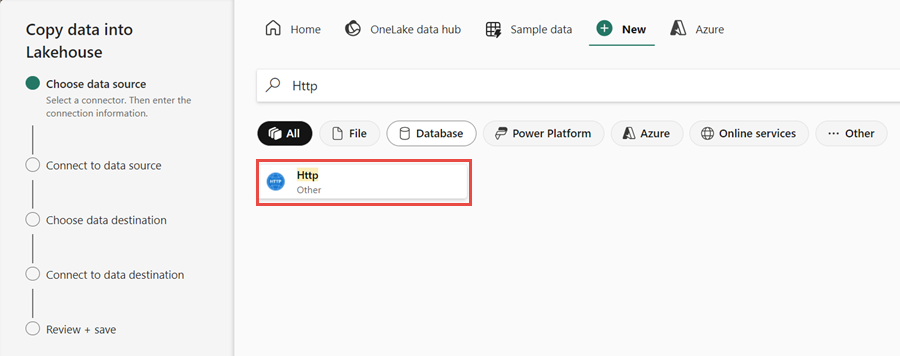

Em seguida, configure uma conexão HTTP para importar os dados de exemplo do World Wide Importers para o Lakehouse. Na lista de Novas fontes, selecione Ver mais, procure por Http e selecione-o.

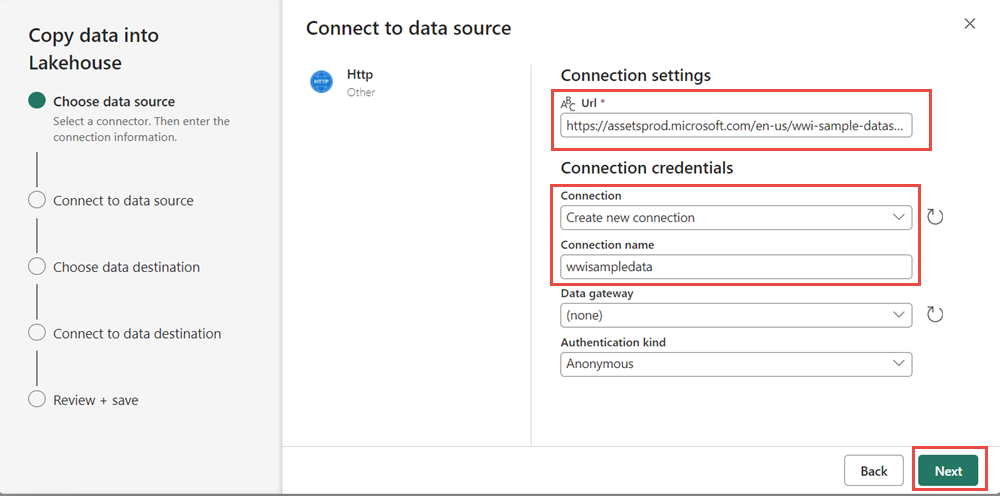

Na janela Conectar à fonte de dados, insira os detalhes da tabela abaixo e selecione Avançar.

Property valor URL https://assetsprod.microsoft.com/en-us/wwi-sample-dataset.zipConnection Criar uma nova ligação Nome da ligação wwisampledata Gateway de dados Nenhuma Tipo de autenticação Anónimo

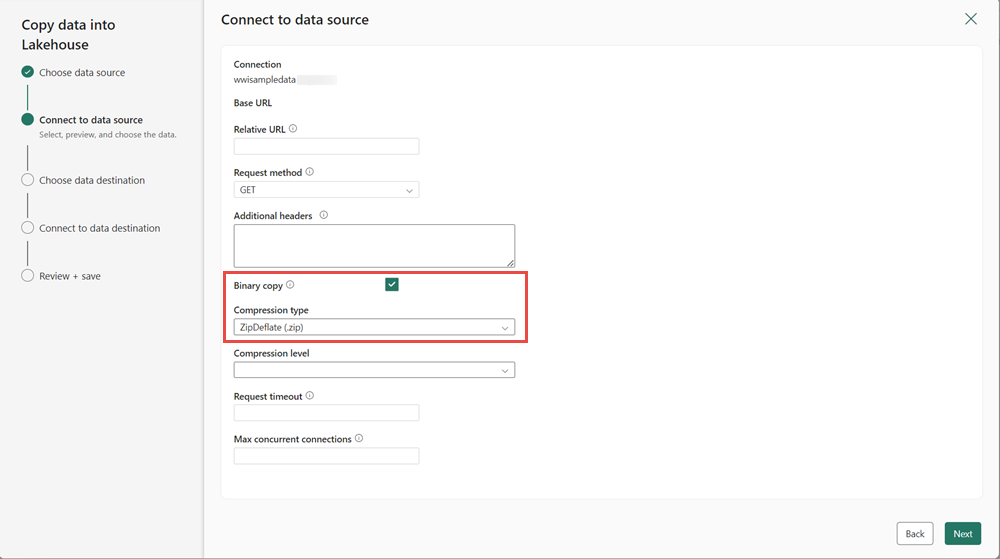

Na próxima etapa, habilite a cópia binária e escolha ZipDeflate (.zip) como o tipo de compactação, já que a origem é um arquivo .zip. Mantenha os outros campos em seus valores padrão e clique em Avançar.

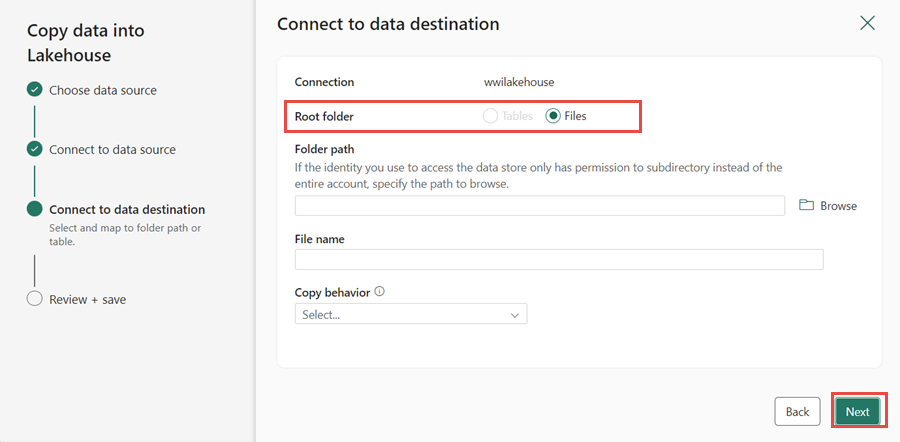

Na janela Conectar ao destino de dados, especifique a pasta raiz como Arquivos e clique em Avançar. Isso gravará os dados na seção Arquivos da casa do lago.

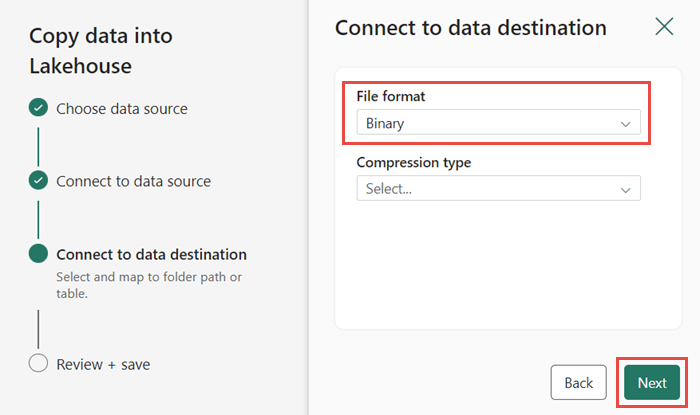

Escolha o formato de arquivo como binário para o destino. Clique em Avançar e, em seguida, em Salvar+Executar. Você pode agendar pipelines para atualizar dados periodicamente. Neste tutorial, executamos o pipeline apenas uma vez. O processo de cópia de dados leva aproximadamente 10-15 minutos para ser concluído.

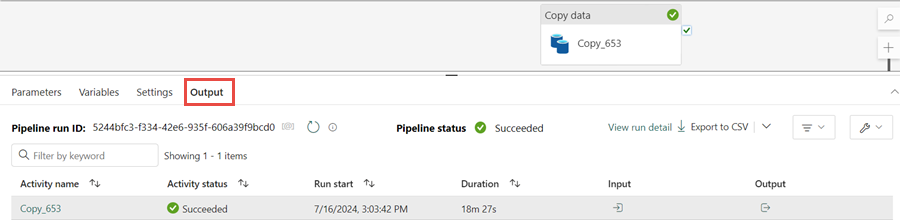

Você pode monitorar a execução e a atividade do pipeline na guia Saída . Você também pode visualizar informações detalhadas de transferência de dados selecionando o ícone de óculos ao lado do nome do pipeline, que aparece quando você passa o mouse sobre o nome.

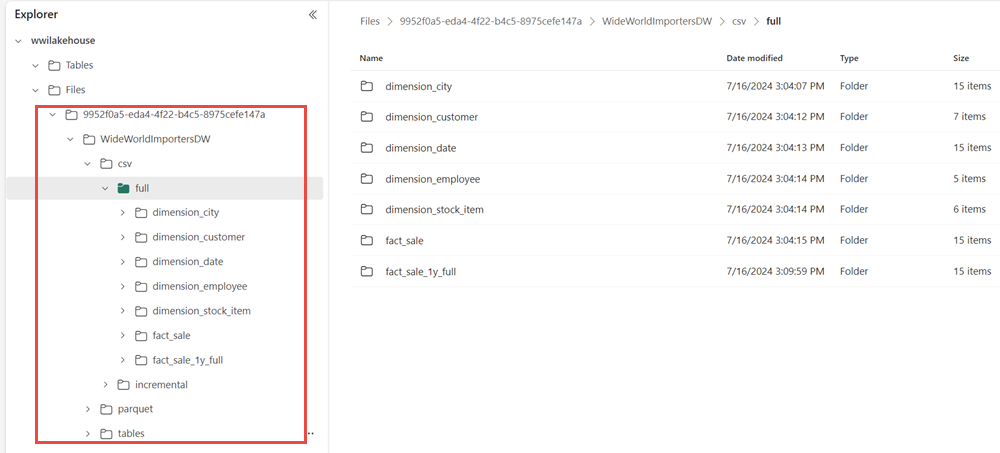

Após a execução bem-sucedida do pipeline, vá para sua lakehouse (wwilakehouse) e abra o explorador para ver os dados importados.

Verifique se a pasta WideWorldImportersDW está presente na visualização Explorer e contém dados para todas as tabelas.

Os dados são criados na seção Arquivos do explorador lakehouse. Uma nova pasta com GUID contém todos os dados necessários. Renomeie o GUID para wwi-raw-data

Para carregar dados incrementais em uma lakehouse, consulte Carregar incrementalmente dados de um data warehouse para uma lakehouse.