Como usar o Data Wrangler no Spark DataFrames

O Data Wrangler, uma ferramenta baseada em notebook para análise exploratória de dados, agora suporta Spark DataFrames e pandas DataFrames. Ele gera código PySpark, além do código Python. Para obter uma visão geral do Data Wrangler, abordando como explorar e transformar pandas DataFrames, visite o tutorial principal. Este tutorial mostra como usar o Data Wrangler para explorar e transformar DataFrames do Spark.

Pré-requisitos

Obtenha uma assinatura do Microsoft Fabric. Ou inscreva-se para uma avaliação gratuita do Microsoft Fabric.

Entre no Microsoft Fabric.

Use o seletor de experiência no lado esquerdo da sua página inicial para alternar para a experiência Synapse Data Science.

Limitações

- Atualmente, as operações de código personalizado são suportadas apenas para pandas DataFrames.

- A tela do Data Wrangler funciona melhor em monitores grandes, embora você possa minimizar ou ocultar diferentes partes da interface, para acomodar telas menores.

Iniciando o Data Wrangler com um DataFrame Spark

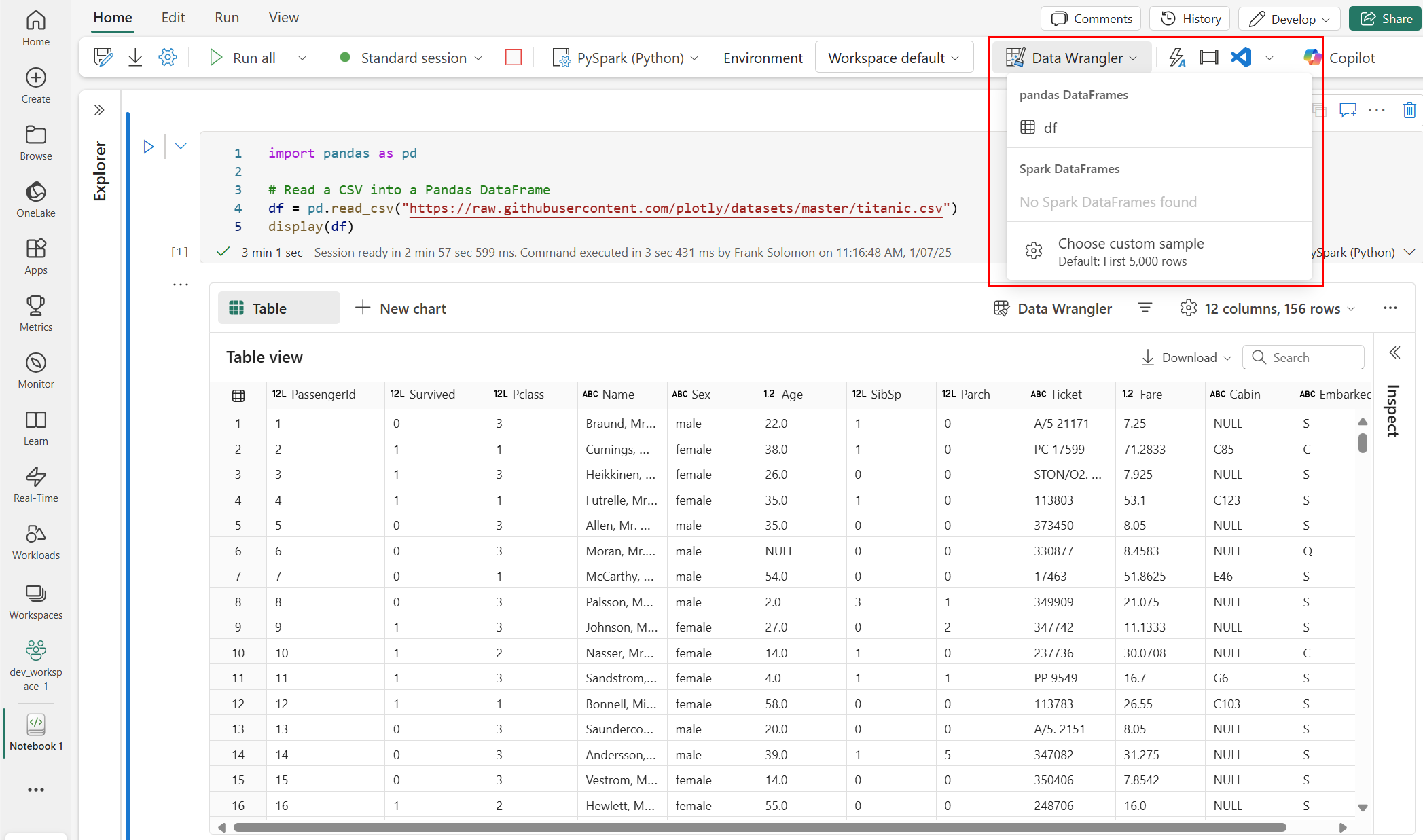

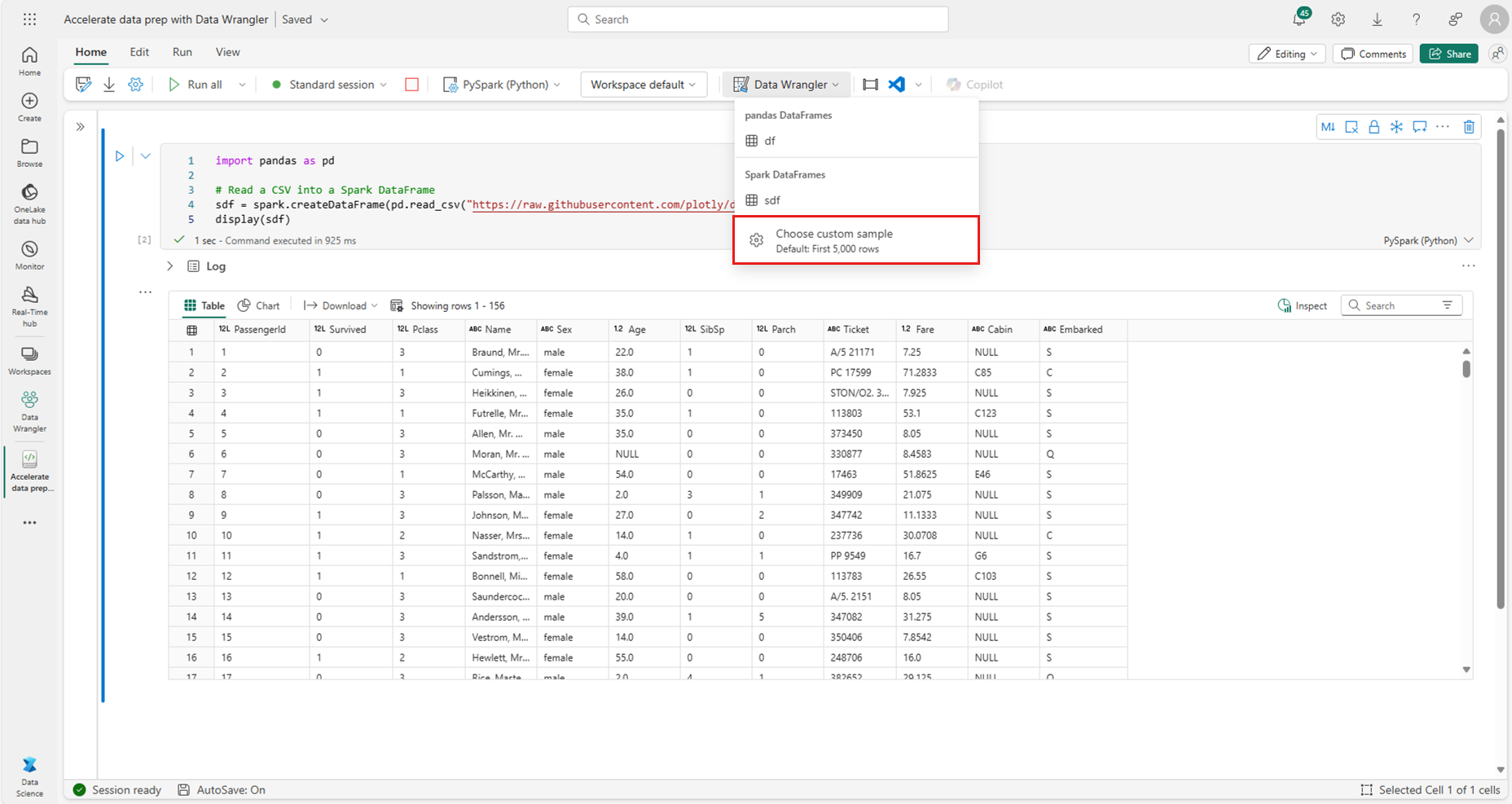

Os usuários podem abrir o Spark DataFrames no Data Wrangler diretamente de um bloco de anotações do Microsoft Fabric, navegando até o mesmo prompt suspenso onde os pandas DataFrames são exibidos. Uma lista de Spark DataFrames ativos aparece na lista suspensa abaixo da lista de variáveis pandas ativas.

Este trecho de código cria um DataFrame do Spark com os mesmos dados de exemplo usados no tutorial do Pandas Data Wrangler:

import pandas as pd

# Read a CSV into a Spark DataFrame

sdf = spark.createDataFrame(pd.read_csv("https://raw.githubusercontent.com/plotly/datasets/master/titanic.csv"))

display(sdf)

Na guia "Página inicial" da faixa de opções do bloco de anotações, use o prompt suspenso do Data Wrangler para procurar DataFrames ativos disponíveis para edição. Selecione o que deseja abrir no Data Wrangler.

Gorjeta

O Data Wrangler não pode ser aberto enquanto o kernel do notebook estiver ocupado. Uma célula de execução deve terminar sua execução antes que o Data Wrangler possa ser iniciado, conforme mostrado nesta captura de tela:

Escolhendo amostras personalizadas

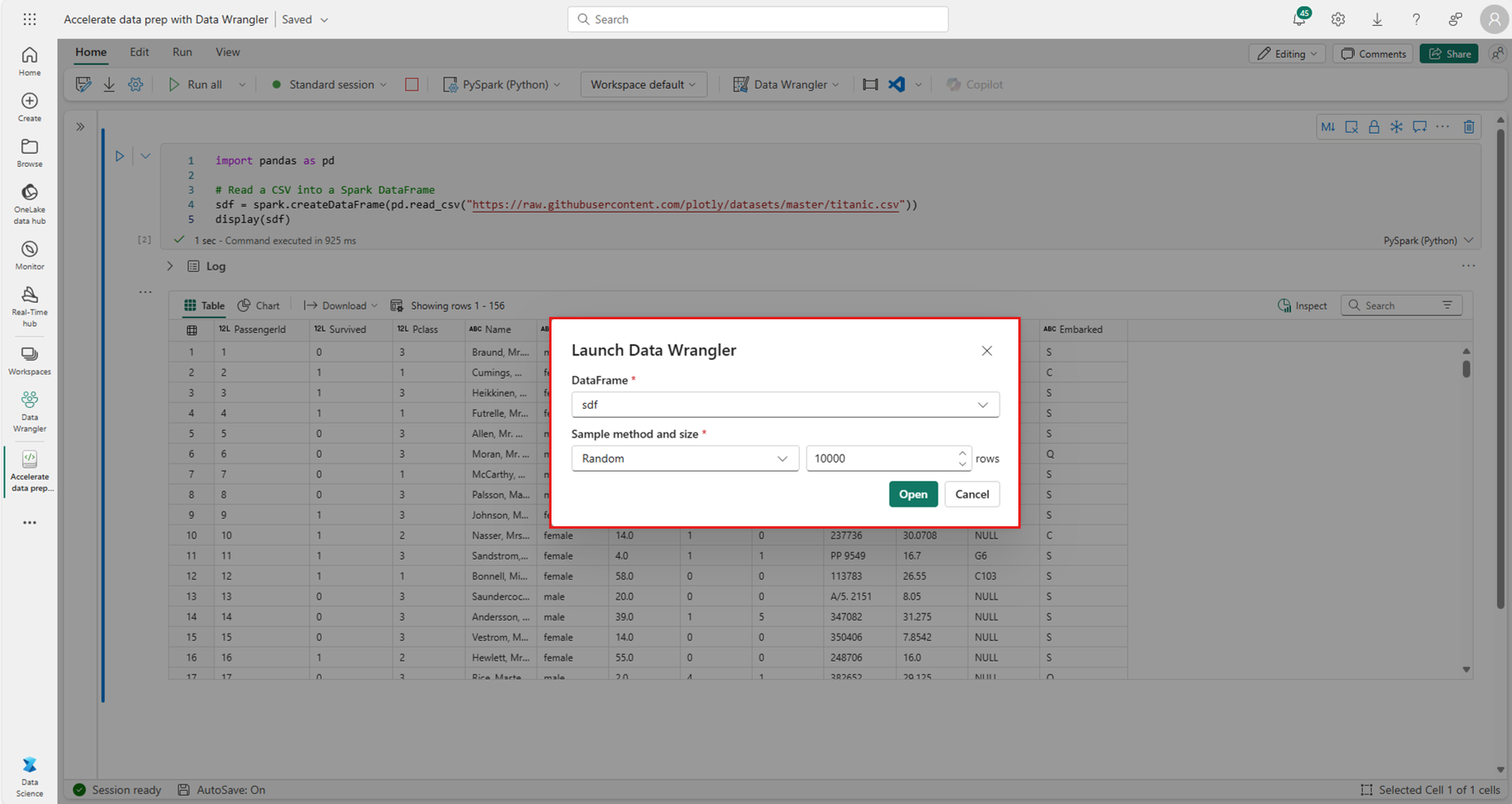

O Data Wrangler converte automaticamente Spark DataFrames em amostras de pandas por motivos de desempenho. No entanto, todo o código que a ferramenta gera é finalmente traduzido para o PySpark quando ele exporta de volta para o notebook. Como com qualquer Pandas DataFrame, você pode personalizar o exemplo padrão. Para abrir uma amostra personalizada de qualquer DataFrame ativo com o Data Wrangler, selecione "Choose custom sample" na lista suspensa, conforme mostrado nesta captura de tela:

Isso inicia um pop-up com opções para especificar o tamanho da amostra desejada (número de linhas) e o método de amostragem (primeiros registros, últimos registros ou um conjunto aleatório), conforme mostrado nesta captura de tela:

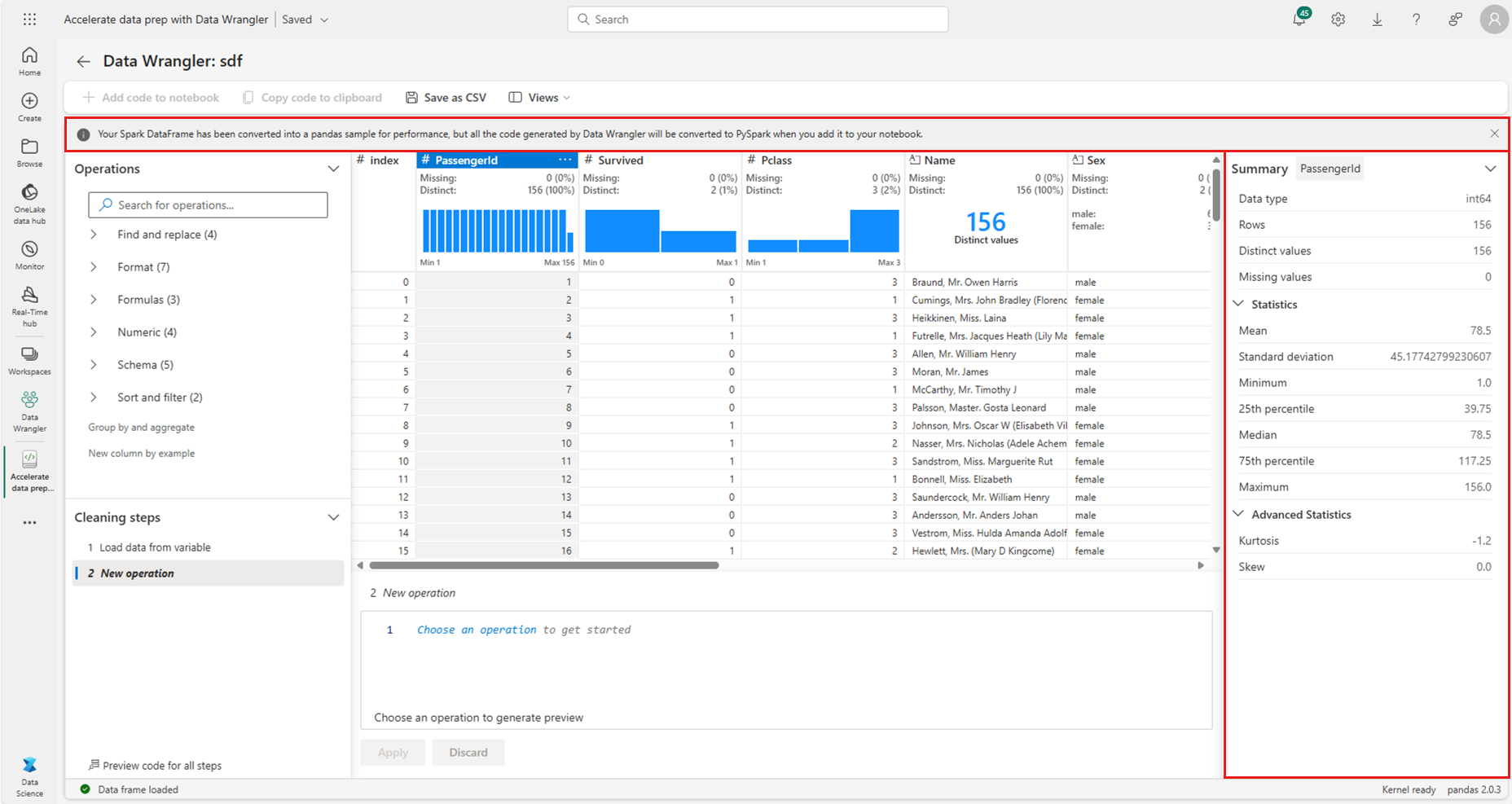

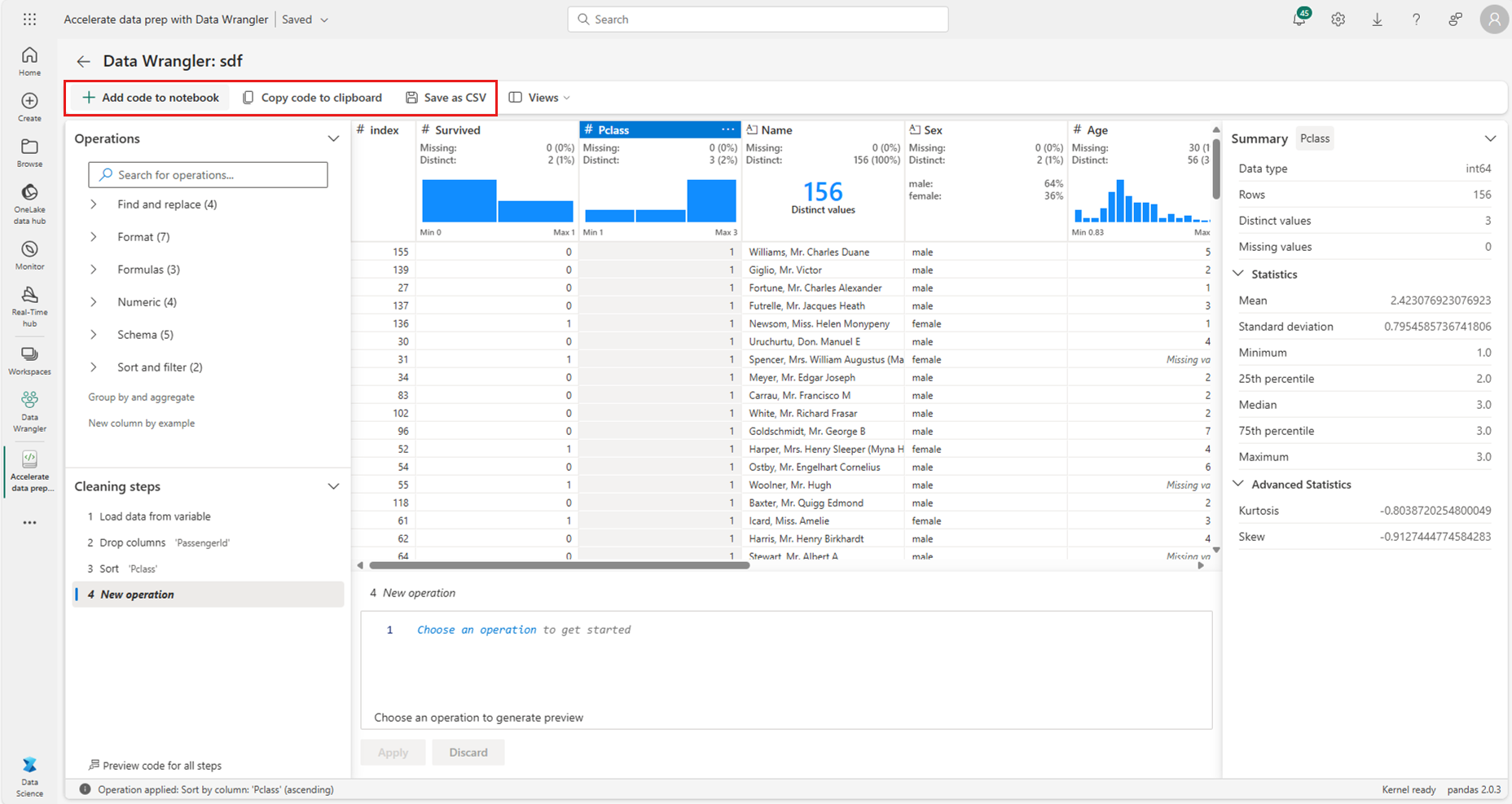

Visualizar estatísticas de resumo

Quando o Data Wrangler é carregado, ele exibe um banner informativo acima da grade de visualização. Este banner explica que os Spark DataFrames são temporariamente convertidos em amostras de pandas, mas todo o código gerado é finalmente convertido em PySpark. Passado isso, usar o Data Wrangler no Spark DataFrames não é diferente de usá-lo em pandas DataFrames. Uma visão geral descritiva no painel "Resumo" exibe informações sobre as dimensões da amostra, valores ausentes e muito mais. A seleção de qualquer coluna na grade do Data Wrangler solicita que o painel "Resumo" atualize e exiba estatísticas descritivas sobre essa coluna específica. Informações rápidas sobre cada coluna também estão disponíveis em seu cabeçalho.

Gorjeta

As estatísticas e visuais específicos da coluna (tanto no painel "Resumo" quanto nos cabeçalhos das colunas) dependem do tipo de dados da coluna. Por exemplo, um histograma vinculado de uma coluna numérica aparecerá no cabeçalho da coluna somente se a coluna for convertida como um tipo numérico, conforme mostrado nesta captura de tela:

Navegando pelas operações de limpeza de dados

Uma lista pesquisável de etapas de limpeza de dados pode ser encontrada no painel "Operações". No painel "Operações", a seleção de uma etapa de limpeza de dados solicita que você forneça uma coluna ou colunas de destino, juntamente com quaisquer parâmetros necessários para concluir a etapa. Por exemplo, o prompt para dimensionar numericamente uma coluna requer um novo intervalo de valores, conforme mostrado nesta captura de tela:

Gorjeta

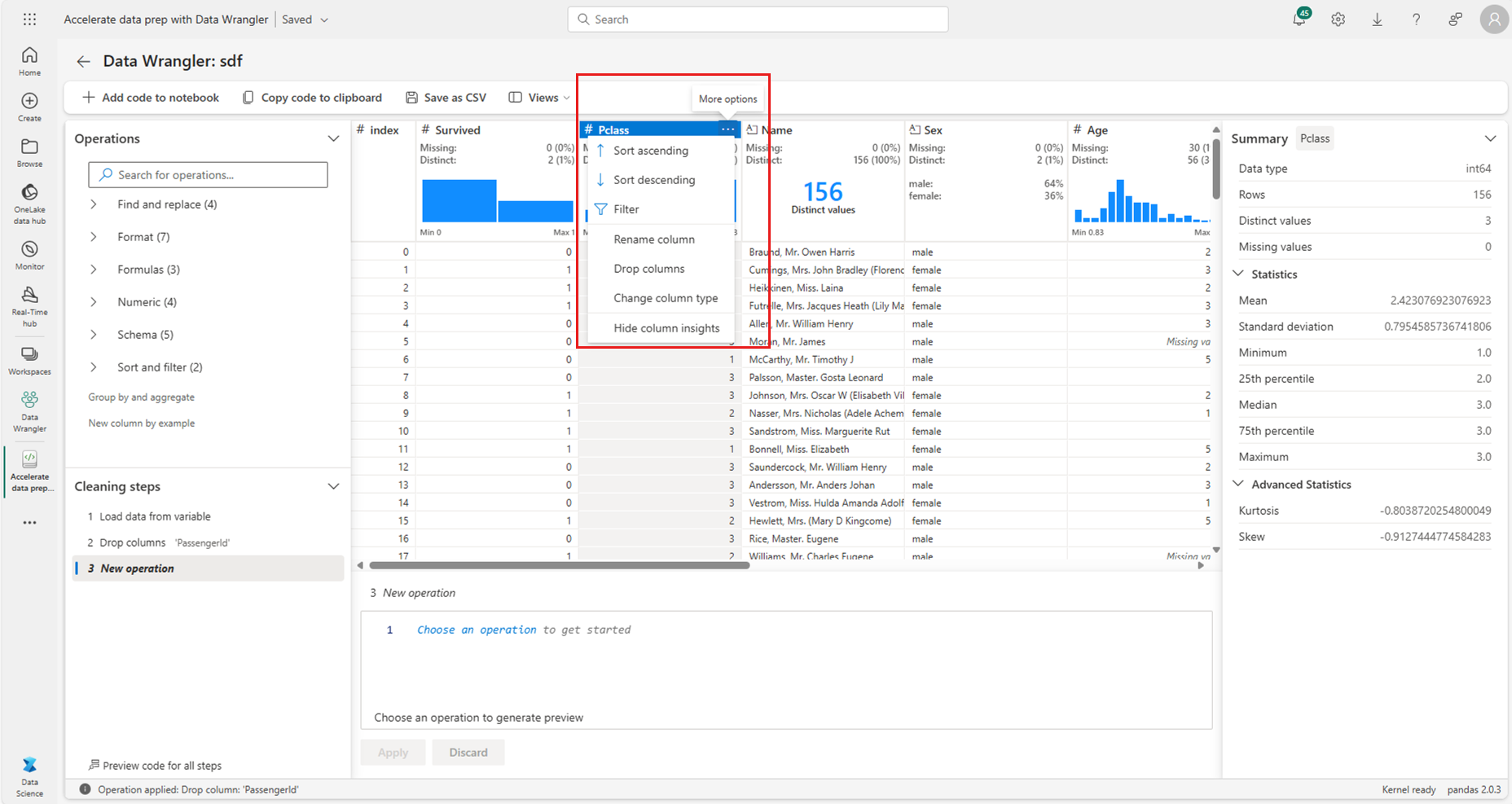

Você pode aplicar uma seleção menor de operações no menu de cada cabeçalho de coluna, conforme mostrado nesta captura de tela:

Pré-visualização e aplicação de operações

A grade de exibição do Data Wrangler visualiza automaticamente os resultados de uma operação selecionada e o código correspondente aparece automaticamente no painel abaixo da grade. Para confirmar o código visualizado, selecione "Aplicar" em qualquer um dos locais. Para excluir o código visualizado e tentar uma nova operação, selecione "Descartar", conforme mostrado nesta captura de tela:

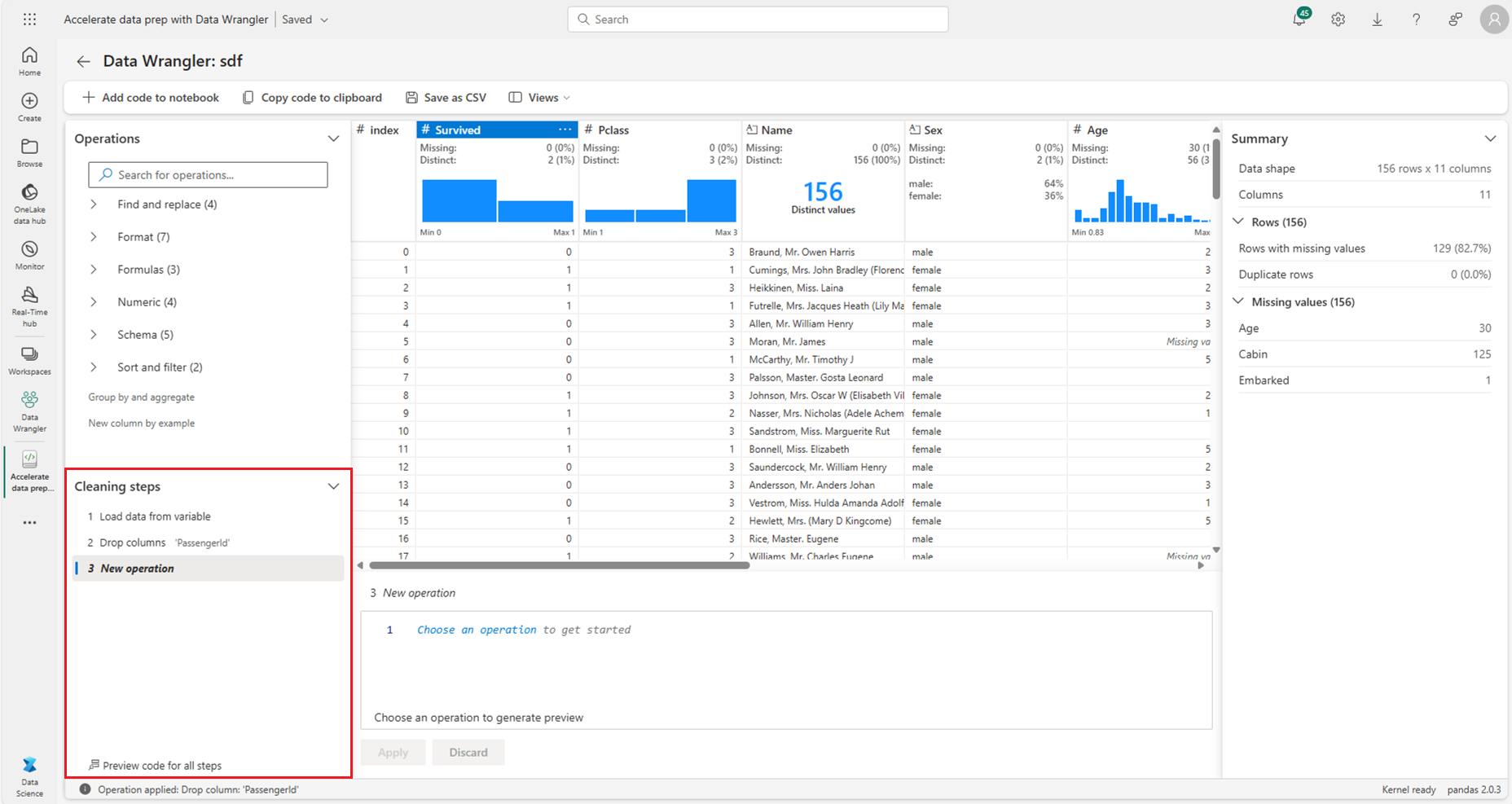

Depois que uma operação é aplicada, a grade de exibição do Data Wrangler e as estatísticas resumidas são atualizadas para refletir os resultados. O código aparece na lista em execução de operações confirmadas, localizada no painel "Etapas de limpeza", conforme mostrado nesta captura de tela:

Gorjeta

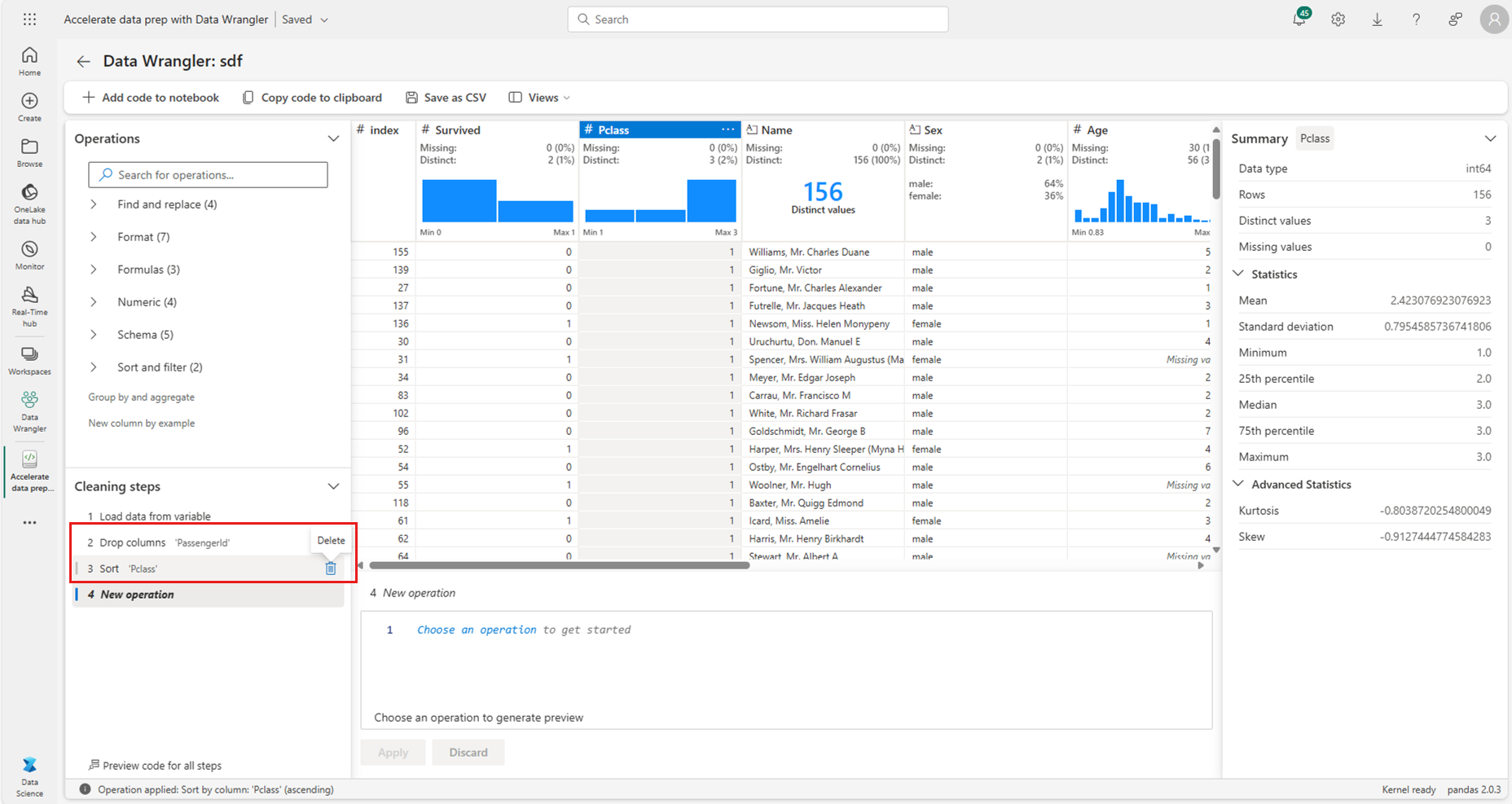

Você sempre pode desfazer a etapa aplicada mais recentemente. No painel "Etapas de limpeza", um ícone de lixeira aparecerá se você passar o cursor sobre a etapa aplicada mais recentemente, conforme mostrado nesta captura de tela:

Esta tabela resume as operações que o Data Wrangler suporta atualmente:

| Operação | Descrição |

|---|---|

| Ordenação | Ordenar uma coluna por ordem crescente ou decrescente |

| Filtro | Filtrar linhas com base em uma ou mais condições |

| Codificação a quente | Crie novas colunas para cada valor exclusivo em uma coluna existente, indicando a presença ou ausência desses valores por linha |

| Codificação a quente com delimitador | Dividir e codificar dados categóricos usando um delimitador |

| Alterar o tipo de coluna | Alterar o tipo de dados de uma coluna |

| Soltar coluna | Excluir uma ou mais colunas |

| Selecionar coluna | Escolha uma ou mais colunas para manter e exclua o restante |

| Renomear coluna | Renomear uma coluna |

| Soltar valores ausentes | Remover linhas com valores em falta |

| Soltar linhas duplicadas | Soltar todas as linhas com valores duplicados em uma ou mais colunas |

| Preencher valores em falta | Substituir células com valores em falta por um novo valor |

| Localizar e substituir | Substituir células por um padrão de correspondência exato |

| Agrupar por coluna e agregar | Agrupar por coluna valores e agregar resultados |

| Espaço em branco da faixa | Remover espaços em branco do início e do fim do texto |

| Dividir texto | Dividir uma coluna em várias colunas com base em um delimitador definido pelo usuário |

| Converter texto em minúsculas | Converter texto em minúsculas |

| Converter texto em maiúsculas | Converter texto em maiúsculas |

| Valores mínimos/máximos da escala | Dimensionar uma coluna numérica entre um valor mínimo e máximo |

| Preenchimento relâmpago | Criar automaticamente uma nova coluna com base em exemplos derivados de uma coluna existente |

Modificar o ecrã

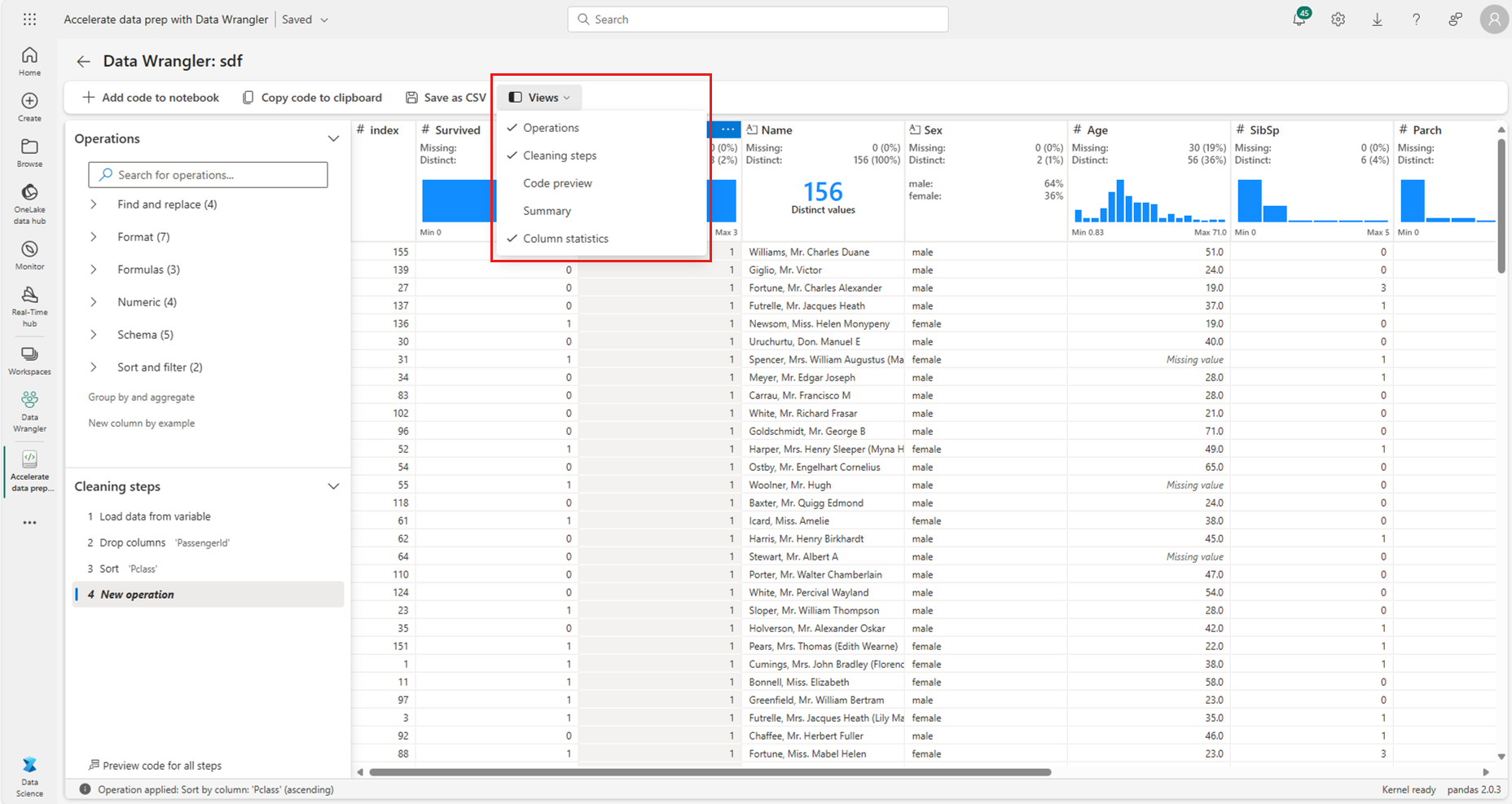

A qualquer momento, você pode personalizar a interface com a guia "Visualizações" na barra de ferramentas localizada acima da grade de exibição do Data Wrangler. Isso pode ocultar ou mostrar painéis diferentes com base em suas preferências e tamanho da tela, conforme mostrado nesta captura de tela:

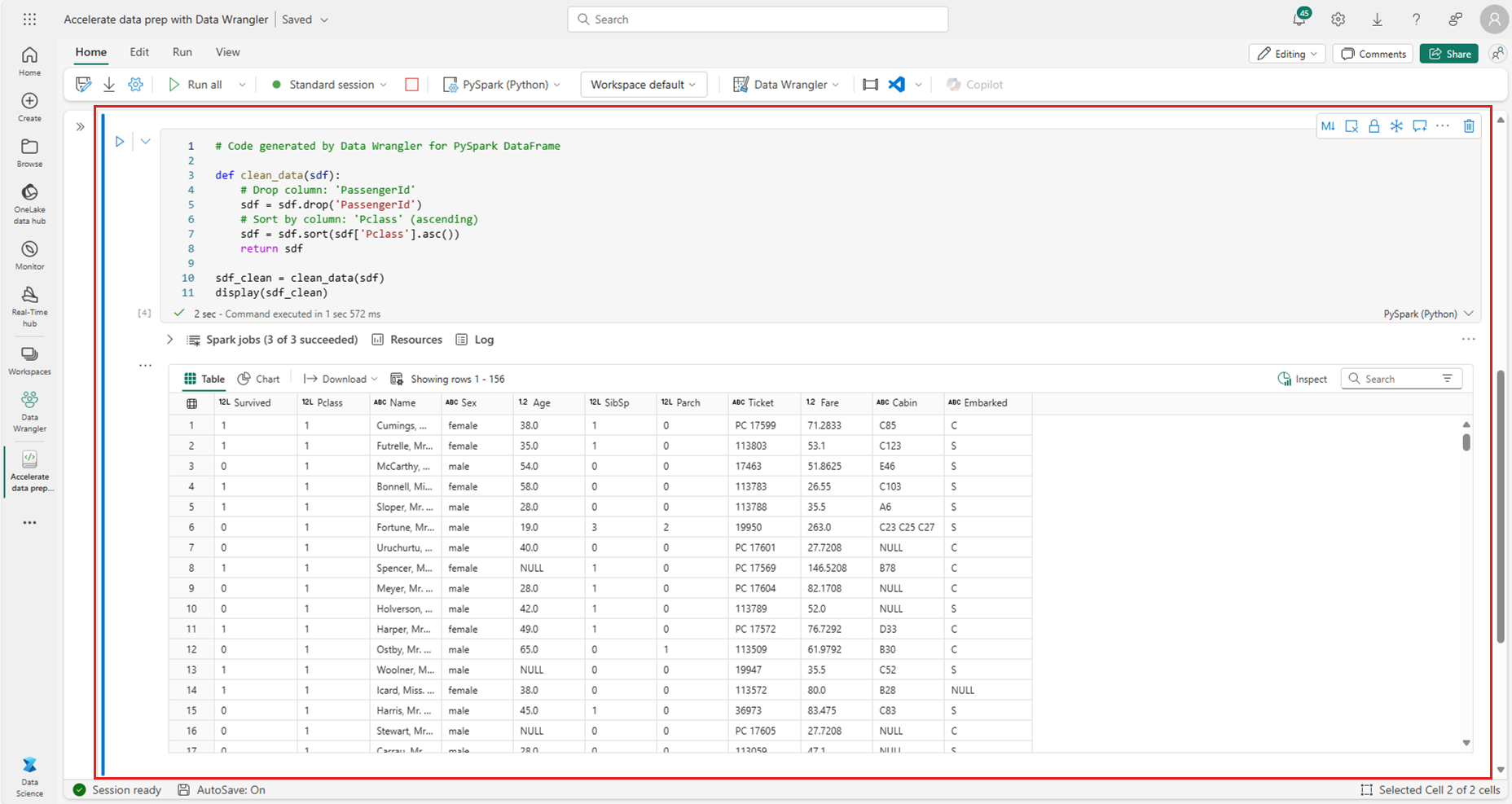

Guardar e exportar código

A barra de ferramentas acima da grade de exibição do Data Wrangler fornece opções para salvar o código gerado. Você pode copiar o código para a área de transferência ou exportá-lo para o bloco de anotações como uma função. Para o Spark DataFrames, todo o código gerado no exemplo de pandas é traduzido para o PySpark antes de voltar ao notebook. Antes do Data Wrangler fechar, a ferramenta exibe uma visualização do código PySpark traduzido e fornece uma opção para exportar o código intermediário dos pandas também.

Gorjeta

O Data Wrangler gera código que é aplicado somente quando você executa manualmente a nova célula e não substitui o DataFrame original, conforme mostrado nesta captura de tela:

O código é convertido em PySpark, como mostrado nesta captura de tela:

Em seguida, você pode executar esse código exportado, conforme mostrado nesta captura de tela:

Conteúdos relacionados

- Para obter uma visão geral do Data Wrangler, visite este artigo complementar

- Para experimentar o Data Wrangler no Visual Studio Code, vá para Data Wrangler no VS Code

- Perdemos um recurso que você precisa? Informe-nos! Sugira no fórum Fabric Ideas