Compreender e testar o modelo

Criámos um modelo de machine learning! Vamos testá-lo e dar uma olhada em como ele se sai bem.

Desempenho do modelo

A Visão Personalizada exibe três métricas quando você testa seu modelo. As métricas são indicadores que podem ajudá-lo a entender o desempenho do seu modelo. Os indicadores não indicam quão factual ou preciso é o modelo. Os indicadores informam apenas como o modelo se comportou nos dados fornecidos. O desempenho do modelo em dados conhecidos dá uma ideia de como o modelo será executado em novos dados.

As seguintes métricas são fornecidas para todo o modelo e para cada classe:

| Métrico | Description |

|---|---|

precision |

Se o seu modelo prevê uma etiqueta, esta métrica indica a probabilidade de a etiqueta correta ter sido prevista. |

recall |

Das tags que o modelo deve prever corretamente, essa métrica indica a porcentagem de tags que seu modelo previu corretamente. |

average precision |

Mede o desempenho do modelo calculando a precisão e a recuperação em diferentes limiares. |

Quando testamos nosso modelo de Visão Personalizada, veremos números para cada uma dessas métricas nos resultados do teste de iteração.

Erros comuns

Antes de testamos nosso modelo, vamos considerar alguns dos "erros de iniciante" a serem observados quando você começar a construir modelos de aprendizado de máquina.

Usando dados desequilibrados

Poderá ver este aviso quando implementar o seu modelo:

Unbalanced data detected. The distribution of images per tag should be uniform to ensure model performance.

Esse aviso indica que você não tem um número par de amostras para cada classe de dados. Embora você tenha várias opções nesse cenário, uma maneira comum de resolver dados desequilibrados é usar a SMOTE (Synthetic Minority Over-sampling Technique). O SMOTE duplica exemplos de treinamento do seu pool de treinamento existente.

Nota

No nosso modelo, poderá não ver este aviso, especialmente se tiver carregado uma fração do conjunto de dados. O subconjunto de dados do modelo Red-tailed Hawk (Dark morph) contém menos de 60 fotos em comparação com os outros modelos que têm mais de 100 fotos. Usar dados desequilibrados é algo a observar em qualquer modelo de aprendizado de máquina.

Sobremontagem do modelo

Se você não tiver dados suficientes ou se seus dados não forem diversificados o suficiente, seu modelo pode ficar sobreadaptado. Quando um modelo é sobreajustado, ele conhece bem o conjunto de dados fornecido e é sobreajustado aos padrões nesses dados. Nesse caso, o modelo tem um bom desempenho nos dados de treinamento, mas tem um desempenho ruim em novos dados que não viu antes. Por esta razão, usamos sempre novos dados para testar um modelo!

Usando dados de treinamento para testar

Como no overfitting, se você testar o modelo usando os mesmos dados que você usou para treinar o modelo, o modelo parece ter um bom desempenho. Mas, quando você implanta o modelo na produção, ele provavelmente terá um desempenho ruim.

Usando dados incorretos

Outro erro comum é usar dados incorretos para treinar o modelo. Alguns dados podem, na verdade, diminuir a precisão do seu modelo. Por exemplo, usar dados "barulhentos" pode diminuir a precisão de um modelo. Em dados barulhentos, muitas informações que não são úteis estão no conjunto de dados e causam confusão no modelo. Mais dados só são melhores se os dados forem bons dados que o modelo pode usar. Talvez seja necessário limpar dados ou remover recursos para melhorar a precisão do modelo.

Testar o modelo

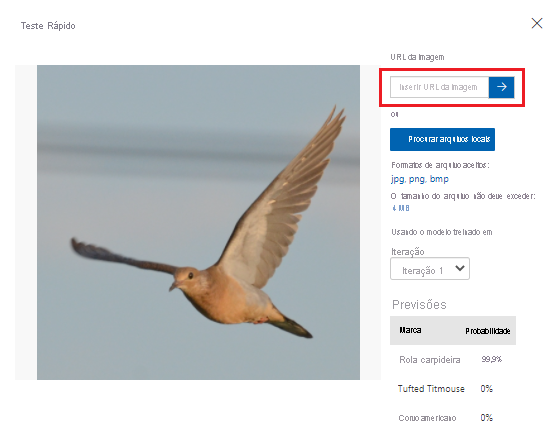

De acordo com as métricas que a Visão Personalizada fornece, nosso modelo está tendo um desempenho satisfatório. Vamos testar o nosso modelo e ver o seu desempenho com dados não vistos. Usaremos uma imagem de um pássaro de uma pesquisa na internet.

No seu browser, procure uma imagem de uma ave que corresponda a uma das espécies que treinou o modelo para reconhecer. Copie o URL da imagem.

No portal Visão Personalizada, selecione o projeto Classificação de Aves.

Na barra de menu superior, selecione Teste Rápido.

No Teste Rápido, cole o URL no URL da Imagem e pressione Enter para testar a precisão do modelo. A predição é apresentada na janela.

A Visão Personalizada analisa a imagem para testar a precisão do modelo e exibe os resultados:

No passo seguinte, vamos implementar o modelo. Depois que o modelo for implantado, poderemos fazer mais testes com um ponto de extremidade que criaremos.