Spark'ta Azure Machine Learning Not Defteri'ni kullanma

Not

31 Ocak 2025'te AKS'de Azure HDInsight'ı kullanımdan kaldırmaya devam edeceğiz. 31 Ocak 2025'den önce, iş yüklerinizin aniden sonlandırılmasını önlemek için iş yüklerinizi Microsoft Fabric'e veya eşdeğer bir Azure ürününe geçirmeniz gerekir. Aboneliğinizdeki kalan kümeler durdurulur ve konaktan kaldırılır.

Kullanımdan kaldırma tarihine kadar yalnızca temel destek sağlanacaktır.

Önemli

Bu özellik şu anda önizlemededir. Microsoft Azure Önizlemeleri için Ek Kullanım Koşulları, beta, önizleme aşamasında olan veya henüz genel kullanıma sunulmamış Azure özellikleri için geçerli olan daha fazla yasal hüküm içerir. Bu belirli önizleme hakkında bilgi için bkz . AKS üzerinde Azure HDInsight önizleme bilgileri. Sorular veya özellik önerileri için lütfen AskHDInsight'ta ayrıntıları içeren bir istek gönderin ve Azure HDInsight Topluluğu hakkında daha fazla güncelleştirme için bizi takip edin.

Makine öğrenmesi, bilgisayarların geçmiş verilerden otomatik olarak öğrenmesini sağlayan, büyüyen bir teknolojidir. Makine öğrenmesi, matematiksel modeller oluşturmak ve tahminlerde geçmiş verileri veya bilgileri kullanmak için çeşitli algoritmalar kullanır. Bazı parametrelere kadar tanımlanmış bir modelimiz var ve öğrenme, eğitim verilerini veya deneyimini kullanarak modelin parametrelerini iyileştirmek için bir bilgisayar programının yürütülmesidir. Model, gelecekte tahminde bulunmak için tahminde bulunabilir veya verilerden bilgi edinmek için açıklayıcı olabilir.

Aşağıdaki öğretici not defterinde tablo verileri üzerinde makine öğrenmesi modellerini eğiten bir örnek gösterilmektedir. Bu not defterini içeri aktarabilir ve kendiniz çalıştırabilirsiniz.

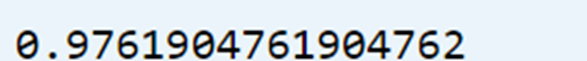

CSV'yi depolama alanınıza yükleme

Portal JSON görünümünde depolama alanınızı ve kapsayıcı adınızı bulma

Csv dosyasını karşıya yükleyerek birincil HDI depolama>kapsayıcısı>temel klasörünüzde> gezinme

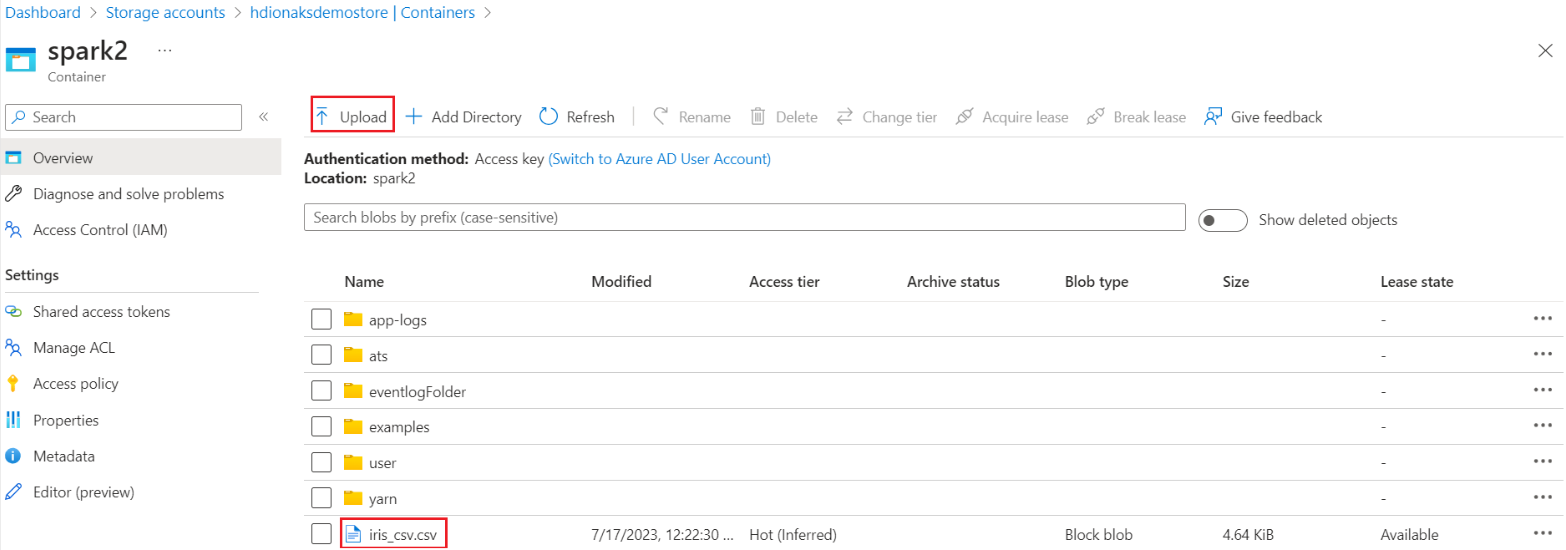

Kümenizde oturum açın ve Jupyter Not Defteri'ni açın

İşlem hattını oluşturmak için Spark MLlib Kitaplıklarını içeri aktarma

import pyspark from pyspark.ml import Pipeline, PipelineModel from pyspark.ml.classification import LogisticRegression from pyspark.ml.feature import VectorAssembler, StringIndexer, IndexToString

CSV'yi Spark veri çerçevesine okuma

df = spark.read.("abfss:///iris_csv.csv",inferSchema=True,header=True)Eğitim ve test için verileri bölme

iris_train, iris_test = df.randomSplit([0.7, 0.3], seed=123)İşlem hattını oluşturma ve modeli eğitma

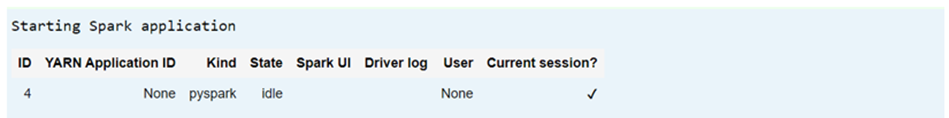

assembler = VectorAssembler(inputCols=['sepallength', 'sepalwidth', 'petallength', 'petalwidth'],outputCol="features",handleInvalid="skip") indexer = StringIndexer(inputCol="class", outputCol="classIndex", handleInvalid="skip") classifier = LogisticRegression(featuresCol="features", labelCol="classIndex", maxIter=10, regParam=0.01) pipeline = Pipeline(stages=[assembler,indexer,classifier]) model = pipeline.fit(iris_train) # Create a test `dataframe` with predictions from the trained model test_model = model.transform(iris_test) # Taking an output from the test dataframe with predictions test_model.take(1)

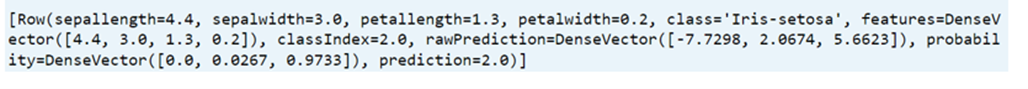

Model doğruluğunu değerlendirme

import pyspark.ml.evaluation as ev evaluator = ev.MulticlassClassificationEvaluator(labelCol='classIndex') print(evaluator.evaluate(test_model,{evaluator.metricName: 'accuracy'}))