Echtzeitanalysen können Ihnen helfen, schnelle Entscheidungen zu treffen und automatisierte Aktionen basierend auf aktuellen Erkenntnissen durchzuführen. Sie können Ihnen auch helfen, erweiterte Kundenerfahrungen zu bieten. In dieser Lösung wird beschrieben, wie Azure Synapse Analytics-Datenpools mit Änderungen der operativen Daten in MongoDB synchronisiert werden können.

Aufbau

Das folgende Diagramm zeigt, wie Sie die Echtzeitsynchronisierung von Atlas zu Azure Synapse Analytics implementieren. Dieser einfache Flow stellt sicher, dass alle Änderungen, die in der MongoDB Atlas-Sammlung auftreten, in das Standard-Azure Data Lake Storage-Repository im Azure Synapse Analytics-Arbeitsbereich repliziert werden. Nachdem sich die Daten im Data Lake Storage befinden, können Sie Azure Synapse Analytics-Pipelines verwenden, um die Daten abhängig von Ihren Analyseanforderungen an dedizierte SQL-Pools, Spark-Pools oder andere Lösungen zu pushen.

Laden Sie eine PowerPoint-Datei zu dieser Architektur herunter.

Datenfluss

Echtzeitänderungen im operativen Datenspeicher (ODS) von MongoDB Atlas werden erfasst und für Data Lake Storage in einem Azure Synapse Analytics-Arbeitsbereich für Echtzeit-Analyseanwendungsfälle, Liveberichte und Dashboards zur Verfügung zu stellen.

Datenänderungen im operativen/Transaktionsdatenspeicher von MongoDB werden von Atlas-Triggern erfasst.

Wenn ein Atlas-Datenbanktrigger ein Ereignis beobachtet, übergibt er den Änderungstyp und das Dokument, das geändert wird (vollständig oder Delta), an eine Atlas-Funktion.

Die Atlas-Funktion löst eine Azure-Funktion aus, übergibt das Änderungsereignis und ein JSON-Dokument.

Azure Functions verwendet die Data Lake-Clientbibliothek von Azure Storage Files, um das geänderte Dokument in den konfigurierten Data Lake Storage im Azure Synapse Analytics-Arbeitsbereich zu schreiben.

Nachdem sich die Daten im Data Lake Storage befinden, können sie an dedizierte SQL-Pools, Spark-Pools und andere Lösungen gesendet werden. Alternativ können Sie die Daten aus JSON in Parquet- oder Delta-Formate konvertieren, indem Sie Azure Synapse Analytics-Datenflüsse oder Kopierpipelines verwenden, um zusätzliche BI-Berichte oder KI/maschinelles Lernen auf den aktuellen Daten auszuführen.

Komponenten

- Mit MongoDB Atlas-Änderungsdatenströmen können Sie Anwendungen über Änderungen an einer Sammlung, einer Datenbank oder einem Bereitstellungscluster benachrichtigen. Änderungsdatenströme ermöglichen Anwendungen Zugriff auf Echtzeit-Datenänderungen und ermöglichen es ihnen, sofort auf Änderungen zu reagieren. Diese Funktionalität ist in Anwendungsfällen wie IoT-Ereignisverfolgung und Finanzdatenänderungen von entscheidender Bedeutung, bei denen Alarme ausgelöst und Gegenmaßnahmen sofort ausgeführt werden müssen. Atlas-Trigger verwenden Änderungsdatenströme, um Sammlungen auf Änderungen zu überwachen und automatisch die zugehörige Atlas-Funktion als Antwort auf das Triggerereignis aufzurufen.

- Atlas-Trigger reagieren auf Einfügungen, Aktualisierungen und Löschungen in Dokumenten in einer bestimmten Sammlung und können automatisch eine Atlas-Funktion als Antwort auf das Änderungsereignis aufrufen.

- Atlas-Funktionen sind serverlose, serverseitige JavaScript-Codeimplementierungen, die Aktionen basierend auf den Ereignissen ausführen können, die einen Atlas-Trigger aufrufen. Die Kombination von Atlas-Triggern mit Atlas-Funktionen vereinfacht die Implementierung von ereignisgesteuerten Architekturen.

- Azure Functions ist eine ereignisgesteuerte, serverlose Computingplattform, mit der Sie Anwendungen effizient mit der Programmiersprache Ihrer Wahl entwickeln können. Sie können sie auch verwenden, um nahtlos eine Verbindung mit anderen Azure-Diensten herzustellen. In diesem Szenario erfasst eine Azure-Funktion ein Änderungsereignis und verwendet es zum Schreiben eines Blobs mit den geänderten Daten in Data Lake Storage mithilfe der Data Lake-Clientbibliothek von Azure Storage Files.

- Data Lake Storage ist die Standardspeicherlösung in Azure Synapse Analytics. Sie können serverlose Pools verwenden, um die Daten direkt abzufragen.

- Pipelines und Datenflüsse in Azure Synapse Analytics können verwendet werden, um das Blob, das die geänderten MongoDB-Daten enthält, an dedizierte SQL-Pools oder Spark-Pools zur weiteren Analyse zu pushen. Mithilfe von Pipelines können Sie auf geänderte Datasets in Data Lake Storage reagieren, indem Sie sowohl Speicherereignistrigger als auch geplante Trigger verwenden, um Lösungen für Echtzeit- wie auch Quasi-Echtzeit-Anwendungsfälle zu erstellen. Diese Integration beschleunigt den nachgelagerten Verbrauch von Änderungsdatasets.

Alternativen

Diese Lösung verwendet Atlas-Trigger, um den Code zum Abhören von Atlas-Änderungsdatenströmen zu umschließen und Azure Functions als Reaktion auf das Änderungsereignis auszulösen. Daher ist sie viel einfacher zu implementieren als die zuvor bereitgestellte alternative Lösung. Für diese Lösung müssen Sie Code schreiben, um Änderungsdatenströme in einer Azure App Service-Web-App zu überwachen.

Eine weitere Alternative besteht darin, den MongoDB Spark-Connector zum Lesen von MongoDB-Datenstromdaten zu verwenden und sie in Delta-Tabellen zu schreiben. Der Code wird kontinuierlich in einem Spark Notebook ausgeführt, das Teil einer Pipeline in Azure Synapse Analytics ist. Weitere Informationen zur Implementierung dieser Lösung finden Sie unter Synchronisieren von Atlas zu Azure Synapse Analytics mithilfe von Spark-Streaming.

Die Verwendung von Atlas-Triggern mit Azure Functions bietet jedoch eine vollständig serverlose Lösung. Da sie serverlos ist, bietet die Lösung robuste Skalierbarkeit und Kostenoptimierung. Die Preise basieren auf einem Kostenmodell mit nutzungsbasierter Bezahlung. Sie können mehr Geld sparen, indem Sie die Atlas-Funktion verwenden, um einige Änderungsereignisse zu kombinieren, bevor Sie den Azure Functions-Endpunkt aufrufen. Diese Strategie kann in Szenarien mit hohem Datenverkehr hilfreich sein.

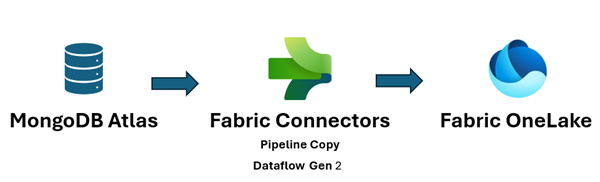

Darüber hinaus vereinheitlicht Microsoft Fabric Ihren Datenbestand und erleichtert die Ausführung von Analysen und KI über die Daten, sodass Sie schnell Einblicke erhalten. Azure Synapse Analytics-Datentechnik, Data Science, Data Warehousing und Echtzeitanalysen in Fabric können jetzt MongoDB-Daten, die an OneLake gepusht werden, besser nutzen. Sie können sowohl Dataflow Gen2- als auch Datenpipelineconnectors für Atlas verwenden, um Atlas-Daten direkt in OneLake zu laden. Dieser No-Code-Mechanismus bietet eine leistungsstarke Möglichkeit zum Erfassen von Daten von Atlas zu OneLake.

In Fabric können Sie direkt auf Daten verweisen, die an Data Lake Storage gepusht werden, indem Sie OneLake-Verknüpfungen verwenden, ohne jegliches ETL (Extrahieren, Transformieren, Laden).

Sie können die Daten an Power BI pushen, um Berichte und Visualisierungen für die BI-Berichterstattung zu erstellen.

Szenariodetails

MongoDB Atlas, die operative Datenebene vieler Unternehmensanwendungen, speichert Daten aus internen Anwendungen, kundenorientierten Diensten und APIs von Drittanbietern aus mehreren Kanälen. Sie können die Datenpipelines in Azure Synapse Analytics verwenden, um diese Daten mit relationalen Daten aus anderen herkömmlichen Anwendungen und mit unstrukturierten Daten aus Quellen wie Protokollen, Objektspeichern und Clickstreams zu kombinieren.

Unternehmen verwenden MongoDB-Funktionen wie Aggregationen, analytische Knoten, Atlas Cognitive Search, Vektorsuche, Atlas Data Lake, Atlas SQL-Schnittstelle, Datenverbund und Diagramme, um anwendungsgesteuerte Intelligenz zu ermöglichen. Die Transaktionsdaten in MongoDB werden jedoch extrahiert, transformiert und in dedizierte Azure Synapse Analytics-SQL-Pools oder Spark-Pools für Batch-, KI/Maschinelles Lernen- und Data Warehouse BI-Analysen und -Intelligenz geladen.

Es gibt zwei Szenarien für die Datenverschiebung zwischen Atlas und Azure Synapse Analytics: Batchintegration und Echtzeitsynchronisierung.

Batch-Integration

Mithilfe der Batch- und Mikro-Batchintegration können Sie Daten aus Atlas zu Data Lake Storage in Azure Synapse Analytics verschieben. Sie können die gesamten Verlaufsdaten gleichzeitig abrufen oder inkrementelle Daten basierend auf Filterkriterien abrufen.

Lokale MongoDB-Instanzen und MongoDB Atlas können als Quell- oder Senkenressource in Azure Synapse Analytics integriert werden. Informationen zu den Connectors finden Sie unter Kopieren von Daten aus oder nach MongoDB oder Kopieren von Daten aus oder nach MongoDB Atlas.

Der Quellconnector erleichtert die Ausführung von Azure Synapse Analytics auf operative Daten, die in der lokalen MongoDB oder in Atlas gespeichert sind. Sie können Daten aus Atlas abrufen, indem Sie den Quellconnector verwenden und die Daten in Data Lake Storage in Parquet-, Avro-, JSON- und Textformaten oder als CSV-Blob-Speicher laden. Diese Dateien können dann in Multidatenbank-, Multicloud- oder Hybrid Cloud-Szenarien mit anderen Dateien aus anderen Datenquellen transformiert oder verknüpft werden. Dieser Anwendungsfall ist in Enterprise Data Warehouse (EDW)- und Analyseszenarien im großen Stil üblich. Sie können auch den Senkenconnector verwenden, um die Ergebnisse der Analyse wieder in Atlas zu speichern. Weitere Informationen zur Batchintegration finden Sie unter Analysieren von operativen Daten in MongoDB Atlas mittels Azure Synapse Analytics.

Echtzeitsynchronisierung

Die in diesem Artikel beschriebene Architektur kann Ihnen helfen, die Echtzeitsynchronisierung zu implementieren, um Ihren Azure Synapse Analytics-Speicher mit den operativen Daten von MongoDB auf dem aktuellen Stand zu halten.

Diese Lösung besteht aus zwei primären Funktionen:

- Erfassen der Änderungen in Atlas

- Auslösen der Azure-Funktion zum Propagieren der Änderungen nach Azure Synapse Analytics

Erfassen der Änderungen in Atlas

Sie können die Änderungen mithilfe eines Atlas-Triggers erfassen, den Sie in der Benutzeroberfläche zum Hinzufügen von Triggern oder mithilfe der Atlas App Services-Administrator-API konfigurieren können. Trigger lauschen auf Datenbankänderungen, die durch Datenbankereignisse wie Einfügungen, Aktualisierungen und Löschungen verursacht werden. Atlas-Trigger lösen auch eine Atlas-Funktion aus, wenn ein Änderungsereignis erkannt wird. Sie können die Benutzeroberfläche zum Hinzufügen von Triggern verwenden, um die Funktion hinzuzufügen. Sie können auch eine Atlas-Funktion erstellen und sie als Endpunkt für den Triggeraufruf zuordnen, indem Sie die Atlas Administrator-API verwenden.

Der folgende Screenshot zeigt das Formular, das Sie zum Erstellen und Bearbeiten eines Atlas-Triggers verwenden können. Im Abschnitt Details der Trigger-Quelle geben Sie die Sammlung an, die der Trigger für Änderungsereignisse überwacht, und die Datenbankereignisse, die er überwacht (Einfügen, Aktualisieren, Löschen und/oder Ersetzen).

Der Trigger kann als Reaktion auf das Ereignis, für das er aktiviert ist, eine Atlas-Funktion aufrufen. Der folgende Screenshot zeigt den einfachen JavaScript-Code, der als Atlas-Funktion hinzugefügt wurde, der als Reaktion auf den Datenbanktrigger aufgerufen werden soll. Die Atlas-Funktion ruft eine Azure-Funktion auf, übergibt ihr die Metadaten des Änderungsereignisses zusammen mit dem Dokument, das eingefügt, aktualisiert, gelöscht oder ersetzt wurde, je nachdem, wofür der Trigger aktiviert ist.

Atlas-Funktionscode

Der Atlas-Funktionscode löst die Azure-Funktion aus, die dem Azure-Funktionsendpunkt zugeordnet ist, indem der gesamte changeEvent im Textkörper der Anforderung an die Azure-Funktion übergeben wird.

Sie müssen den <Azure function URL endpoint>-Platzhalter durch den tatsächlichen Azure-Funktions-URL-Endpunkt ersetzen.

exports = function(changeEvent) {

// Invoke Azure function that inserts the change stream into Data Lake Storage.

console.log(typeof fullDocument);

const response = context.http.post({

url: "<Azure function URL endpoint>",

body: changeEvent,

encodeBodyAsJSON: true

});

return response;

};

Auslösen der Azure-Funktion zum Propagieren der Änderungen nach Azure Synapse Analytics

Die Atlas-Funktion ist codiert, um eine Azure-Funktion aufzurufen, die das Änderungsdokument nach Data Lake Storage in Azure Synapse Analytics schreibt. Die Azure-Funktion verwendet das Azure Data Lake Storage-Clientbibliothek für Python-SDK, um eine Instanz der DataLakeServiceClient-Klasse zu erstellen, die Ihr Speicherkonto darstellt.

Die Azure-Funktion verwendet einen Speicherschlüssel für die Authentifizierung. Sie können auch OAuth-Implementierungen von Microsoft Entra ID verwenden. Der storage_account_key anderen Attribute im Zusammenhang mit Dake Lake Storage werden aus den konfigurierten Betriebssystemumgebungsvariablen abgerufen. Nachdem der Anforderungstext decodiert wurde, wird das fullDocument (das gesamte eingefügte oder aktualisierte Dokument) aus dem Anforderungstext analysiert und dann von den Data Lake-Clientfunktionen append_data und flush_data in Data Lake Storage geschrieben.

Für einen Löschvorgang wird fullDocumentBeforeChange anstelle von fullDocument verwendet. fullDocument hat keinen Wert in einem Löschvorgang, sodass der Code das Dokument abruft, das gelöscht wurde, was in fullDocumentBeforeChange erfasst wird. Beachten Sie, dass fullDocumentBeforeChange nur bereitgestellt wird, wenn die Einstellung Dokumentvorschaubild auf „Ein“ festgelegt ist, wie im vorherigen Screenshot gezeigt.

import json

import logging

import os

import azure.functions as func

from azure.storage.filedatalake import DataLakeServiceClient

def main(req: func.HttpRequest) -> func.HttpResponse:

logging.info('Python HTTP trigger function processed a new request.')

logging.info(req)

storage_account_name = os.environ["storage_account_name"]

storage_account_key = os.environ["storage_account_key"]

storage_container = os.environ["storage_container"]

storage_directory = os.environ["storage_directory"]

storage_file_name = os.environ["storage_file_name"]

service_client = DataLakeServiceClient(account_url="{}://{}.dfs.core.windows.net".format(

"https", storage_account_name), credential=storage_account_key)

json_data = req.get_body()

logging.info(json_data)

object_id = "test"

try:

json_string = json_data.decode("utf-8")

json_object = json.loads(json_string)

if json_object["operationType"] == "delete":

object_id = json_object["fullDocumentBeforeChange"]["_id"]["$oid"]

data = {"operationType": json_object["operationType"], "data":json_object["fullDocumentBeforeChange"]}

else:

object_id = json_object["fullDocument"]["_id"]["$oid"]

data = {"operationType": json_object["operationType"], "data":json_object["fullDocument"]}

logging.info(object_id)

encoded_data = json.dumps(data)

except Exception as e:

logging.info("Exception occurred : "+ str(e))

file_system_client = service_client.get_file_system_client(file_system=storage_container)

directory_client = file_system_client.get_directory_client(storage_directory)

file_client = directory_client.create_file(storage_file_name + "-" + str(object_id) + ".txt")

file_client.append_data(data=encoded_data, offset=0, length=len(encoded_data))

file_client.flush_data(len(encoded_data))

return func.HttpResponse(f"This HTTP triggered function executed successfully.")

Bisher haben Sie gesehen, wie der Atlas-Trigger alle Änderungen erfasst, die auftreten, und über eine Atlas-Funktion an eine Azure-Funktion übergibt, und dass die Azure-Funktion das Änderungsdokument als neue Datei in Data Lake Storage in den Azure Synapse Analytics-Arbeitsbereich schreibt.

Nachdem die Datei zu Data Lake Storage hinzugefügt wurde, können Sie einen Speicherereignistrigger einrichten, um eine Pipeline auszulösen, die dann das Änderungsdokument in einen dedizierten SQL-Pool oder in eine Spark-Pool-Tabelle schreiben kann. Die Pipeline kann die Copy-Aktivität verwenden und die Daten mithilfe eines Datenflusses transformieren. Wenn Ihr endgültiges Ziel ein dedizierter SQL-Pool ist, können Sie alternativ die Azure-Funktion so ändern, dass sie direkt in den dedizierten SQL-Pool in Azure Synapse Analytics schreibt. Rufen Sie für einen SQL-Pool die ODBC-Verbindungszeichenfolge für die SQL-Pool-Verbindung ab. Unter Verwenden von Python zum Abfragen einer Datenbank finden Sie ein Beispiel für Python-Code, mit dem Sie die SQL-Pool-Tabelle mithilfe der Verbindungszeichenfolge abfragen können. Sie können diesen Code so ändern, dass eine Einfügen-Abfrage verwendet wird, um in einen dedizierten SQL-Pool zu schreiben. Es gibt Konfigurationseinstellungen und Rollen, die zugewiesen werden müssen, um die Funktion zum Schreiben in einen dedizierten SQL-Pool zu aktivieren. Informationen zu diesen Einstellungen und Rollen befinden sich außerhalb des Umfangs dieses Artikels.

Wenn Sie eine Quasi-Echtzeit-Lösung wollen und die Daten nicht in Echtzeit synchronisiert werden müssen, ist die Verwendung geplanter Pipelineausführungen möglicherweise eine gute Option. Sie können geplante Auslöser einrichten, um eine Pipeline mit der Copy-Aktivität oder einem Datenfluss in einer Häufigkeit auszulösen, die sich in der Nähe der Quasi-Echtzeit-Häufigkeit befindet, die sich Ihr Unternehmen leisten kann, um den MongoDB-Connector zum Abrufen der Daten aus MongoDB zu verwenden, die zwischen der letzten geplanten Ausführung und der aktuellen Ausführung eingefügt, aktualisiert oder gelöscht wurden. Die Pipeline verwendet den MongoDB-Connector als Quellconnector, um die Delta-Daten aus MongoDB Atlas abzurufen und an Data Lake Storage oder dedizierte SQL-Pools in Azure Synapse Analytics zu pushen, wobei diese als Senkenverbindungen verwendet werden. Diese Lösung verwendet einen Pull-Mechanismus (im Gegensatz zur in diesem Artikel beschriebenen Hauptlösung, die ein Push-Mechanismus ist) von MongoDB Atlas, wenn Änderungen in der MongoDB Atlas-Sammlung auftreten, auf die der Atlas-Trigger lauscht.

Mögliche Anwendungsfälle

MongoDB und die Azure Synapse Analytics-EDW und analytische Dienste können zahlreiche Anwendungsfälle bedienen:

Einzelhandel

- Gewinnen von Erkenntnissen über Produktbündelung und Produktwerbung

- Implementieren von Kunden 360 und Hyperpersonalisierung

- Vorhersagen von Bestandserschöpfung und Optimierung von Lieferkettenaufträgen

- Implementieren von dynamischen Rabattpreisen und intelligenter Suche im E-Commerce

Bank- und Finanzwesen

- Anpassen von Kundenfinanzdienstleistungen

- Erkennen und Blockieren betrügerischer Transaktionen

Telekommunikation

- Optimieren von Netzwerken der nächsten Generation

- Maximieren des Werts von Umkreisnetzwerken

Automobilindustrie

- Optimieren der Parametrisierung verbundener Fahrzeuge

- Erkennen von Anomalien bei der IoT-Kommunikation in verbundenen Fahrzeugen

Fertigung

- Bereitstellung von Predictive Maintenance für Maschinen

- Optimieren der Speicher- und Bestandsverwaltung

Überlegungen

Diese Überlegungen bilden die Säulen des Azure Well-Architected Framework, einer Reihe von Leitprinzipien, die Sie zur Verbesserung der Qualität eines Workloads verwenden können. Weitere Informationen finden Sie unter Microsoft Azure Well-Architected Framework.

Sicherheit

Sicherheit bietet Schutz vor vorsätzlichen Angriffen und dem Missbrauch Ihrer wertvollen Daten und Systeme. Weitere Informationen finden Sie unter Übersicht über die Säule „Sicherheit“.

Azure Functions ist ein serverloser verwalteter Dienst, sodass die App-Ressourcen und Plattformkomponenten durch erhöhte Sicherheit geschützt werden. Es wird jedoch empfohlen, das HTTPS-Protokoll und die neuesten TLS-Versionen zu verwenden. Es ist auch eine gute Praxis, die Eingabe zu validieren, um sicherzustellen, dass es sich um ein MongoDB-Änderungsdokument handelt. Sicherheitsüberlegungen für Azure Functions finden Sie unter Schützen von Azure Functions.

MongoDB Atlas ist eine verwaltete Database-as-a-Service, daher bietet MongoDB erweiterte Plattformsicherheit. MongoDB bietet mehrere Mechanismen, um die 360 Grad-Sicherheit von gespeicherten Daten zu gewährleisten, einschließlich Datenbankzugriff, Netzwerksicherheit, Verschlüsselung im Ruhezustand und während der Übertragung sowie Datenhoheit. Siehe MongoDB Atlas-Sicherheit für das MongoDB Atlas-Whitepaper zur Sicherheit und andere Artikel, die Ihnen helfen können, sicherzustellen, dass die Daten in MongoDB während des gesamten Datenlebenszyklus sicher sind.

Kostenoptimierung

Bei der Kostenoptimierung geht es darum, unnötige Ausgaben zu reduzieren und die Betriebseffizienz zu verbessern. Weitere Informationen finden Sie unter Übersicht über die Säule „Kostenoptimierung“.

Nutzen Sie den Azure-Preisrechner, falls Sie eine Kostenschätzung für Azure-Produkte und -Konfigurationen benötigen. Azure hilft Ihnen, unnötige Kosten zu vermeiden, indem es die richtige Anzahl der zu verwendenden Ressourcen bestimmt, die Ausgaben im Zeitverlauf analysiert und die Skalierung so vornimmt, dass die Geschäftsanforderungen erfüllt werden, ohne dass zu viel ausgegeben wird. Azure Functions verursachen nur Kosten, wenn sie aufgerufen werden. Je nach Volumen der Änderungen im MongoDB Atlas können Sie jedoch die Verwendung eines Batchverarbeitungsmechanismus in der Atlas-Funktion auswerten, um Änderungen in einer anderen temporären Sammlung zu speichern und die Azure-Funktion nur auszulösen, wenn der Batch einen bestimmten Grenzwert überschreitet.

Informationen zu Atlas-Clustern finden Sie unter 5 Möglichkeiten, Kosten mit MongoDB Atlas zu reduzieren und Clusterkonfigurationskosten. Die MongoDB-Preisseite kann Ihnen helfen, die Preisoptionen für MongoDB Atlas-Cluster und andere Angebote der MongoDB Atlas-Entwicklerdatenplattform zu verstehen. Atlas-Datenverbund kann in Azure bereitgestellt werden und unterstützt Azure Blob Storage (in der Vorschau). Wenn Sie die Verwendung der Batchverarbeitung zur Optimierung der Kosten in Betracht ziehen, sollten Sie anstelle einer temporären MongoDB-Sammlung in Azure Blob Storage schreiben.

Effiziente Leistung

Leistungseffizienz ist die Fähigkeit Ihrer Workload, auf effiziente Weise eine den Anforderungen der Benutzer entsprechende Skalierung auszuführen. Weitere Informationen finden Sie unter Übersicht über die Säule „Leistungseffizienz“.

Atlas-Trigger und Azure Functions sind erprobt hinsichtlich Leistung und Skalierbarkeit. Unter Leistung und Skalierung in Durable Functions (Azure Functions) finden Sie Informationen, um die Leistungs- und Skalierbarkeitsüberlegungen für Azure Functions zu verstehen. Unter Skalieren bei Bedarf finden Sie einige Überlegungen zur Verbesserung der Leistung Ihrer MongoDB Atlas-Instanzen. Unter Handbuch für bewährte Methoden für die MongoDB-Leistung finden Sie bewährte Methoden für die MongoDB Atlas-Konfiguration.

Zusammenfassung

MongoDB Atlas lässt sich nahtlos in Azure Synapse Analytics integrieren, sodass Atlas-Kunden Atlas einfach als Quelle oder Senke für Azure Synapse Analytics verwenden können. Mit dieser Lösung können Sie operative MongoDB-Daten in Echtzeit aus Azure Synapse Analytics für komplexe Analysen und KI-Rückschlüsse verwenden.

Bereitstellen dieses Szenarios

Echtzeitsynchronisierung von MongoDB Atlas zu Azure Synapse Analytics

Beitragende

Dieser Artikel wird von Microsoft gepflegt. Er wurde ursprünglich von folgenden Mitwirkenden geschrieben:

Hauptautoren:

- Diana Annie Jenosh | Senior Solutions Architect – MongoDB Partners-Team

- Venkatesh Shanbag| Senior Solutions Architect – MongoDB Partners-Team

Andere Mitwirkende:

- Sunil Sabat | Principal Program Manager – ADF-Team

- Wee Hyong Tok | Principal Director von PM – ADF-Team

Melden Sie sich bei LinkedIn an, um nicht öffentliche LinkedIn-Profile anzuzeigen.