Was ist Data Warehousing in Azure Databricks?

Data Warehousing bezieht sich auf das Sammeln und Speichern von Daten aus mehreren Quellen, sodass schnell auf Geschäftserkenntnisse und Berichte zugegriffen werden kann. Dieser Artikel enthält wichtige Konzepte zum Erstellen eines Data Warehouse in Ihrem Data Lakehouse.

Data Warehousing in Ihrem Lakehouse

Die Lakehouse-Architektur und Databricks SQL stellen Data Warehouse-Cloudfunktionen in Ihren Data Lakes zur Verfügung. Mit vertrauten Datenstrukturen, Beziehungen und Verwaltungstools können Sie ein leistungsfähiges, kostengünstiges Data Warehouse modellieren, das direkt in Ihrem Data Lake ausgeführt wird. Weitere Informationen finden Sie unter Was ist ein Data Lakehouse?.

Wie bei einem herkömmlichen Data Warehouse modellieren Sie Daten entsprechend den Geschäftsanforderungen und stellen sie dann den Endbenutzer*innen für Analysen und Berichte zur Verfügung. Im Gegensatz zu einem herkömmlichen Data Warehouse können Sie Silos für Ihre Geschäftsanalysedaten und die Erstellung redundanter Kopien vermeiden, die schnell veraltet sind.

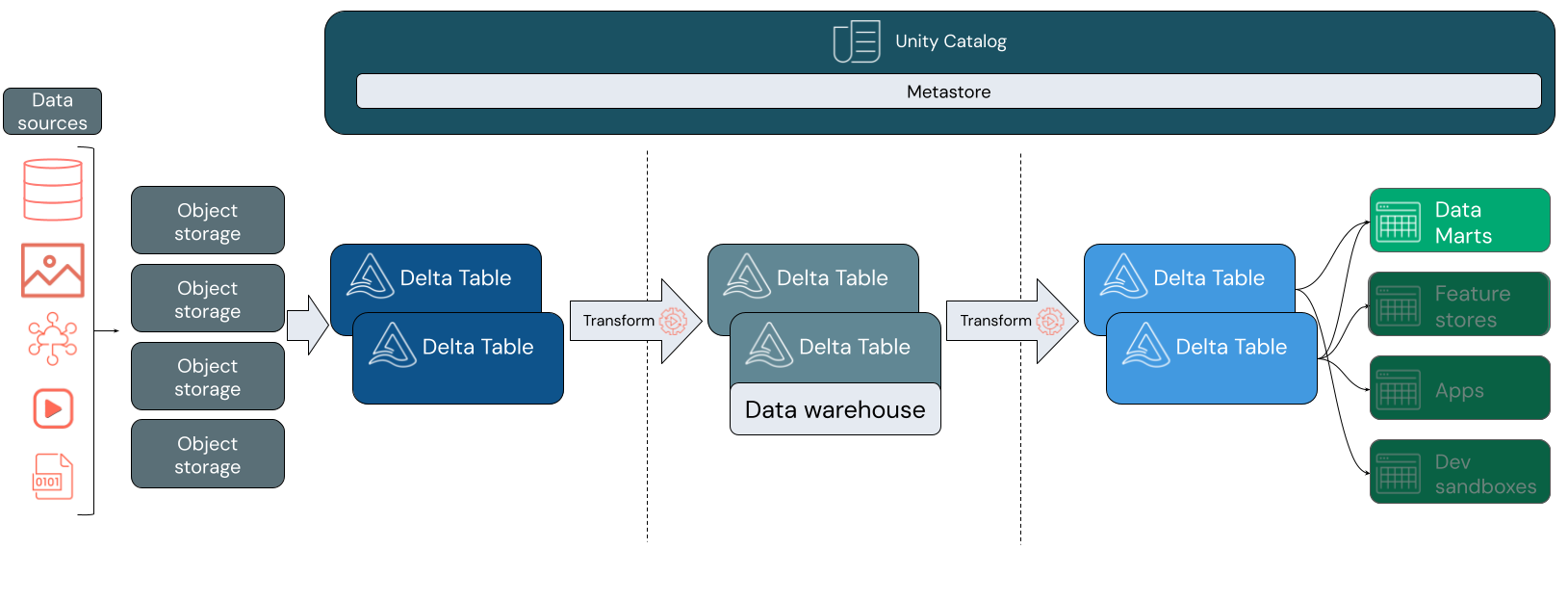

Wenn Sie ein Data Warehouse in Ihrem Lakehouse erstellen, können Sie alle Ihre Daten in ein einzelnes System integrieren und Features wie Unity Catalog und Delta Lake nutzen.

Unity Catalog fügt ein einheitliches Governancemodell hinzu, sodass Sie den Datenzugriff schützen und überwachen und Herkunftsinformationen zu Downstreamtabellen bereitstellen können. Delta Lake fügt neben anderen leistungsstarken Tools ACID-Transaktionen und Schemaentwicklung hinzu, um die Zuverlässigkeit, Skalierbarkeit und Qualität Ihrer Daten zu gewährleisten.

Was ist Databricks SQL?

Hinweis

Databricks SQL Serverless ist in Azure China nicht verfügbar. Databricks SQL ist in Azure Government-Regionen nicht verfügbar.

Databricks SQL ist die Sammlung von Diensten, die Data Warehouse-Funktionen und Leistung für Ihre vorhandenen Data Lakes bereitstellen. Databricks SQL unterstützt offene Formate und die Standardversion von ANSI-SQL. Mit einem in die Plattform integrierten SQL-Editor und Dashboardtools können Teammitglieder direkt im Arbeitsbereich mit anderen Databricks-Benutzer*innen zusammenarbeiten. Databricks SQL lässt sich auch in eine Vielzahl von Tools integrieren, sodass Analysten Abfragen und Dashboards in ihren bevorzugten Umgebungen erstellen können, ohne dass eine Anpassung an eine neue Plattform erforderlich ist.

Databricks SQL stellt allgemeine Computeressourcen für bereit, die für die Tabellen im Lakehouse ausgeführt werden. Databricks SQL wird von SQL-Warehouses unterstützt, früher als SQL-Endpunkte bezeichnet, und bietet skalierbare SQL-Computeressourcen, die vom Speicher entkoppelt werden.

Weitere Informationen zu SQL Warehouse-Standardwerten und -Optionen finden Sie unter Herstellen einer Verbindung mit einem SQL Warehouse.See Connect to a SQL Warehouse warehouse defaults and options.

Databricks SQL ist in Unity Catalog integriert, sodass Sie Datenressourcen an einem Ort ermitteln, überwachen und steuern können. Weitere Informationen finden Sie unter Was ist Unity Catalog?.

Datenmodellierung in Azure Databricks

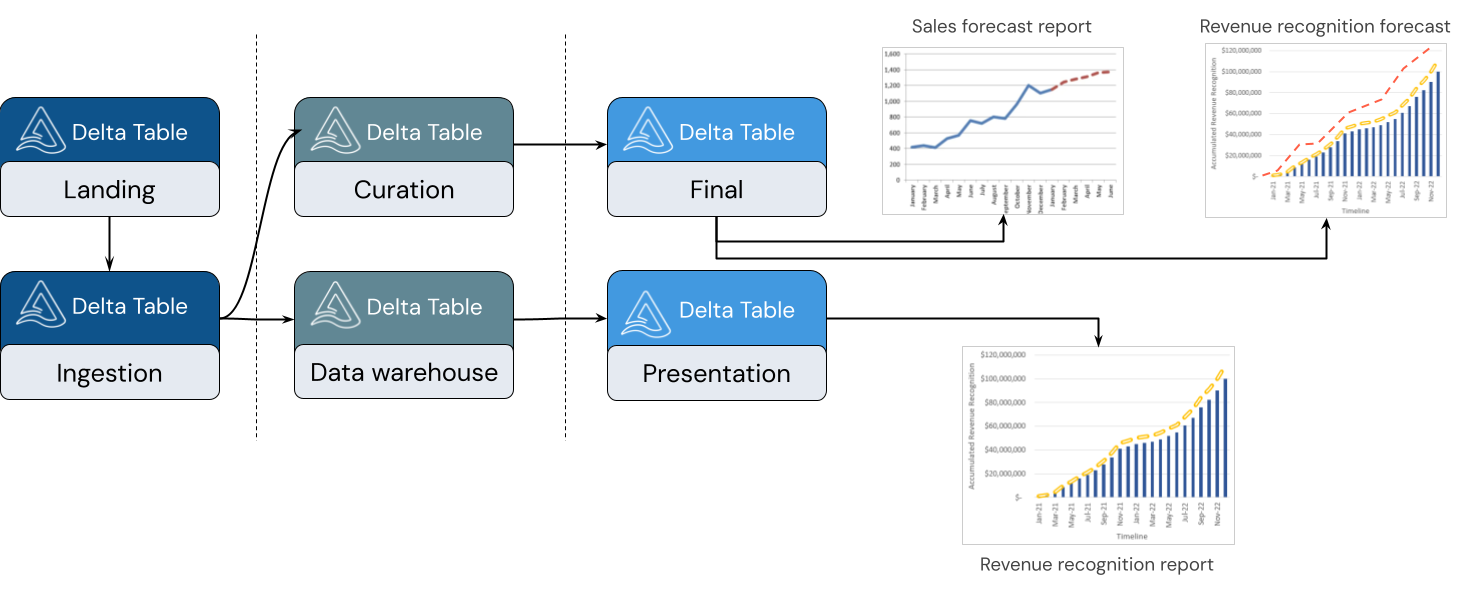

Ein Lakehouse unterstützt eine Vielzahl von Modellierungsstilen. Die folgende Abbildung zeigt, wie Daten kuratiert und modelliert werden, während sie sich durch verschiedene Ebenen eines Lakehouse bewegen.

Medallion-Architektur

Die Medallion-Architektur ist ein Datenentwurfsmuster, das eine Reihe inkrementell optimierter Datenebenen beschreibt, die eine grundlegende Struktur im Lakehouse bilden. Die Ebenen Bronze, Silber und Gold stehen für eine zunehmende Datenqualität auf jeder Ebene, wobei Gold die höchste Qualität darstellt. Weitere Informationen finden Sie unter Was ist die Medallion Lakehouse-Architektur?.

Innerhalb eines Lakehouse kann jede Ebene eine oder mehrere Tabellen enthalten. Das Data Warehouse wird auf der Silberebene modelliert und überträgt spezielle Data Marts an die Goldebene.

Bronzeebene

Daten können in einem beliebigen Format und durch eine beliebige Kombination aus Batch- oder Streamingtransaktionen in Ihrem Lakehouse erfasst werden. Auf der Bronzeebene werden alle Rohdaten im ursprünglichen Format empfangen. Diese Daten werden in Delta-Tabellen konvertiert.

Silberebene

Die Silberebene führt die Daten aus verschiedenen Quellen zusammen. Für den Teil des Unternehmens, der sich auf Data Science- und Machine Learning-Anwendungen konzentriert, beginnen Sie hier mit dem Zusammenstellen aussagekräftiger Datenressourcen. Dieser Prozess ist oft von Schnelligkeit und Agilität geprägt.

Die Silberebene ist ebenfalls der Ort, an dem Sie Daten aus unterschiedlichen Quellen sorgfältig integrieren können, um ein Data Warehouse in Übereinstimmung mit Ihren bestehenden Geschäftsprozessen zu erstellen. Diese Daten folgen häufig einem 3NF-Modell (3rd Normal Form, dritte Normalform) oder einem Datentresormodell. Die Angabe von Einschränkungen für Primär- und Fremdschlüssel ermöglicht es Endbenutzer*innen, Tabellenbeziehungen bei der Verwendung von Unity Catalog zu verstehen. Ihr Data Warehouse sollte als Single Source of Truth (einzelne Wahrheitsinstanz) für Ihre Data Marts dienen.

Für das Data Warehouse selbst gilt ein vordefiniertes Schema (Schema-on-Write, Schema bei Schreibvorgängen), und es ist atomisch. Es ist für Änderungen optimiert, sodass Sie das Data Warehouse schnell an Ihre aktuellen Anforderungen anpassen können, wenn sich Ihre Geschäftsprozesse ändern oder weiterentwickeln.

Goldebene

Die Goldebene ist die Darstellungsebene. Sie kann mehrere Data Marts enthalten. Häufig handelt es sich bei Data Marts um dimensionale Modelle in Form einer Reihe zusammenhängender Tabellen, die eine bestimmte Geschäftsperspektive abbilden.

Die Goldebene enthält darüber hinaus Abteilungs- und Data Science-Sandboxes, um Self-Service-Analysen und Data Science im gesamten Unternehmen u ermöglichen. Durch die Bereitstellung dieser Sandboxes und ihrer eigenen separaten Computecluster wird verhindert, dass die Geschäftsteams Kopien von Daten außerhalb des Lakehouse erstellen.

Nächster Schritt

Weitere Informationen zu den Prinzipien und bewährten Methoden zum Implementieren und Betreiben eines Lakehouse mithilfe von Databricks finden Sie unter Einführung in das gut strukturierte Data Lakehouse.