Évaluer les performances : les métriques importantes

Cet article traite de la mesure des performances d’une application RAG pour la qualité de la récupération, de la réponse et des performances du système.

Récupération, réponse et performances

Avec un jeu d’évaluation, vous pouvez mesurer les performances de votre application RAG sur plusieurs dimensions différentes, notamment :

- Qualité de la récupération : les mesures de récupération évaluent la façon dont votre application RAG récupère les données de prise en charge pertinentes. La précision et le rappel sont deux mesures de récupération clés.

- Qualité de la réponse : les mesures de qualité des réponses évaluent la façon dont l’application RAG répond à la requête d’un utilisateur. Les mesures de réponse peuvent mesurer, par exemple, si la réponse obtenue est exacte par rapport à la référence, à quel point la réponse était bien fondée, compte tenu du contexte récupéré (par exemple, le LLM a-t-il halluciné) ou à quel point la réponse était sûre (en d’autres termes, absence de toxicité).

- Performance du système (coût et latence) : les mesures capturent le coût global et la performance des applications RAG. La latence globale et la consommation de jetons sont des exemples de mesures de performance de la chaîne.

Il est très important de collecter les métriques de réponse et de récupération. Une application RAG peut répondre mal malgré la récupération du contexte correct ; il peut également fournir de bonnes réponses basées sur des récupérations défectueuses. Seulement en mesurant les deux composants, nous pouvons diagnostiquer et résoudre les problèmes avec précision dans l’application.

Approches de mesure des performances

Il existe deux approches essentielles pour évaluer les performances selon ces mesures :

- Mesure déterministe : les métriques de coût et de latence peuvent être calculées de manière déterministe en fonction des sorties de l’application. Si votre jeu d’évaluation inclut une liste de documents qui contiennent la réponse à une question, un sous-ensemble des métriques de récupération peut également être calculé de manière déterministe.

- Mesure basée sur le juge LLM : dans cette approche, un LLM distinct agit en tant que juge pour évaluer la qualité de la récupération et des réponses de l’application RAG. Certains juges LLM, tels que la correction des réponses, comparent la vérité de base étiquetée par l’homme par rapport aux sorties de l’application. D’autres juges LLM, tels que l’état de base, ne nécessitent pas de vérité au sol étiquetée par l’homme pour évaluer leurs sorties d’application.

Important

Pour qu’un juge LLM soit efficace, il doit être réglé pour comprendre le cas d’usage. Cela nécessite une attention particulière pour comprendre où le juge fait et ne fonctionne pas bien, puis en réglant le juge pour l’améliorer pour les cas d’échec.

Mosaïque AI Agent Evaluation fournit une implémentation prête à l’emploi, à l’aide de modèles de juge LLM hébergés, pour chaque métrique abordée sur cette page. La documentation de l’évaluation de l’agent décrit les détails de la façon dont ces métriques et juges sont implémentés et fournit des fonctionnalitéspermettant de régler les juges avec vos données afin d’augmenter leur précision

Vue d’ensemble des métriques

Voici un résumé des métriques recommandées par Databricks pour mesurer la qualité, le coût et la latence de votre application RAG. Ces métriques sont implémentées dans l’évaluation de l’agent d’IA de Mosaïque.

| Dimension | Nom de métrique | Question | Mesuré par | Besoin de vérité terrain ? |

|---|---|---|---|---|

| Récupération | chunk_relevance/precision | Quel % des blocs récupérés sont pertinents pour la demande ? | Juge LLM | Non |

| Récupération | document_recall | Quel % des documents de vérité de base sont représentés dans les blocs récupérés ? | Déterministe | Oui |

| Response | correctness | Dans l’ensemble, l’agent a-t-il généré une réponse correcte ? | Juge LLM | Oui |

| Response | relevance_to_query | La réponse est-elle pertinente à la requête ? | Juge LLM | Non |

| Response | groundedness | La réponse est-elle une hallucination ou ancrée dans le contexte ? | Juge LLM | Non |

| Response | Sûreté | Existe-t-il du contenu nuisible dans la réponse ? | Juge LLM | Non |

| Coût | total_token_count, total_input_token_count, total_output_token_count | Quel est le nombre total de jetons pour les générations de LLM ? | Déterministe | Non |

| Latence | latency_seconds | Quelle est la latence d’exécution de l’application ? | Déterministe | Non |

Fonctionnement des métriques de récupération

Les métriques de récupération vous aident à comprendre si votre récupérateur fournit des résultats pertinents. Les métriques de récupération sont basées sur la précision et le rappel.

| Nom de métrique | Question traitée | Détails |

|---|---|---|

| Precision | Quel % des blocs récupérés sont pertinents pour la demande ? | La précision est la proportion de documents récupérés qui sont réellement pertinents pour la demande de l’utilisateur. Un juge LLM peut être utilisé pour évaluer la pertinence de chaque bloc récupéré à la demande de l’utilisateur. |

| Rappel | Quel % des documents de vérité de base sont représentés dans les blocs récupérés ? | Rappelez-vous que la proportion des documents de vérité de base qui sont représentés dans les blocs récupérés. Il s’agit d’une mesure de l’exhaustivité des résultats. |

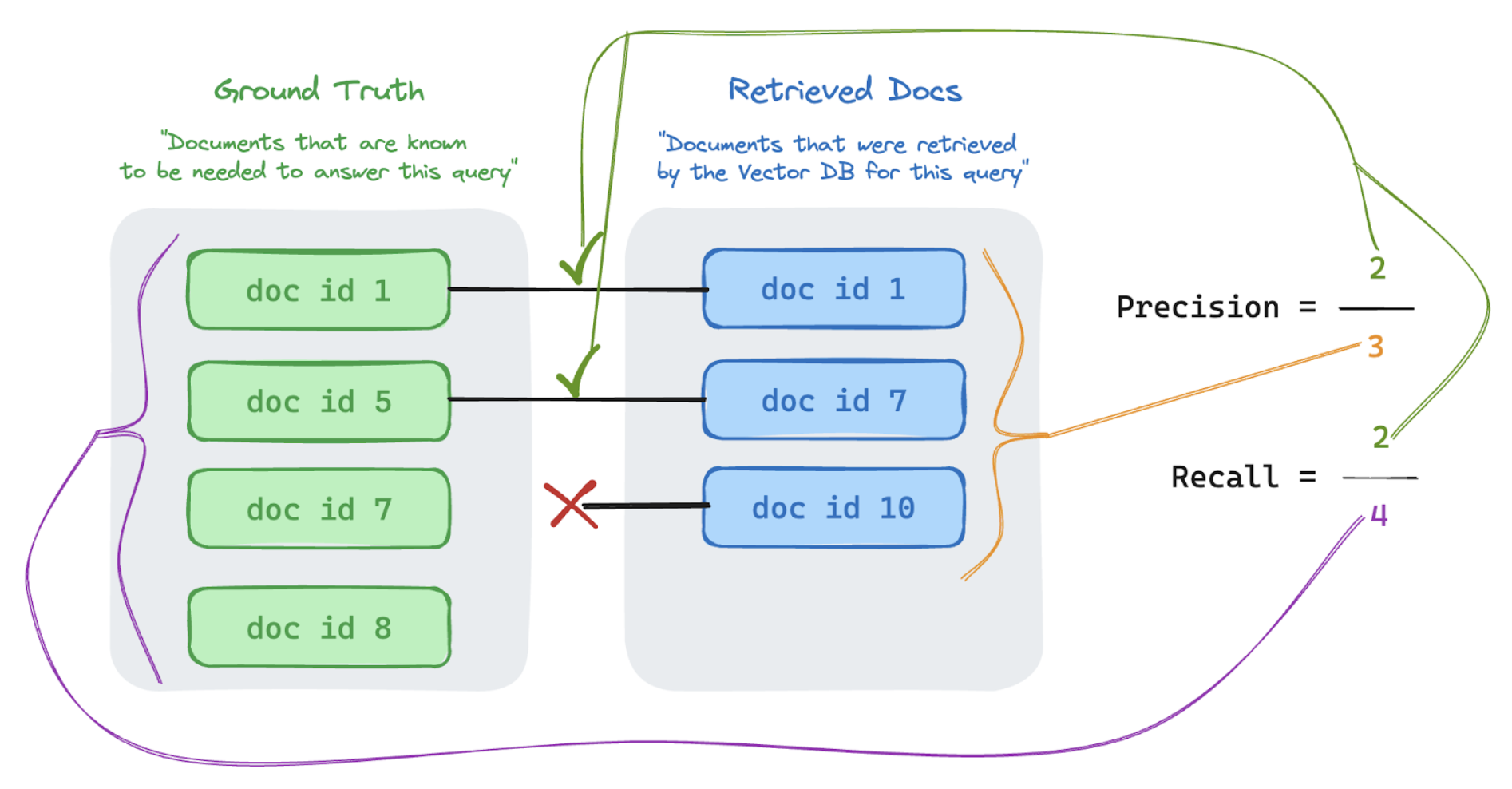

Précision et rappel

Vous trouverez ci-dessous un aperçu rapide de la précision et du rappel adapté de l’excellent article Wikipédia.

Formule de précision

Mesures de précision « Des blocs que j’ai récupérés, quel % de ces éléments sont réellement pertinents pour la requête de mon utilisateur ? » La précision informatique ne nécessite pas de connaître tous les éléments pertinents.

Formule de rappel

Rappelez-vous les mesures « De TOUS les documents que je connais sont pertinents pour la requête de mon utilisateur, quel % ai-je récupéré un bloc ? » Le rappel informatique nécessite votre vérité de base pour contenir tous les éléments pertinents. Les éléments peuvent être un document ou un bloc d’un document.

Dans l’exemple ci-dessous, deux des trois résultats récupérés étaient pertinents pour la requête de l’utilisateur. La précision était donc 0,66 (2/3). Les documents récupérés comprenaient deux documents sur un total de quatre documents pertinents, de sorte que le rappel était de 0,5 (2/4).