Étape 3. Organiser un jeu d’évaluation à partir des commentaires des parties prenantes

Consultez le référentiel GitHub pour obtenir l’exemple de code de cette section.

Délai attendu : 10 à 60 minutes. Le temps varie en fonction de la qualité des réponses fournies par vos parties prenantes. Si les réponses sont désordonnées ou contiennent beaucoup de requêtes non pertinentes, vous devez passer plus de temps à filtrer et nettoyer les données.

Vue d’ensemble et résultats attendus

Cette étape démarre un jeu d’évaluation avec les commentaires fournis par les parties prenantes à l’aide de l’application de révision. Notez que vous pouvez démarrer un jeu d’évaluation avec des questions uniquement. Par conséquent, même si vos parties prenantes ont uniquement discuté avec l’application plutôt que de fournir des commentaires, vous pouvez suivre cette étape.

Pour le schéma du jeu d’évaluation de l’agent, consultez le schéma d’entrée d’évaluation de l’agent. Les champs de ce schéma sont référencés dans le reste de cette section.

À la fin de cette étape, vous disposez d’un jeu d’évaluation qui contient les éléments suivants :

- Demandes avec un pouce vers le haut 👍 :

request: tel qu’entré par l’utilisateur.expected_response: réponse modifiée par l’utilisateur. Si l’utilisateur n’a pas modifié la réponse, elle est générée par le modèle.

- Demandes avec un pouce vers le bas 👎 :

request: tel qu’entré par l’utilisateur.expected_response: réponse modifiée par l’utilisateur. Si l’utilisateur n’a pas modifié la réponse, elle est nulle.

- Demandes sans retour d’expérience (pas de pouce vers le haut 👍 ou vers le bas 👎)

request: tel qu’entré par l’utilisateur.

Pour toutes les requêtes, si l’utilisateur sélectionne le pouce vers le haut 👍 pour un segment de retrieved_context, doc_uri de ce segment est inclus dans expected_retrieved_context pour la question.

Important

Databricks recommande que votre jeu d’évaluation contienne au moins 30 questions pour commencer. Pour en savoir plus sur ce qu’est un « bon » ensemble d’évaluation, lisez la présentation approfondie du jeu d’évaluation.

Spécifications

- Les parties prenantes ont utilisé votre POC et fourni des commentaires.

- Toutes les exigences des étapes précédentes.

Instructions

- Ouvrez le notebook 04_create_evaluation_set, puis cliquez sur Exécuter tout.

- Inspectez le jeu d’évaluation pour comprendre les données incluses. Vous devez vérifier que votre jeu d’évaluation contient un ensemble représentatif et difficile de questions. Ajustez le jeu d’évaluation en fonction des besoins.

- Par défaut, votre jeu d’évaluation est enregistré dans la table Delta configurée dans

EVALUATION_SET_FQNdans le notebook 00_global_config.

Étape suivante

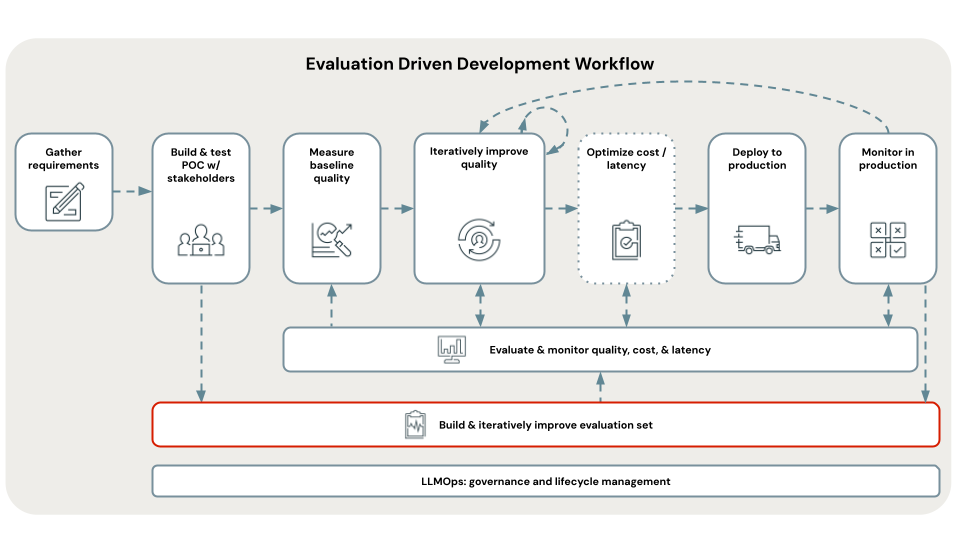

Maintenant que vous disposez d’un jeu d’évaluation, utilisez-le pour évaluer la qualité, le coût et la latence de l’application POC. Consultez Étape 4. Évaluer la qualité de la POC.

< Précédent : Étape 2. Déployer POC & recueillir des commentaires