Étape 4. Évaluer la qualité de la preuve de concept

Consultez le référentiel GitHub pour obtenir l’exemple de code de cette section.

Délai attendu : 5 à 60 minutes. Le temps varie en fonction du nombre de questions dans votre jeu d’évaluation. Pour 100 questions, l’évaluation prend environ 5 minutes.

Vue d’ensemble et résultats attendus

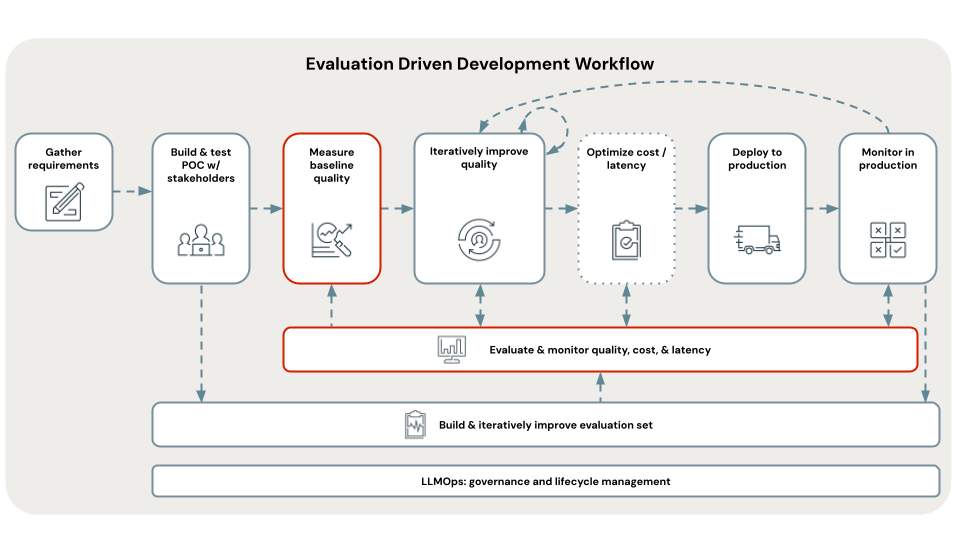

Cette étape utilise le jeu d’évaluation nouvellement organisé pour évaluer votre application de preuve de concept et établir la qualité, le coût et la latence de la ligne de base. Les résultats de l’évaluation sont utilisés à l’étape suivante pour identifier la cause racine des problèmes de qualité.

L’évaluation est effectuée à l’aide de l’évaluation de l’agent Mosaic AI et examine de manière complète tous les aspects de la qualité, du coût et de la latence décrits dans la section métriques de ce livre de recettes.

Les métriques agrégées et l’évaluation de chaque question dans le jeu d’évaluation sont consignées dans MLflow. Pour plus d’informations, consultez Sorties d’évaluation.

Spécifications

- Un jeu d’évaluation est disponible.

- Toutes les spécifications des étapes précédentes.

Instructions

- Ouvrez le notebook

05_evaluate_poc_qualitydans votre répertoire POC choisi, puis cliquez sur Exécuter tout. - Inspectez les résultats de l’évaluation dans le notebook ou à l’aide de MLflow. Si les résultats répondent à vos besoins en qualité, vous pouvez passer directement à [Déployer et superviser]. L’application de preuve de concept étant basée sur Databricks, elle est prête à être déployée sur une API REST évolutive et prête pour la production.

Étape suivante

À l’aide de cette évaluation des lignes de base de la qualité de la preuve de concept, identifiez les causes racines des problèmes de qualité et corrigez de manière itérative ces problèmes pour améliorer l’application. Consultez l’Étape 5. Identifiez la cause racine des problèmes de qualité.