Août 2022

Ces fonctionnalités et améliorations de la plateforme Azure Databricks ont été publiées en août 2022.

Notes

Les publications se font par étapes. Votre compte Azure Databricks ne peut pas être mis à jour jusqu’à une semaine ou plus après la date de publication initiale.

Les utilisateurs de compte peuvent accéder à la console de compte

1er - 31 août 2022

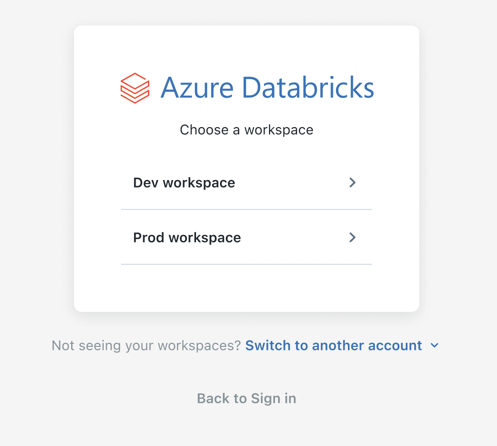

Les utilisateurs de compte peuvent accéder à la console de compte Azure Databricks pour afficher la liste de leurs espaces de travail. Les utilisateurs de compte peuvent uniquement afficher les espaces de travail auxquels ils ont été autorisés à accéder. Consultez Gérer votre compte Azure Databricks

Les utilisateurs des espaces de travail sont synchronisés automatiquement avec votre compte en tant qu’utilisateurs de compte. Tous les utilisateurs de l’espace de travail et les principaux de service existants sont synchronisés automatiquement avec votre compte en tant qu’utilisateurs et principaux de service au niveau du compte. Consultez Comment les administrateurs affectent-ils les utilisateurs au compte ?.

Pilote ODBC Databricks 2.6.26

29 août 2022

Nous avons publié la version 2.6.26 du pilote ODBC Databricks (téléchargement). Cette publication met à jour la prise en charge des requêtes. Vous pouvez désormais annuler de manière asynchrone des requêtes sur des connexions HTTP lors de la demande API.

Cette version résout également les problèmes suivants :

- Lorsque vous utilisez des requêtes personnalisées dans Spotfire, le connecteur cesse de répondre.

Pilote JDBC Databricks 2.6.29

29 août 2022

Nous avons publié la version 2.6.29 du pilote JDBC Databricks (télécharger). Cette publication résout les problèmes suivants :

- Lorsque vous utilisez un proxy HTTP avec Cloud Fetch activé, le connecteur ne retourne pas de résultats de jeu de données volumineux.

- Problèmes de texte mineurs dans le texte de la licence Databricks. Des liens de documentation étaient manquants.

- Les noms de fichiers JAR étaient incorrects. Au lieu de SparkJDBC41.jar, le nom aurait dû être DatabricksJDBC41.jar. Au lieu de SparkJDBC42.jar, le nom aurait dû être DatabricksJDBC42.jar.

Client Databricks Feature Store désormais disponible sur PyPI

26 août 2022

Le client Feature Store est désormais disponible sur PyPI. Le client a besoin de Databricks Runtime 9.1 LTS ou version ultérieure et peut être installé à l’aide de :

%pip install databricks-feature-store

Le client est déjà mis en paquet avec Databricks Runtime pour Machine Learning 9.1 LTS et versions ultérieures.

Le client ne peut pas être exécuté en dehors de Databricks. Toutefois, vous pouvez l’installer localement pour faciliter les tests unitaires et pour une prise en charge supplémentaire de l’IDE (par exemple, autocomplétion). Pour plus d’informations, consultez Client Python de Databricks Feature Store

Unity Catalog est en GA

25 août 2022

Le catalogue Unity est en disponibilité générale. Pour obtenir des annonces détaillées sur les fonctionnalités et les limitations, consultez Note de publication d’Unity Catalog en disponibilité générale.

Delta Sharing est en disponibilité générale

25 août 2022

Delta Sharing est désormais en disponibilité générale, à compter de Databricks Runtime 11.1. Pour plus d’informations, consultez Qu’est-ce que Delta Sharing ?.

- Databricks vers Databricks Delta Sharing est entièrement managé sans avoir besoin d’échanger des jetons.

- Créez et gérez des fournisseurs, des destinataires et des partages avec une interface utilisateur simple.

- Créez et gérez des fournisseurs, des destinataires et des partages avec des API SQL et REST et une prise en charge complète de l’interface CLI et de Terraform.

- Interrogez les modifications apportées aux données ou partagez des versions incrémentielles avec des flux de données modifiées.

- Limitez l’accès des destinataires au téléchargement de fichiers d’informations d’identification ou à l’interrogation de données à l’aide de listes d’accès IP et de restrictions régionales.

- L’utilisation de Delta Sharing pour partager des données dans le même compte Azure Databricks est activée par défaut.

- Répartissez les tâches en déléguant la gestion de Delta Sharing aux non-administrateurs.

Databricks Runtime 11.2 (bêta)

23 août 2022

Databricks Runtime 11.2, 11.2 Photon et 11.2 ML sont désormais disponibles en versions bêta.

Consultez les notes de publication complètes dans Databricks Runtime 11.2 (EoS) et Databricks Runtime 11.2 pour Machine Learning (EoS).

Volume de messages réduit dans l’interface utilisateur Delta Live Tables pour les pipelines continus

22-29 août 2022 : Version 3.79

Avec cette version, les transitions d’état pour les tables actives dans un pipeline continu Delta Live Tables sont affichées dans l’interface utilisateur uniquement jusqu’à ce que les tables entrent dans l’état en cours d’exécution. Toutes les transitions liées au recalcul réussi des tables ne sont pas affichées dans l’interface utilisateur, mais sont disponibles dans le journal des événements Delta Live Tables au niveau MÉTRIQUES. Toutes les transitions vers les états d’échec sont toujours affichées dans l’interface utilisateur. Auparavant, toutes les transitions d’état étaient affichées dans l’interface utilisateur pour les tables actives. Cette modification réduit le volume d’événements de pipeline affichés dans l’interface utilisateur et facilite la recherche de messages importants pour vos pipelines. Pour en savoir plus sur l’interrogation du journal des événements, consultez Qu’est-ce que le journal des événements Delta Live Tables.

Configuration de cluster simplifiée pour vos pipelines Delta Live Tables

22-29 août 2022 : Version 3.79

Vous pouvez maintenant sélectionner un mode de cluster, avec mise à l’échelle automatique ou taille fixe, directement dans l’interface utilisateur Delta Live Tables lorsque vous créez un pipeline. Auparavant, la configuration d’un cluster avec mise à l’échelle automatique nécessitait d’apporter des modifications aux paramètres JSON du pipeline. Pour plus d’informations sur la création d’un pipeline et le paramètre du nouveau mode cluster, consultez Exécuter une mise à jour sur un pipeline Delta Live Tables.

Orchestrer des tâches dbt dans vos workflows Databricks (préversion publique)

22-29 août 2022 : Version 3.79

Vous pouvez exécuter votre projet dbt core en tant que tâche dans un travail Azure Databricks avec la nouvelle tâche dbt, ce qui vous permet d’inclure vos transformations dbt dans un workflow de traitement des données. Par exemple, votre workflow peut ingérer des données avec Auto Loader, les transformer avec dbt et les analyser avec une tâche de notebook. Pour plus d’informations sur la tâche dbt et obtenir un exemple, consultez Utiliser les transformations dbt dans un travail Azure Databricks. Pour plus d’informations sur la création, l’exécution et la planification d’un workflow comprenant la tâche dbt, consultez Planifier et orchestrer des workflows.

La fédération des identités est en disponibilité générale

25 août 2022

La fédération des identités simplifie l’administration d’Azure Databricks en vous permettant d’attribuer des utilisateurs au niveau du compte, des principaux de service et des groupes à des espaces de travail fédérés d’identité. Vous pouvez désormais configurer et gérer tous vos utilisateurs, principaux de service et groupes une fois dans la console de compte, plutôt que de répéter la configuration séparément dans chaque espace de travail. Pour en savoir plus sur la fédération des identités, consultez Comment les administrateurs attribuent-ils des utilisateurs à des espaces de travail ?. Pour commencer, consultez Comment les administrateurs activent-ils la fédération d’identité sur un espace de travail ?.

Partner Connect prend en charge la connexion à Stardog

24 août 2022

Vous pouvez désormais facilement créer une connexion entre Stardog et votre espace de travail Azure Databricks à l’aide de Partner Connect. Stardog fournit une plateforme de graphe de connaissances pour répondre à des requêtes complexes entre les silos de données.

Intégration de Databricks Feature Store à la fonctionnalité Serverless Real-Time Inference

22-29 août 2022 : Version 3.79

Databricks Feature Store prend désormais en charge la recherche automatique de caractéristiques pour la fonctionnalité Serverless Real-Time Inference. Pour plus d’informations, consultez recherche de fonctionnalités automatiques avec le service de modèles Databricks.

Prise en charge de types de données supplémentaires pour la recherche automatique des caractéristiques de Databricks Feature Store

22-29 août 2022 : Version 3.79

Databricks Feature Store prend désormais en charge BooleanType pour la recherche automatique des caractéristiques. Consultez Recherche automatique de caractéristiques avec le service de modèles Databricks.

BYOK (Bring Your Own Key) : Chiffrer les informations d’identification Git

23-29 août 2022

Vous pouvez utiliser une clé de chiffrement pour les informations d’identification Git pour Dépôts Databricks.

Consultez BYOK (Bring Your Own Key) : Chiffrer les informations d’identification Git.

Interface utilisateur des clusters disponible en préversion et remplacement du mode de sécurité par le mode d’accès

19 août 2022

La nouvelle interface utilisateur Créer un cluster est disponible en préversion. Consultez Informations de référence sur la configuration de calcul.

Limitations Unity Catalog (préversion publique)

16 août 2022

- Scala, R et les charges de travail utilisant le Runtime Machine Learning sont pris en charge uniquement sur les clusters utilisant le mode d’accès Utilisateur unique. Les charges de travail dans ces langages ne prennent pas en charge les vues dynamiques dans le cadre de la sécurité au niveau des lignes ou des colonnes.

- Les clones peu profonds ne sont pas pris en charge lors de l’utilisation d’Unity Catalog comme source ou cible du clone.

- Le compartimentage n’est pas pris en charge pour les tables Unity Catalog. Les commandes qui tentent de créer une table compartimentée dans Unity Catalog lèvent une exception.

- Le mode de remplacement des opérations d’écriture DataFrame dans Unity Catalog est pris en charge pour les tables Delta, mais pas pour les autres formats de fichier. L’utilisateur doit disposer du privilège

CREATEsur le schéma parent et doit être le propriétaire de l’objet existant. - La diffusion en continu présente actuellement les limites suivantes :

- Elle n’est pas prise en charge dans les clusters qui utilisent le mode d’accès Partagé. Pour les charges de travail de diffusion en continu, vous devez utiliser le mode d’accès Utilisateur unique.

- Les points de contrôle asynchrones ne sont pas encore pris en charge.

- Les requêtes de diffusion en continu d’une durée supérieure à 30 jours sur les clusters généraux ou de travaux lèvent une exception. Pour les requêtes de diffusion en continu durable, configurez les nouvelles tentatives automatiques.

- Le référencement des tables Unity Catalog à partir de pipelines Delta Live Tables n’est actuellement pas pris en charge.

- Les groupes précédemment créés dans un espace de travail ne peuvent pas être utilisés dans les instructions GRANT de Unity Catalog. Cela permet d’obtenir une vue cohérente des groupes qui peuvent s’étendre sur plusieurs espaces de travail. Pour utiliser des groupes dans les instructions GRANT, créez vos groupes dans le console de compte et mettez à jour toute automatisation dédiée à la gestion des principaux ou des groupes (comme les connecteurs SCIM, Okta et Microsoft Entra ID, et Terraform) afin de référencer les points de terminaison du compte au lieu des points de terminaison de l’espace de travail.

Unity Catalog est disponible dans les régions suivantes :

canadacentralcentralusfrancecentralgermanywestcentraljapaneastnorwayeastsouthafricanorthswedencentralswitzerlandnorthswitzerlandwestuaenorthwestcentraluswestus3australiaeastbrazilsouthcentralindiaeastuseastus2koreacentralnorthcentralusnortheuropesoutheastasiaukwestwesteuropewestus

Pour utiliser Unity Catalog dans une autre région, contactez l'équipe de votre compte.

Serverless Real-Time Inference en préversion publique

16 août 2022

Serverless Real-Time Inference traite vos modèles Machine Learning à l’aide de MLflow et les expose sous forme de points de terminaison d’API REST. Cette fonctionnalité utilise le calcul serverless, ce qui signifie que les points de terminaison et les ressources de calcul associées sont gérés et exécutés dans le compte cloud Azure Databricks. L’utilisation et le stockage sont actuellement gratuits, mais Azure Databricks vous informera dès qu’ils deviendront payants.

Les administrateurs d’espace de travail doivent activer Serverless Real-Time Inference dans votre espace de travail pour vous permettre d’utiliser cette fonctionnalité.

Pour participer à la préversion publique de l’inférence en temps réel sans serveur, contactez l’équipe de votre compte Azure Databricks.

Recherche améliorée dans l’espace de travail désormais en disponibilité générale

9 août 2022

Vous pouvez désormais rechercher des notebooks, des bibliothèques, des dossiers, des fichiers et des dépôts par nom. Vous pouvez également rechercher du contenu dans un notebook et afficher un aperçu du contenu correspondant. Les résultats de la recherche peuvent être filtrés par type. Consultez Recherche des objets de l’espace de travail.

Utiliser des colonnes générées lorsque vous créez des jeux de données Delta Live Tables

8-15 août 2022 : Version 3.78

Vous pouvez maintenant utiliser des colonnes générées lorsque vous définissez des tables dans vos pipelines Delta Live Tables. Les colonnes générées sont prises en charge par les interfaces Python et SQL de Delta Live Tables.

Mode d’édition amélioré pour les notebooks avec un éditeur basé sur Monaco (expérimental)

8-15 août 2022

Un nouvel éditeur de code basé sur Monaco est disponible pour les notebooks Python. Pour l’activer, cochez l’option Activer le nouvel éditeur de notebook sous l’onglet Paramètres de l’éditeur de la page Paramètres utilisateur.

Le nouvel éditeur comprend des indicateurs du type de paramètre, l’inspection des objets sur pointage, le pliage de code, la prise en charge de plusieurs curseurs, la sélection de colonnes (zones) et les différences côte à côte dans l’historique des versions du notebook.

Fin de la prise en charge de la série Databricks Runtime 10.3

2 août 2022

La prise en charge de Databricks Runtime 10.3 et Databricks Runtime 10.3 pour Machine Learning a pris fin le 2 août. Consultez Cycles de vie du support de Databricks.

Activer la connectivité privée avec Azure Private Link (préversion publique)

2 août 2022

Azure Databricks prend désormais en charge l’activation connexions Azure Private Link pour la connectivité privée entre les utilisateurs et leurs espaces de travail Azure Databricks, ainsi qu’entre des clusters sur le plan de calcul et les services principaux sur le plan de contrôle au sein de l’infrastructure de l’espace de travail Databricks. Azure Private Link se connecte directement aux services sans exposer le trafic au réseau public. Cette fonctionnalité est disponible en préversion publique. Voir Activer des connexions back-end et front-end Azure Private Link.

Activer les entrepôts SQL Serverless pour votre espace de travail (préversion publique)

2 août 2022

Les entrepôts SQL serverless sont désormais disponibles pour les comptes et les espaces de travail sur Azure Databricks en tant que préversion publique. Cette fonctionnalité nécessite le niveau tarifaire Premium. Avant de créer des entrepôts SQL serverless, un administrateur doit l’activer pour l’espace de travail.

Delta Live Tables prend désormais en charge l’actualisation des tables sélectionnées uniquement dans les mises à jour de pipeline

2-24 août 2022

Vous pouvez maintenant démarrer une mise à jour pour les tables sélectionnées uniquement dans un pipeline Delta Live Tables. Cette fonctionnalité accélère le test des pipelines et la résolution des erreurs en vous permettant de démarrer une mise à jour de pipeline qui actualise uniquement les tables sélectionnées. Pour découvrir comment démarrer uniquement une mise à jour des tables sélectionnées, consultez Exécuter une mise à jour sur un pipeline Delta Live Tables.

L’exécution du travail attend maintenant la fin de l’installation des bibliothèques de cluster

1er août 2022

Quand un cluster démarre, vos travaux Databricks attendent que les bibliothèques de cluster terminent l’installation avant de s’exécuter. Auparavant, les exécutions de travaux attendaient que les bibliothèques s’installent sur des clusters à usage unique uniquement s’ils étaient spécifiés en tant que bibliothèque dépendante pour le travail. Pour plus d’informations sur la configuration des bibliothèques dépendantes pour les tâches, consultez Configurer et modifier des tâches Databricks.