Monitorare un runtime di integrazione all'interno di una rete virtuale gestita

SI APPLICA A:  Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

Suggerimento

Provare Data Factory in Microsoft Fabric, una soluzione di analisi all-in-one per le aziende. Microsoft Fabric copre tutto, dallo spostamento dati al data science, all'analisi in tempo reale, alla business intelligence e alla creazione di report. Vedere le informazioni su come iniziare una nuova prova gratuita!

È possibile usare una rete virtuale gestita di Azure Data Factory per connettere in sicurezza le origini dati a una rete virtuale gestita dal servizio Data Factory. Usando questa funzionalità, è possibile definire un ambiente privato e isolato per i processi di integrazione e orchestrazione dei dati.

Quando si usa una rete virtuale gestita, si combinano le funzionalità di integrazione e orchestrazione dei dati di Data Factory con le caratteristiche di sicurezza e flessibilità delle reti virtuali di Azure. Consente di creare pipeline di integrazione dei dati affidabili, scalabili e sicure, in grado di collegarsi facilmente alle risorse di rete, sia in locale che nel cloud.

Un problema comune agli ambienti di calcolo gestito è la mancanza di visibilità su prestazioni e integrità, soprattutto all'interno di un ambiente di rete virtuale gestito. Senza un monitoraggio adeguato, identificare e risolvere i problemi può diventare difficile, con conseguente possibilità di ritardi, errori e riduzione del livello delle prestazioni.

Usando le funzionalità di monitoraggio avanzato integrate in Data Factory, invece, è possibile ottenere preziose informazioni sui processi di integrazione dei dati, da cui possono conseguire miglioramenti in termini di efficienza, utilizzo delle risorse e prestazioni complessive. Potendo contare su un monitoraggio proattivo e avvisi tempestivi, è possibile risolvere i problemi, ottimizzare i flussi di lavoro e garantire una corretta esecuzione delle pipeline di integrazione dei dati all'interno dell'ambiente di rete virtuale gestita.

Nuove metriche

L'introduzione di nuove metriche contribuisce a migliorare la visibilità e le funzionalità di monitoraggio all'interno di ambienti di rete virtuale gestiti.

Azure Data Factory offre tre diversi tipi di pool di calcolo:

- Calcolo per un'attività di copia

- Calcolo per un'attività della pipeline, ad esempio una ricerca

- Calcolo per un'attività esterna, ad esempio un notebook di Azure Databricks

Questi pool di calcolo offrono i livelli di flessibilità e scalabilità necessari per supportare diversi carichi di lavoro e allocare le risorse in modo ottimale. Ognuno di essi viene personalizzato per gestire specifici requisiti di esecuzione delle attività.

Per garantire un monitoraggio coerente e completo in tutti i pool di calcolo, sono stati implementati gli stessi set di metriche di monitoraggio:

- Utilizzo della capacità

- Percentuale di capacità disponibile

- Lunghezza della coda di attesa

Indipendentemente dal tipo di pool di calcolo in uso, è possibile impiegare e analizzare un set di metriche standardizzato per ottenere informazioni dettagliate sulle prestazioni e l'integrità delle attività di integrazione dei dati.

Nota

Queste metriche sono valide solo quando si abilita una durata (TTL) in un runtime di integrazione all'interno di una rete virtuale gestita.

| Metric | Unità | Descrizione |

|---|---|---|

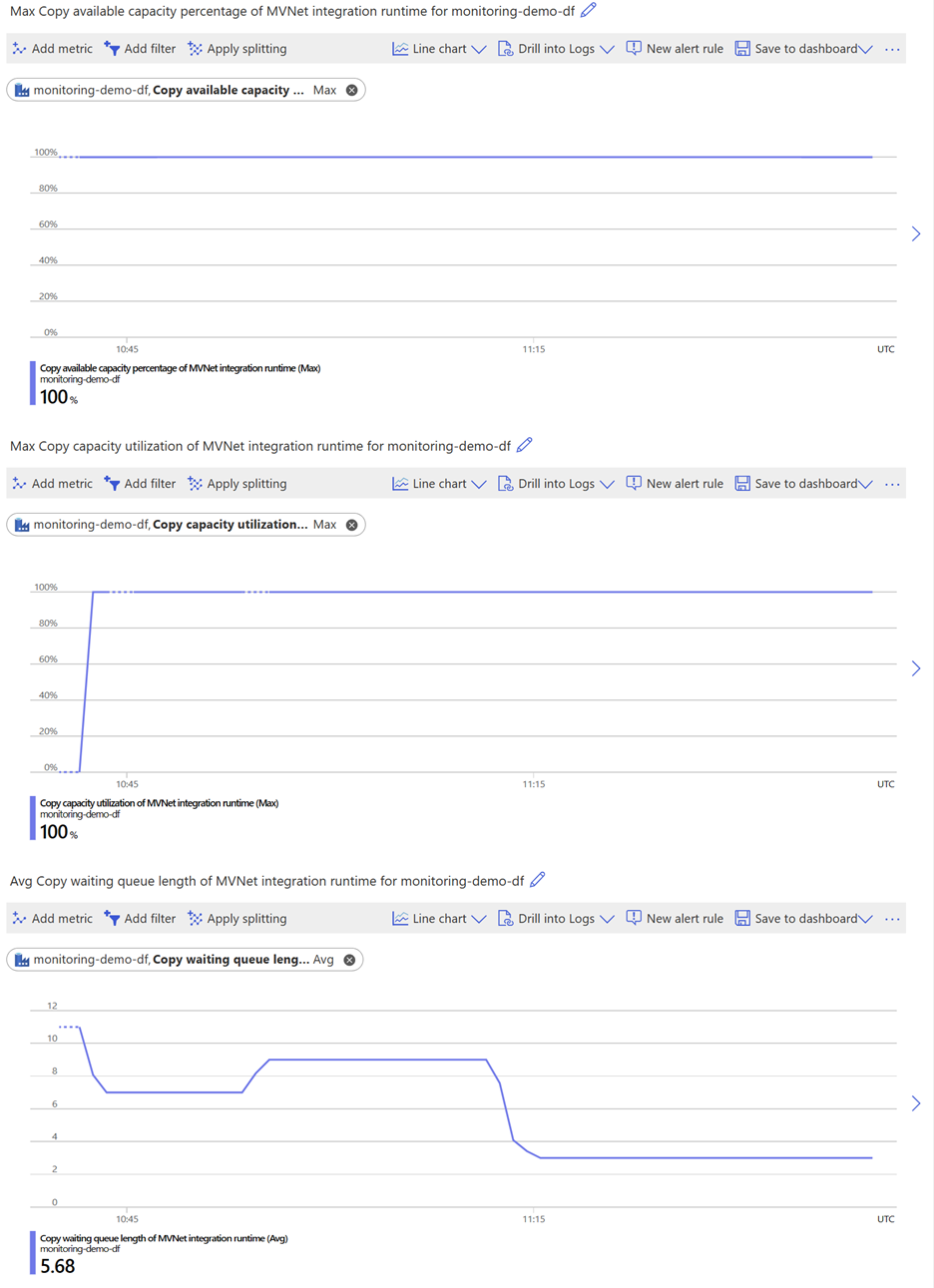

| Utilizzo della capacità di copia del runtime di integrazione MVNet | Percentuale | Percentuale massima di utilizzo dell'unità di integrazione dati per attività di copia TTL in un runtime di integrazione di una rete virtuale gestita in un intervallo di 1 minuto. |

| Percentuale di capacità di copia disponibile del runtime di integrazione MVNet | Percentuale | Percentuale massima di unità di integrazione dati disponibile per attività di copia TTL in un runtime di integrazione di una rete virtuale gestita in un intervallo di 1 minuto. |

| Lunghezza della coda in attesa di copia del runtime di integrazione MVNet | Conteggio | Lunghezza della coda in attesa di attività di copia TTL in un runtime di integrazione di una rete virtuale gestita in un intervallo di 1 minuto. |

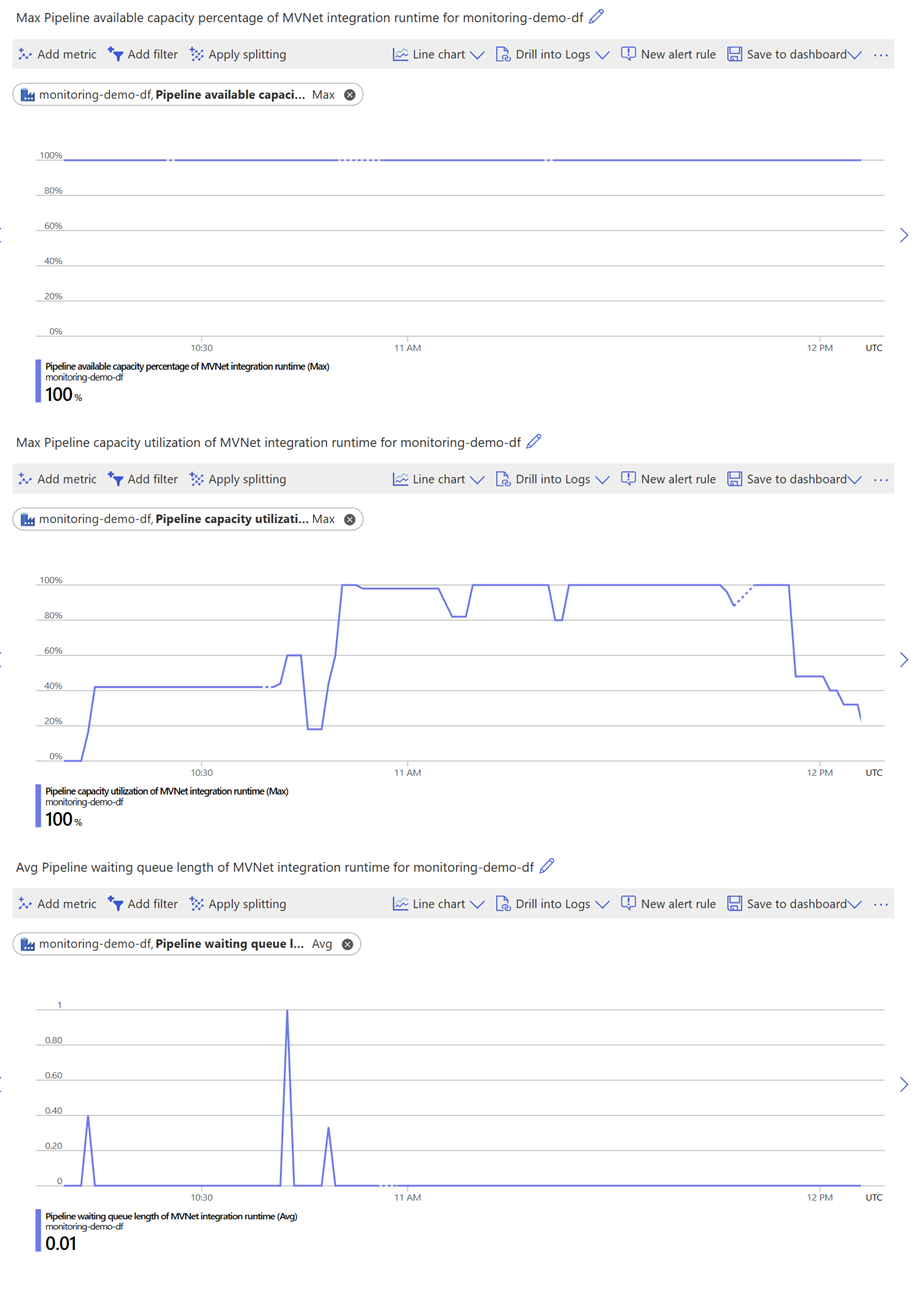

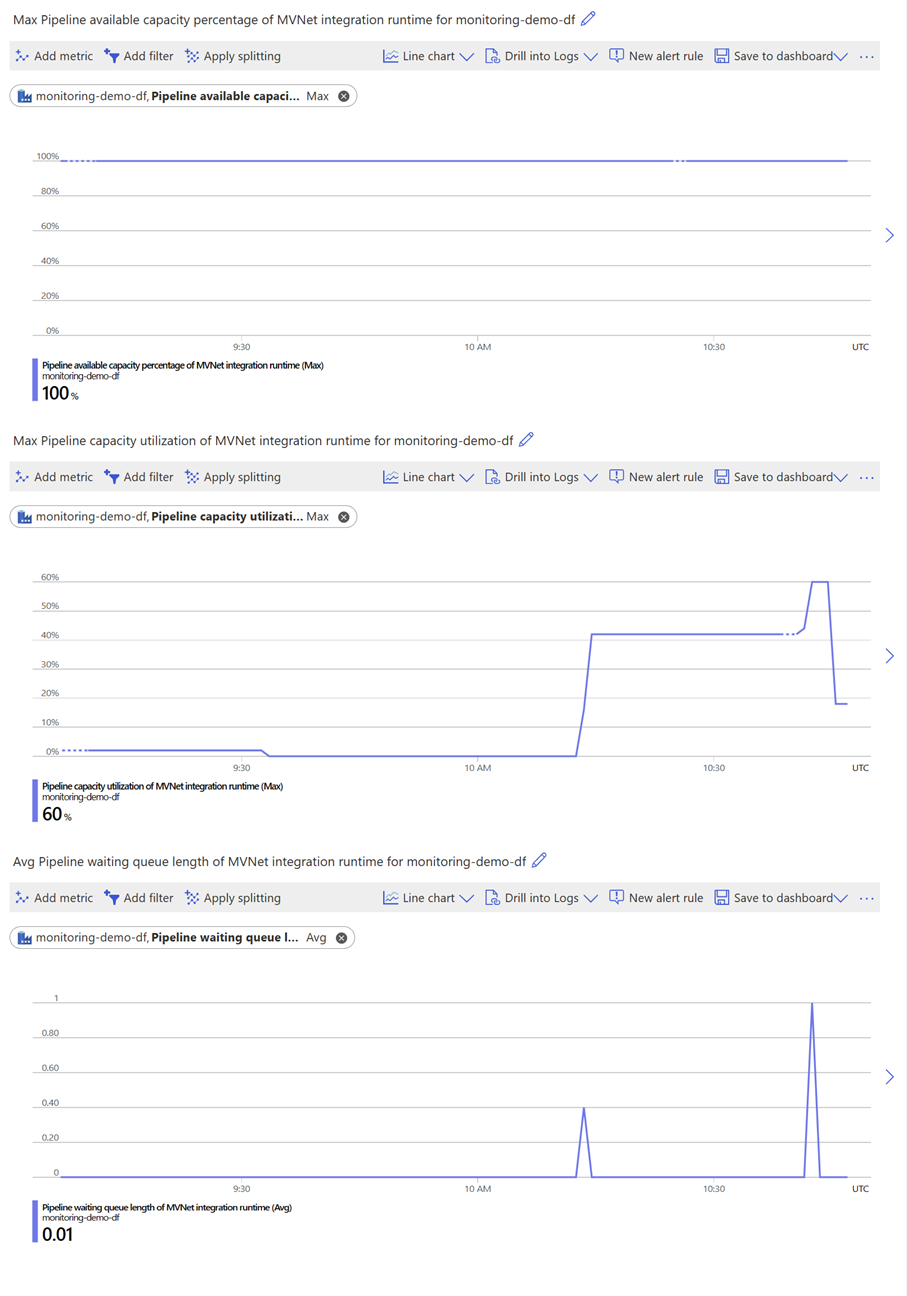

| Utilizzo della capacità di pipeline del runtime di integrazione MVNet | Percentuale | Percentuale massima di utilizzo dell'unità di integrazione dati per attività di pipeline in un runtime di integrazione di una rete virtuale gestita in un intervallo di 1 minuto. |

| Percentuale di capacità di pipeline disponibile del runtime di integrazione MVNet | Percentuale | Percentuale massima di unità di integrazione dati disponibile per attività di pipeline in un runtime di integrazione di una rete virtuale gestita in un intervallo di 1 minuto. |

| Lunghezza della coda in attesa di pipeline del runtime di integrazione MVNet | Conteggio | Lunghezza della coda in attesa di attività di pipeline in un runtime di integrazione di una rete virtuale gestita in un intervallo di 1 minuto. |

| Utilizzo della capacità esterna del runtime di integrazione MVNet | Percentuale | Percentuale massima di utilizzo dell'unità di integrazione dati per attività esterne in un runtime di integrazione di una rete virtuale gestita in un intervallo di 1 minuto. |

| Percentuale di capacità esterna disponibile del runtime di integrazione MVNet | Percentuale | Percentuale massima di unità di integrazione dati disponibile per attività esterne in un runtime di integrazione di una rete virtuale gestita in un intervallo di 1 minuto. |

| Lunghezza della coda in attesa di attività esterne del runtime di integrazione MVNet | Conteggio | Lunghezza della coda in attesa di attività esterne in un runtime di integrazione di una rete virtuale gestita in un intervallo di 1 minuto. |

Per altre informazioni su queste metriche, vedere Metriche supportate per Microsoft.DataFactory/factory.

Utilizzo delle metriche per l'ottimizzazione delle prestazioni

Ricorrendo alle metriche, è possibile monitorare e valutare facilmente le prestazioni e l'affidabilità del runtime di integrazione in una rete virtuale gestita. È anche possibile individuare potenziali aree di miglioramento continuo ottimizzando le impostazioni di calcolo e il flusso di lavoro nell'ottica dell'efficienza.

Per fornire maggiore chiarezza sull'applicazione pratica di queste metriche, sono riportati di seguito alcuni scenari di esempio.

Balanced

Se si nota che l'utilizzo della capacità è inferiore al 100% e la percentuale di capacità disponibile è elevata, le risorse di calcolo riservate vengono usate in modo efficiente.

Se la lunghezza della coda in attesa rimane costantemente bassa o presenta solo brevi picchi occasionali, è consigliabile accodare altre attività finché non si raggiunge la capacità del 100%. Questo approccio garantisce un utilizzo ottimale delle risorse e consente di mantenere un flusso di lavoro lineare, con ritardi minimi.

Orientato alle prestazioni

Se si nota che l'utilizzo della capacità è costantemente basso e la lunghezza della coda in attesa rimane costantemente bassa o presenta solo picchi brevi occasionali, le risorse di calcolo riservate sono superiori alla domanda di attività.

In questi casi, indipendentemente dal fatto che la percentuale di capacità disponibile sia alta o bassa, è consigliabile ridurre le risorse di calcolo allocate per diminuire i costi. Adeguando la capacità di calcolo ai requisiti del carico di lavoro, è possibile ottimizzare l'utilizzo delle risorse e risparmiare sui costi senza compromettere l'efficienza delle operazioni.

Orientato ai costi

Se si nota che tutte le metriche (tra cui utilizzo della capacità, percentuale di capacità disponibile e lunghezza della coda in attesa) sono elevate, le risorse di calcolo riservate sono probabilmente insufficienti per le attività.

In questo scenario è consigliabile aumentare le risorse di calcolo allocate per ridurre il tempo di attesa. L'aggiunta di una maggiore capacità di calcolo garantisce che le attività dispongano di risorse sufficienti per un'esecuzione efficiente, riducendo al minimo eventuali ritardi causati da una coda affollata.

Esecuzione di attività intermittenti

Se si nota che la percentuale di capacità disponibile è molto incostante in uno specifico intervallo di tempo, è probabile che questo sia dovuto a un'esecuzione intermittente delle attività, in cui la durata (TTL) configurata è più breve dell'intervallo tra le attività. Questo può avere un impatto significativo sulle prestazioni del flusso di lavoro. Per risolvere questo problema, esistono due possibili soluzioni. La prima prevede di accodare più attività per mantenere un carico di lavoro coerente e usare le risorse di calcolo disponibili in modo più efficace. Mantenendo le risorse di calcolo costantemente impegnate, è possibile evitare il tempo di riscaldamento e ottenere prestazioni migliori. In alternativa, è possibile aumentare la durata per allinearla all'intervallo tra le attività. Questo garantisce che le risorse di calcolo rimangano disponibili per una durata più lunga, riducendo la frequenza dei periodi di riscaldamento e ottimizzando l'efficienza dei costi.

Implementando una di queste soluzioni, è possibile migliorare le prestazioni del flusso di lavoro, ridurre al minimo le implicazioni sui costi e garantire un'esecuzione più fluida delle attività intermittenti.

Contenuto correlato

Leggere l'articolo seguente per informazioni sulle reti virtuali gestite e sugli endpoint privati gestiti: Rete virtuale gestita di Azure Data Factory.