Passaggio 4. Valutare la qualità del modello di verifica

Per il codice di esempio in questa sezione, vedere il repository GitHub.

Tempo previsto: 5 - 60 minuti. Il tempo varia in base al numero di domande nel set di valutazione. Per 100 domande, la valutazione richiede circa 5 minuti.

Panoramica e risultato previsto

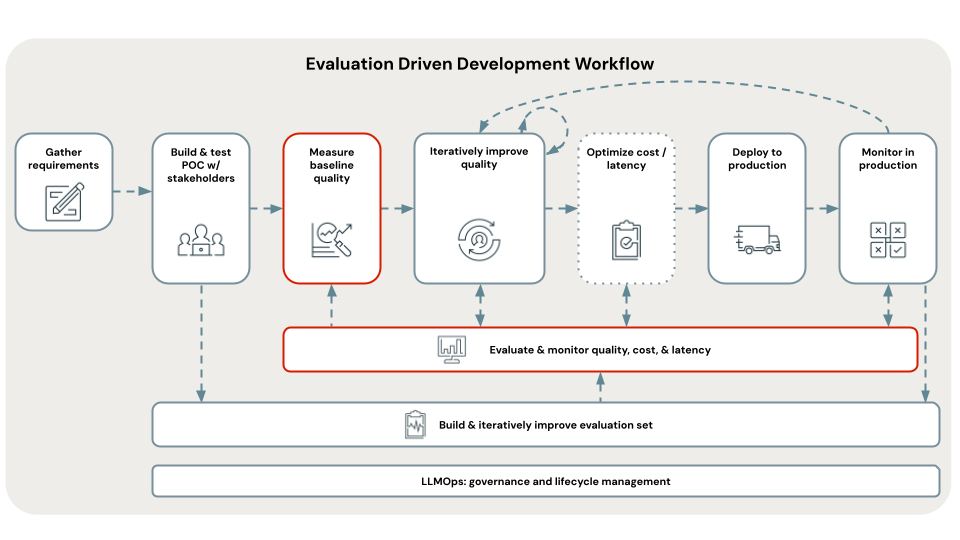

Questo passaggio usa il set di valutazione appena curato per valutare l'app poC e stabilire la qualità, i costi e la latenza di base. I risultati della valutazione vengono usati dal passaggio successivo per identificare la causa radice di eventuali problemi di qualità.

La valutazione viene eseguita usando la valutazione dell'agente di intelligenza artificiale Mosaic e esamina in modo completo tutti gli aspetti della qualità, dei costi e della latenza descritti nella sezione metriche di questo cookbook.

Le metriche aggregate e la valutazione di ogni domanda nel set di valutazione vengono registrate in MLflow. Per informazioni dettagliate, vedere Output di valutazione.

Requisiti

- Il set di valutazione è disponibile.

- Tutti i requisiti dei passaggi precedenti.

Istruzioni

- Aprire il

05_evaluate_poc_qualitynotebook nella directory poC scelta e fare clic su Esegui tutto. - Esaminare i risultati della valutazione nel notebook o usando MLflow. Se i risultati soddisfano i requisiti di qualità, è possibile passare direttamente a [Distribuire e monitorare] . Poiché l'applicazione POC è basata su Databricks, è pronta per essere distribuita in un'API REST scalabile e pronta per la produzione.

Passaggio successivo

Usando questa valutazione di base della qualità del modello di verifica, identificare le cause radice di eventuali problemi di qualità e risolvere in modo iterativo tali problemi per migliorare l'app. Vedere Passaggio 5. Identificare la causa radice dei problemi di qualità.