Opzioni per ottenere i dati in Fabric Lakehouse

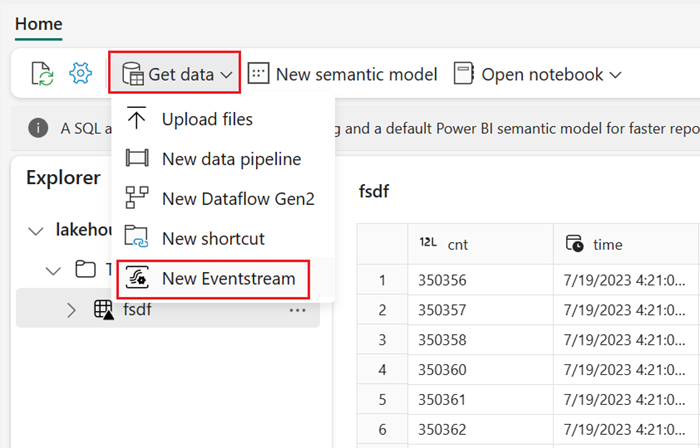

L'esperienza di recupero dei dati copre tutti gli scenari utente per l'inserimento dei dati nel lakehouse, ad esempio:

- Connessione al SQL Server esistente e copia dei dati nella tabella Delta nel lakehouse.

- Caricamento di file dal computer.

- Copia e unione di più tabelle da altri lakehouse in una nuova tabella Delta.

- Connessione a un'origine di streaming per trasferire i dati in un lakehouse.

- Riferimento ai dati senza copiarli da altri lakehouse interni o da origini esterne.

Modi differenti per caricare i dati in un lakehouse

In Microsoft Fabric, esistono diversi modi per inserire i dati in un lakehouse:

- Caricare file da un computer locale

- Eseguire uno strumento Copia nelle pipeline

- Configurare un flusso di dati

- Librerie Apache Spark nel codice del notebook

- Trasmettere eventi in tempo reale con Eventstream

- Ottenere dati da Eventhouse

Caricamento di file in locale

È anche possibile caricare i dati archiviati nel computer locale. Questa operazione può essere effettuata direttamente in Esplora lakehouse.

Strumento Copia nelle pipeline

Lo strumento Copia è una soluzione di integrazione dei dati altamente scalabile che consente di collegarsi a diverse origini di dati e di caricare i dati nel formato originale o convertirli in una tabella Delta. Lo strumento Copia fa parte delle attività delle pipeline che è possibile modificare in diversi modi, ad esempio la pianificazione o l'attivazione in base a un evento. Per altre informazioni, si veda Come copiare i dati usando l'attività Copy.

Dataflows

Per gli utenti che hanno familiarità con i flussi di dati di Power BI, lo stesso strumento è disponibile per caricare i dati nel lakehouse. È possibile accedervi rapidamente dall'opzione “Ottieni dati” di Esplora lakehouse e caricare i dati da oltre 200 connettori. Per altre informazioni, vedere Avvio rapido: creare il primo flusso di dati per ottenere e trasformare i dati.

Codice del notebook

È possibile usare le librerie Spark disponibili per connettersi direttamente a un'origine dati, caricare i dati in un DataFrame e poi salvarli in un lakehouse. Questo metodo è il modo più semplice per caricare i dati nel lakehouse che il codice utente gestisce completamente.

Nota

Le tabelle Delta esterne create con il codice Spark non saranno visibili a un endpoint di Analisi SQL. Usare i collegamenti nello spazio Tabella per rendere visibili le tabelle Delta esterne all'endpoint di Analisi SQL. Per informazioni su come creare un collegamento, vedere Creare un collegamento a file o tabelle.

Trasmettere eventi in tempo reale con Eventstream

Con Eventstream è possibile ottenere, elaborare e instradare volumi elevati in tempo reale da un'ampia gamma di origini.

Per informazioni su come aggiungere lakehouse come destinazione per Eventstream, vedere Ottenere dati da Eventstream in un lakehouse.

Per ottenere prestazioni di streaming ottimali, è possibile trasmettere dati da Eventstream in Eventhouse e quindi abilitare la disponibilità di OneLake.

Ottenere dati da Eventhouse

Quando si abilita la disponibilità di OneLake sui dati Eventhouse, viene creata una tabella Delta in OneLake. Questa tabella Delta è accessibile da un lakehouse usando un collegamento. Per ulteriori informazioni, vedere Collegamenti di OneLake. Per altre informazioni, vedere Disponibilità di OneLake Eventhouse.

Considerazioni sulla scelta dell'approccio per caricare i dati

| Caso d'uso | Consiglio |

|---|---|

| Caricamento di file di piccole dimensioni da un computer locale | Usare il caricamento di file locali |

| Dati di piccole dimensioni o connettore specifico | Usare flussi di dati |

| Origine dati di grandi dimensioni | Usare lo strumento Copy nelle pipeline |

| Trasformazioni complesse di dati | Usare il codice del notebook |

| Streaming di dati | Usare Eventstream per trasmettere i dati in Eventhouse; abilitare la disponibilità di OneLake e creare un collegamento da Lakehouse |

| Dati di serie temporali | Ottenere dati da Eventhouse |

Contenuto correlato

- Esplorare i dati nel lakehouse con un notebook

- Avvio rapido: creare la prima pipeline per copiare i dati

- Come copiare dati usando l'attività Copy

- Spostare dati dal database di Azure SQL in Lakehouse tramite l'assistente copia

- Aggiungere una destinazione lakehouse a Eventstream

- Disponibilità di OneLake Eventhouse