일괄 처리 엔드포인트에 대한 작업 및 입력 데이터 만들기

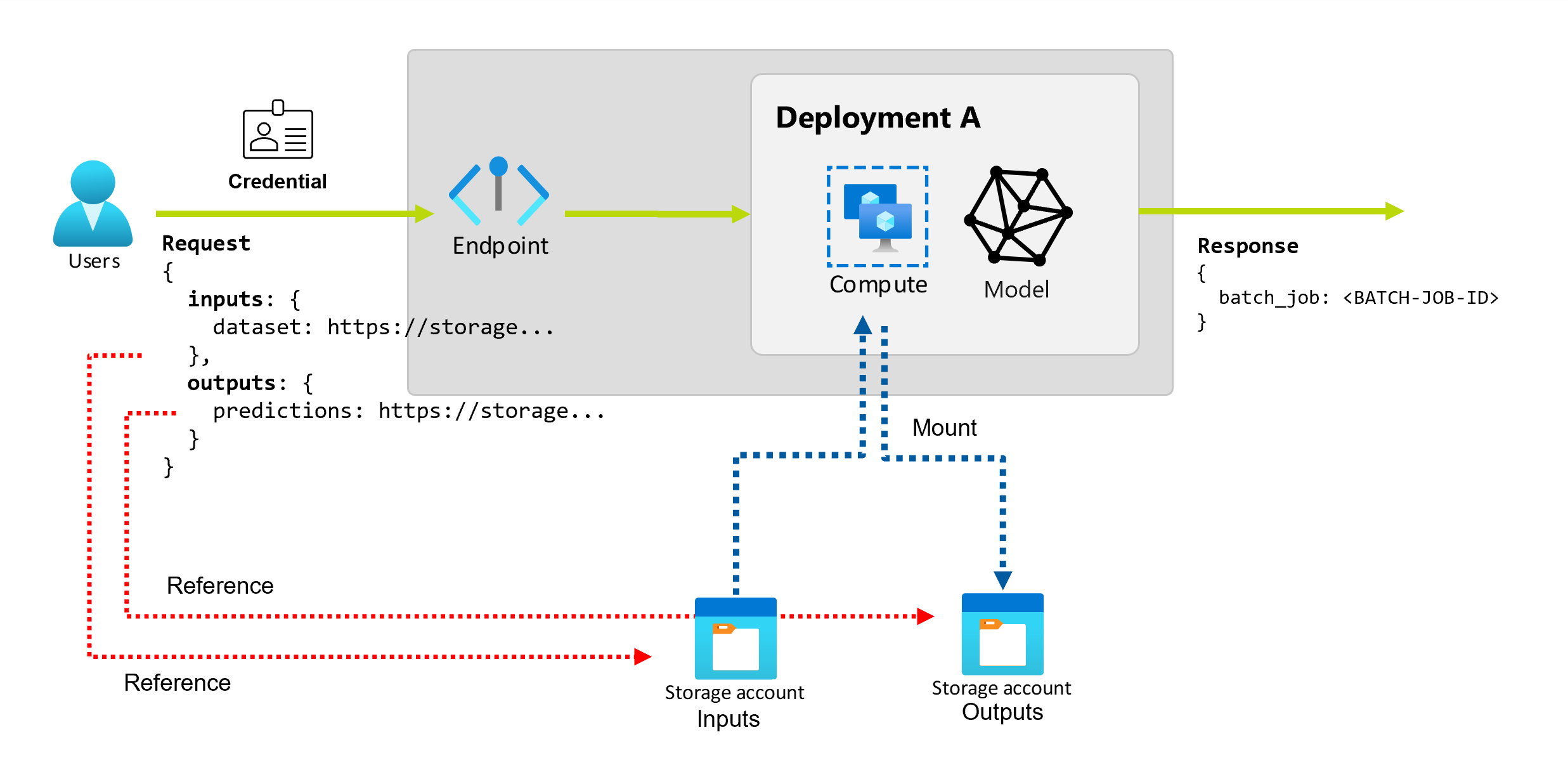

일괄 처리 엔드포인트를 사용하면 대량의 데이터에 대해 긴 일괄 처리 작업을 수행할 수 있습니다. 데이터는 분산 지역과 같은 여러 위치에 있을 수 있습니다. 특정 유형의 일괄 처리 엔드포인트는 리터럴 매개 변수를 입력으로 받을 수도 있습니다.

이 문서에서는 일괄 처리 엔드포인트에 대한 매개 변수 입력을 지정하고 배포 작업을 만드는 방법을 설명합니다. 이 프로세스는 다양한 유형의 데이터 작업을 지원합니다. 몇 가지 예제는 입력 및 출력 이해를 참조하세요.

필수 조건

일괄 처리 엔드포인트를 호출하고 작업을 만들려면 다음 필수 구성 요소를 완료해야 합니다.

일괄 처리 엔드포인트 및 배포. 이러한 리소스가 없는 경우 배포를 만들려면 일괄 처리 엔드포인트에서 채점을 위한 모델 배포를 참조하세요.

일괄 처리 엔드포인트 배포를 실행할 수 있는 권한. AzureML 데이터 과학자, 기여자 및 소유자 역할을 사용하여 배포를 실행할 수 있습니다. 사용자 지정 역할 정의의 경우 필요한 특정 권한을 검토하려면 일괄 처리 엔드포인트에서 권한 부여를 참조하세요.

엔드포인트를 호출할 보안 주체를 나타내는 유효한 Microsoft Entra ID 토큰. 이 주체는 사용자 주체 또는 서비스 주체일 수 있습니다. 엔드포인트를 호출한 후 Azure Machine Learning은 토큰과 연결된 ID 아래에 일괄 처리 배포 작업을 만듭니다. 다음 절차에 설명된 대로 호출에 고유한 자격 증명을 사용할 수 있습니다.

다양한 형식의 자격 증명을 사용하여 일괄 처리 배포 작업을 시작하는 방법에 대해 자세히 알아보려면 다양한 형식의 자격 증명을 사용하여 작업을 실행하는 방법을 참조하세요.

엔드포인트가 배포되는 컴퓨팅 클러스터는 입력 데이터를 읽을 수 있는 액세스 권한이 있습니다.

팁

자격 증명이 없는 데이터 저장소 또는 외부 Azure Storage 계정을 데이터 입력으로 사용하는 경우 데이터 액세스를 위해 컴퓨팅 클러스터를 구성해야 합니다. 컴퓨팅 클러스터의 관리 ID는 스토리지 계정을 탑재하는 데 사용됩니다. 작업 ID(호출자)는 기본 데이터를 읽는 데 계속 사용되므로 세분화된 액세스 제어를 달성할 수 있습니다.

작업 만들기 기본 사항

일괄 처리 엔드포인트에서 작업을 만들려면 엔드포인트를 호출합니다. 호출은 Azure CLI, Python용 Azure Machine Learning SDK 또는 REST API 호출을 사용하여 수행할 수 있습니다. 다음 예에서는 처리를 위해 단일 입력 데이터 폴더를 수신하는 일괄 처리 엔드포인트 호출의 기본 사항을 보여 줍니다. 입력 및 출력이 다른 예제는 입력 및 출력 이해를 참조하세요.

일괄 처리 엔드포인트에서 invoke 작업을 사용합니다.

az ml batch-endpoint invoke --name $ENDPOINT_NAME \

--input https://azuremlexampledata.blob.core.windows.net/data/heart-disease-uci/data

특정 배포 호출

일괄 처리 엔드포인트는 동일한 엔드포인트에서 여러 배포를 호스트할 수 있습니다. 사용자가 달리 지정하지 않는 한 기본 엔드포인트가 사용됩니다. 다음 절차에 사용할 배포를 변경할 수 있습니다.

인수 --deployment-name 또는 -d를 사용하여 배포 이름을 지정합니다.

az ml batch-endpoint invoke --name $ENDPOINT_NAME \

--deployment-name $DEPLOYMENT_NAME \

--input https://azuremlexampledata.blob.core.windows.net/data/heart-disease-uci/data

작업 속성 구성

호출 시 만들어진 작업의 일부 속성을 구성할 수 있습니다.

참고 항목

작업 속성을 구성하는 기능은 현재 파이프라인 구성 요소 배포를 사용하는 일괄 처리 엔드포인트에서만 사용할 수 있습니다.

실험 이름 구성

다음 절차에 따라 실험 이름을 구성합니다.

실험 이름을 지정하려면 인수 --experiment-name을 사용합니다.

az ml batch-endpoint invoke --name $ENDPOINT_NAME \

--experiment-name "my-batch-job-experiment" \

--input https://azuremlexampledata.blob.core.windows.net/data/heart-disease-uci/data

입력 및 출력 이해

일괄 처리 엔드포인트는 소비자가 일괄 작업을 만드는 데 사용할 수 있는 내구성 있는 API를 제공합니다. 동일한 인터페이스를 사용하여 배포에 필요한 입력과 출력을 지정할 수 있습니다. 입력을 사용하여 엔드포인트가 작업을 수행하는 데 필요한 정보를 전달합니다.

Batch 엔드포인트는 다음 두 가지 유형의 입력을 지원합니다.

- 데이터 입력: 특정 스토리지 위치 또는 Azure Machine Learning 자산에 대한 포인터입니다.

- 리터럴 입력: 작업에 전달하려는 숫자 또는 문자열과 같은 리터럴 값입니다.

입출력의 수와 형식은 일괄 처리 배포 형식에 따라 다릅니다. 모델 배포에는 항상 1개의 데이터 입력이 필요하고 1개의 데이터 출력이 생성됩니다. 리터럴 입력은 지원되지 않습니다. 그러나 파이프라인 구성 요소 배포는 엔드포인트를 빌드하는 보다 일반적인 구문을 제공하고 입력(데이터 및 리터럴) 및 출력 수를 지정할 수 있습니다.

다음 표에는 일괄 처리 배포에 대한 입력 및 출력이 요약되어 있습니다.

| 배포 유형 | 입력 수 | 지원되는 입력 유형 | 출력 수 | 지원되는 출력 형식 |

|---|---|---|---|---|

| 모델 배포 | 1 | 데이터 입력 | 1 | 데이터 출력 |

| 파이프라인 구성 요소 배포 | [0..N] | 데이터 입력 및 리터럴 입력 | [0..N] | 데이터 출력 |

팁

입력과 출력에는 항상 이름이 지정됩니다. 해당 이름은 데이터를 식별하고 호출하는 동안 실제 값을 전달하는 키 역할을 합니다. 모델 배포에는 항상 하나의 입력 및 출력이 필요하므로 호출하는 동안 이름이 무시됩니다. 사용 사례를 가장 잘 설명하는 이름(예: "sales_estimation")을 할당할 수 있습니다.

데이터 입력 살펴보기

데이터 입력은 데이터가 배치된 위치를 가리키는 입력을 나타냅니다. 일괄 처리 엔드포인트는 일반적으로 많은 양의 데이터를 소비하므로 호출 요청의 일부로 입력 데이터를 전달할 수 없습니다. 대신 데이터를 찾기 위해 일괄 처리 엔드포인트가 이동해야 하는 위치를 지정합니다. 성능 개선을 위해 입력 데이터가 대상 컴퓨팅에 탑재되고 스트리밍됩니다.

일괄 처리 엔드포인트는 다음 스토리지 옵션에 있는 파일 읽기를 지원합니다.

- 폴더(

uri_folder) 및 파일(uri_file)을 포함한 Azure Machine Learning 데이터 자산. - Azure Blob Storage, Azure Data Lake Storage Gen1 및 Azure Data Lake Storage Gen2를 포함한 Azure Machine Learning 데이터 저장소.

- Azure Data Lake Storage Gen1, Azure Data Lake Storage Gen2 및 Azure Blob Storage를 포함한 Azure Storage 계정.

- 로컬 데이터 폴더/파일(Azure Machine Learning CLI 또는 Python용 Azure Machine Learning SDK). 그러나 이 작업으로 인해 작업 중인 작업 영역의 기본 Azure Machine Learning 데이터 저장소에 로컬 데이터가 업로드됩니다.

Important

사용 중단 알림: FileDataset(V1) 형식의 데이터 세트는 더 이상 사용되지 않으며 나중에 사용 중지될 예정입니다. 이 기능을 사용하는 기존 일괄 처리 엔드포인트는 계속 작동합니다. GA CLIv2(2.4.0 이상) 또는 GA REST API(2022-05-01 이상)를 사용하여 만든 일괄 처리 엔드포인트는 V1 데이터 세트를 지원하지 않습니다.

리터럴 입력 살펴보기

리터럴 입력은 문자열, 숫자, 부울 값과 같이 호출 시 표시되고 분석될 수 있는 입력을 나타냅니다. 일반적으로 리터럴 입력을 사용하여 파이프라인 구성 요소 배포의 일부로 매개 변수를 엔드포인트에 전달합니다. 일괄 처리 엔드포인트는 다음 리터럴 형식을 지원합니다.

stringbooleanfloatinteger

리터럴 입력은 파이프라인 구성 요소 배포에서만 지원됩니다. 리터럴 입력을 사용하여 작업 만들기를 참조하여 지정하는 방법을 알아봅니다.

데이터 출력 살펴보기

데이터 출력은 일괄 작업의 결과가 일괄 처리되어야 하는 위치를 나타냅니다. 각 출력에는 식별 가능한 이름이 있으며 Azure Machine Learning은 명명된 각 출력에 고유한 경로를 자동으로 할당합니다. 필요에 따라 다른 경로를 지정할 수 있습니다.

Important

Batch 엔드포인트는 Azure Blob Storage 데이터 저장소에서 출력 작성만 지원합니다. 계층 구조 네임스페이스(Azure Datalake Gen2 또는 ADLS Gen2라고도 함)가 설정된 스토리지 계정에 기록해야 하는 경우 서비스가 완전히 호환되므로 스토리지 서비스를 Azure Blob Storage 데이터 저장소로 등록할 수 있습니다. 이러한 방식으로 일괄 처리 엔드포인트의 출력을 ADLS Gen2에 쓸 수 있습니다.

데이터 입력을 사용하여 작업 만들기

다음 예제에서는 작업을 만들고 데이터 자산, 데이터 저장소 및 Azure Storage 계정에서 데이터 입력을 가져오는 방법을 보여줍니다.

데이터 자산의 입력 데이터 사용

Azure Machine Learning 데이터 자산(이전의 데이터 세트)은 작업에 대한 입력으로 지원됩니다. 다음 단계에 따라 Azure Machine Learning의 등록된 데이터 자산에 저장된 데이터를 사용하여 일괄 처리 엔드포인트 작업을 실행합니다.

Warning

테이블(MLTable) 형식의 데이터 자산은 현재 지원되지 않습니다.

먼저 데이터 자산을 만듭니다. 이 데이터 자산은 일괄 처리 엔드포인트를 사용하여 병렬로 처리할 여러 CSV 파일이 있는 폴더로 구성됩니다. 데이터가 데이터 자산으로 이미 등록되어 있는 경우 이 단계를 건너뛰어도 됩니다.

YAML에서 데이터 자산 정의를 만듭니다.heart-dataset-unlabeled.yml

$schema: https://azuremlschemas.azureedge.net/latest/data.schema.json name: heart-dataset-unlabeled description: An unlabeled dataset for heart classification. type: uri_folder path: heart-classifier-mlflow/data그런 다음, 데이터 자산을 만듭니다.

az ml data create -f heart-dataset-unlabeled.yml입력 또는 요청을 만듭니다.

엔드포인트를 실행합니다.

--set인수를 사용하여 입력을 지정합니다.az ml batch-endpoint invoke --name $ENDPOINT_NAME \ --set inputs.heart_dataset.type="uri_folder" inputs.heart_dataset.path=$DATASET_ID모델 배포를 제공하는 엔드포인트의 경우 모델 배포에는 항상 하나의 데이터 입력만 필요하므로

--input인수를 사용하여 데이터 입력을 지정할 수 있습니다.az ml batch-endpoint invoke --name $ENDPOINT_NAME --input $DATASET_ID인수

--set는 여러 입력이 지정될 때 긴 명령을 생성하는 경향이 있습니다. 이러한 경우 입력을YAML파일에 배치하고--file인수를 사용하여 엔드포인트 호출에 필요한 입력을 지정합니다.inputs.yml

inputs: heart_dataset: azureml:/<datasset_name>@latest다음 명령을 실행합니다.

az ml batch-endpoint invoke --name $ENDPOINT_NAME --file inputs.yml

데이터 저장소의 입력 데이터 사용

일괄 배포 작업을 통해 Azure Machine Learning에 등록된 데이터 저장소의 데이터를 직접 참조할 수 있습니다. 이 예제에서는 먼저 Azure Machine Learning 작업 영역의 기본 데이터 저장소에 일부 데이터를 업로드한 다음, 일괄 처리 배포를 실행합니다. 다음 단계에 따라 데이터 저장소에 저장된 데이터를 사용하여 일괄 처리 엔드포인트 작업을 실행합니다.

Azure Machine Learning 작업 영역의 기본 데이터 저장소에 액세스합니다. 데이터가 다른 저장소에 있는 경우 해당 저장소를 대신 사용할 수 있습니다. 기본 데이터 저장소를 사용할 필요는 없습니다.

DATASTORE_ID=$(az ml datastore show -n workspaceblobstore | jq -r '.id')데이터 저장소 ID는

/subscriptions/<subscription>/resourceGroups/<resource-group>/providers/Microsoft.MachineLearningServices/workspaces/<workspace>/datastores/<data-store>등입니다.팁

작업 영역의 기본 Blob 데이터 저장소 이름은 workspaceblobstore입니다. 작업 영역에서 기본 데이터 저장소의 리소스 ID를 이미 알고 있는 경우 이 단계를 건너뛰어도 됩니다.

일부 샘플 데이터를 데이터 저장소에 업로드합니다.

이 예제에서는 Blob Storage 계정의 폴더

heart-disease-uci-unlabeled에 있는 폴더sdk/python/endpoints/batch/deploy-models/heart-classifier-mlflow/data에 리포지토리에 포함된 샘플 데이터를 이미 업로드했다고 가정합니다. 계속하기 전에 이 단계를 완료해야 합니다.입력 또는 요청을 만듭니다.

INPUT_PATH변수에 파일 경로를 배치합니다.DATA_PATH="heart-disease-uci-unlabeled" INPUT_PATH="$DATASTORE_ID/paths/$DATA_PATH"경로에 대한

paths변수가 데이터 저장소의 리소스 ID에 추가되는 방식을 확인합니다. 이 형식은 다음 값이 경로임을 나타냅니다.팁

azureml://datastores/<data-store>/paths/<data-path>형식을 사용하여 입력을 지정할 수도 있습니다.엔드포인트를 실행합니다.

--set인수를 사용하여 입력을 지정합니다.az ml batch-endpoint invoke --name $ENDPOINT_NAME \ --set inputs.heart_dataset.type="uri_folder" inputs.heart_dataset.path=$INPUT_PATH모델 배포를 제공하는 엔드포인트의 경우 모델 배포에는 항상 하나의 데이터 입력만 필요하므로

--input인수를 사용하여 데이터 입력을 지정할 수 있습니다.az ml batch-endpoint invoke --name $ENDPOINT_NAME --input $INPUT_PATH --input-type uri_folder인수

--set는 여러 입력이 지정될 때 긴 명령을 생성하는 경향이 있습니다. 이러한 경우 입력을YAML파일에 배치하고--file인수를 사용하여 엔드포인트 호출에 필요한 입력을 지정합니다.inputs.yml

inputs: heart_dataset: type: uri_folder path: azureml://datastores/<data-store>/paths/<data-path>다음 명령을 실행합니다.

az ml batch-endpoint invoke --name $ENDPOINT_NAME --file inputs.yml데이터가 파일인 경우 입력에

uri_file형식을 대신 사용합니다.

Azure Storage 계정의 입력 데이터 사용

Azure Machine Learning 일괄 처리 엔드포인트는 퍼블릭 및 프라이빗 둘 다에 해당하는 Azure Storage 계정의 클라우드 위치에서 데이터를 읽을 수 있습니다. 스토리지 계정에 저장된 데이터를 사용하여 일괄 처리 엔드포인트 작업을 실행하려면 다음 단계를 사용합니다.

스토리지 계정에서 데이터를 읽는 데 필요한 추가 구성에 대한 자세한 내용은 데이터 액세스를 위한 컴퓨팅 클러스터 구성을 참조하세요.

입력 또는 요청을 만듭니다.

엔드포인트를 실행합니다.

--set인수를 사용하여 입력을 지정합니다.az ml batch-endpoint invoke --name $ENDPOINT_NAME \ --set inputs.heart_dataset.type="uri_folder" inputs.heart_dataset.path=$INPUT_DATA모델 배포를 제공하는 엔드포인트의 경우 모델 배포에는 항상 하나의 데이터 입력만 필요하므로

--input인수를 사용하여 데이터 입력을 지정할 수 있습니다.az ml batch-endpoint invoke --name $ENDPOINT_NAME --input $INPUT_DATA --input-type uri_folder--set인수는 여러 입력이 지정될 때 긴 명령을 생성하는 경향이 있습니다. 이러한 경우 입력을YAML파일에 배치하고--file인수를 사용하여 엔드포인트 호출에 필요한 입력을 지정합니다.inputs.yml

inputs: heart_dataset: type: uri_folder path: https://azuremlexampledata.blob.core.windows.net/data/heart-disease-uci/data다음 명령을 실행합니다.

az ml batch-endpoint invoke --name $ENDPOINT_NAME --file inputs.yml데이터가 파일인 경우 입력에

uri_file형식을 대신 사용합니다.

리터럴 입력을 사용하여 작업 만들기

파이프라인 구성 요소 배포는 리터럴 입력을 사용할 수 있습니다. 다음 예에서는 append 값을 사용하여 string 형식의 score_mode라는 입력을 지정하는 방법을 보여줍니다.

입력을 YAML 파일에 배치하고 --file을 사용하여 엔드포인트 호출에 필요한 입력을 지정합니다.

inputs.yml

inputs:

score_mode:

type: string

default: append

다음 명령을 실행합니다.

az ml batch-endpoint invoke --name $ENDPOINT_NAME --file inputs.yml

값을 지정하기 위해 --set 인수를 사용할 수도 있습니다. 그러나 이 방법은 여러 입력이 지정된 경우 긴 명령을 생성하는 경향이 있습니다.

az ml batch-endpoint invoke --name $ENDPOINT_NAME \

--set inputs.score_mode.type="string" inputs.score_mode.default="append"

데이터 출력을 사용하여 작업 만들기

다음 예에서는 score라는 출력이 배치되는 위치를 변경하는 방법을 보여 줍니다. 완전성을 높이기 위해 이 예에서는 heart_dataset라는 입력도 구성합니다.

Azure Machine Learning 작업 영역에서 기본 데이터 저장소를 사용하여 출력을 저장합니다. Blob Storage 계정인 경우 작업 영역의 다른 데이터 저장소를 사용할 수 있습니다.

데이터 출력을 만듭니다.

OUTPUT_PATH변수를 설정합니다.DATA_PATH="batch-jobs/my-unique-path" OUTPUT_PATH="$DATASTORE_ID/paths/$DATA_PATH"완전성을 위해 데이터 입력도 만들어 봅니다.

INPUT_PATH="https://azuremlexampledata.blob.core.windows.net/data/heart-disease-uci/data"참고 항목

경로에 대한

paths변수가 데이터 저장소의 리소스 ID에 추가되는 방식을 확인합니다. 이 형식은 다음 값이 경로임을 나타냅니다.배포를 실행합니다.