Windows Machine Learning API를 사용하여 Windows 앱에 TensorFlow 모델 배포

이 마지막 섹션에서는 Windows ML을 사용하여 YOLO 모델을 평가하여 웹캠을 스트리밍하고 개체를 검색하기 위해 GUI를 사용하여 간단한 UWP 앱을 만드는 방법을 설명합니다.

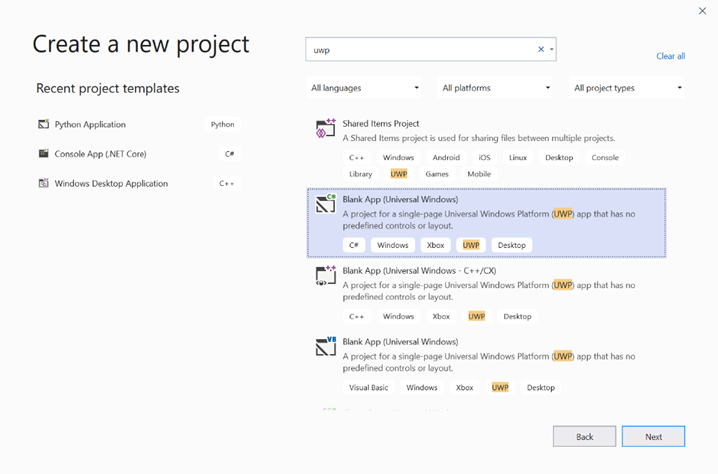

Visual Studio에서 UWP 앱 만들기

- Visual Studio를 열고

Create a new project.를 선택합니다. UWP를 검색하고Blank App (Universal Windows)을 선택합니다.

- 다음 페이지에서 프로젝트에 이름 및 위치를 지정하여 프로젝트 설정을 구성합니다. 그런 다음, 앱의 대상 및 최소 OS 버전을 선택합니다. Windows ML API를 사용하려면 X를 사용해야 합니다. 또는 X를 지원하도록 NuGet 패키지를 선택할 수 있습니다. NuGet 패키지를 사용하도록 선택한 경우 다음 지침 [링크]를 따릅니다.

Windows ML API를 호출하여 모델 평가

1단계: Machine Learning 코드 생성기를 사용하여 Windows ML API에 대한 래퍼 클래스를 생성합니다.

2단계: 생성된 .cs 파일에서 생성된 코드를 수정합니다. 마지막 파일은 다음과 같습니다.

using System;

using System.Collections.Generic;

using System.Threading.Tasks;

using Windows.Media;

using Windows.Storage;

using Windows.Storage.Streams;

using Windows.AI.MachineLearning;

namespace yolodemo

{

public sealed class YoloInput

{

public TensorFloat input_100; // shape(-1,3,416,416)

}

public sealed class YoloOutput

{

public TensorFloat concat_1600; // shape(-1,-1,-1)

}

public sealed class YoloModel

{

private LearningModel model;

private LearningModelSession session;

private LearningModelBinding binding;

public static async Task<YoloModel> CreateFromStreamAsync(IRandomAccessStreamReference stream)

{

YoloModel learningModel = new YoloModel();

learningModel.model = await LearningModel.LoadFromStreamAsync(stream);

learningModel.session = new LearningModelSession(learningModel.model);

learningModel.binding = new LearningModelBinding(learningModel.session);

return learningModel;

}

public async Task<YoloOutput> EvaluateAsync(YoloInput input)

{

binding.Bind("input_1:0", input.input_100);

var result = await session.EvaluateAsync(binding, "0");

var output = new YoloOutput();

output.concat_1600 = result.Outputs["concat_16:0"] as TensorFloat;

return output;

}

}

}

각 비디오 프레임을 평가하여 개체를 검색하고 경계 상자를 그립니다.

- 다음 라이브러리를 mainPage.xaml.cs에 추가합니다.

using System.Threading.Tasks;

using Windows.Devices.Enumeration;

using Windows.Media;

using Windows.Media.Capture;

using Windows.Storage;

using Windows.UI;

using Windows.UI.Xaml.Media.Imaging;

using Windows.UI.Xaml.Shapes;

using Windows.AI.MachineLearning;

public sealed partial class MainPage : Page에서 다음 변수를 추가합니다.

private MediaCapture _media_capture;

private LearningModel _model;

private LearningModelSession _session;

private LearningModelBinding _binding;

private readonly SolidColorBrush _fill_brush = new SolidColorBrush(Colors.Transparent);

private readonly SolidColorBrush _line_brush = new SolidColorBrush(Colors.DarkGreen);

private readonly double _line_thickness = 2.0;

private readonly string[] _labels =

{

"<list of labels>"

};

- 검색 결과의 형식을 지정하는 방법에 대한 구조를 만듭니다.

internal struct DetectionResult

{

public string label;

public List<float> bbox;

public double prob;

}

- Box 형식의 두 개체를 비교하는 Comparer 개체를 만듭니다. 이 클래스는 검색된 개체 주위에 경계 상자를 그리는 데 사용됩니다.

class Comparer : IComparer<DetectionResult>

{

public int Compare(DetectionResult x, DetectionResult y)

{

return y.prob.CompareTo(x.prob);

}

}

- 다음 메서드를 추가하여 디바이스의 웹캠 스트림을 초기화하고 각 프레임의 처리를 시작하여 개체를 검색합니다.

private async Task InitCameraAsync()

{

if (_media_capture == null || _media_capture.CameraStreamState == Windows.Media.Devices.CameraStreamState.Shutdown || _media_capture.CameraStreamState == Windows.Media.Devices.CameraStreamState.NotStreaming)

{

if (_media_capture != null)

{

_media_capture.Dispose();

}

MediaCaptureInitializationSettings settings = new MediaCaptureInitializationSettings();

var cameras = await DeviceInformation.FindAllAsync(DeviceClass.VideoCapture);

var camera = cameras.FirstOrDefault();

settings.VideoDeviceId = camera.Id;

_media_capture = new MediaCapture();

await _media_capture.InitializeAsync(settings);

WebCam.Source = _media_capture;

}

if (_media_capture.CameraStreamState == Windows.Media.Devices.CameraStreamState.NotStreaming)

{

await _media_capture.StartPreviewAsync();

WebCam.Visibility = Visibility.Visible;

}

ProcessFrame();

}

- 각 프레임을 처리하는 다음 메서드를 추가합니다. 이 메서드는 이후 단계에서 구현하는 EvaluateFrame 및 DrawBoxes를 호출합니다.

private async Task ProcessFrame()

{

var frame = new VideoFrame(Windows.Graphics.Imaging.BitmapPixelFormat.Bgra8, (int)WebCam.Width, (int)WebCam.Height);

await _media_capture.GetPreviewFrameAsync(frame);

var results = await EvaluateFrame(frame);

await DrawBoxes(results.ToArray(), frame);

ProcessFrame();

}

- 새 Sigmoid float 만들기

private float Sigmoid(float val)

{

var x = (float)Math.Exp(val);

return x / (1.0f + x);

}

- 개체를 올바르게 검색하기 위한 임계값을 만듭니다.

private float ComputeIOU(DetectionResult DRa, DetectionResult DRb)

{

float ay1 = DRa.bbox[0];

float ax1 = DRa.bbox[1];

float ay2 = DRa.bbox[2];

float ax2 = DRa.bbox[3];

float by1 = DRb.bbox[0];

float bx1 = DRb.bbox[1];

float by2 = DRb.bbox[2];

float bx2 = DRb.bbox[3];

Debug.Assert(ay1 < ay2);

Debug.Assert(ax1 < ax2);

Debug.Assert(by1 < by2);

Debug.Assert(bx1 < bx2);

// determine the coordinates of the intersection rectangle

float x_left = Math.Max(ax1, bx1);

float y_top = Math.Max(ay1, by1);

float x_right = Math.Min(ax2, bx2);

float y_bottom = Math.Min(ay2, by2);

if (x_right < x_left || y_bottom < y_top)

return 0;

float intersection_area = (x_right - x_left) * (y_bottom - y_top);

float bb1_area = (ax2 - ax1) * (ay2 - ay1);

float bb2_area = (bx2 - bx1) * (by2 - by1);

float iou = intersection_area / (bb1_area + bb2_area - intersection_area);

Debug.Assert(iou >= 0 && iou <= 1);

return iou;

}

- 다음 목록을 구현하여 프레임에서 검색된 현재 개체를 추적합니다.

private List<DetectionResult> NMS(IReadOnlyList<DetectionResult> detections,

float IOU_threshold = 0.45f,

float score_threshold=0.3f)

{

List<DetectionResult> final_detections = new List<DetectionResult>();

for (int i = 0; i < detections.Count; i++)

{

int j = 0;

for (j = 0; j < final_detections.Count; j++)

{

if (ComputeIOU(final_detections[j], detections[i]) > IOU_threshold)

{

break;

}

}

if (j==final_detections.Count)

{

final_detections.Add(detections[i]);

}

}

return final_detections;

}

- 다음 메서드를 구현합니다.

private List<DetectionResult> ParseResult(float[] results)

{

int c_values = 84;

int c_boxes = results.Length / c_values;

float confidence_threshold = 0.5f;

List<DetectionResult> detections = new List<DetectionResult>();

this.OverlayCanvas.Children.Clear();

for (int i_box = 0; i_box < c_boxes; i_box++)

{

float max_prob = 0.0f;

int label_index = -1;

for (int j_confidence = 4; j_confidence < c_values; j_confidence++)

{

int index = i_box * c_values + j_confidence;

if (results[index] > max_prob)

{

max_prob = results[index];

label_index = j_confidence - 4;

}

}

if (max_prob > confidence_threshold)

{

List<float> bbox = new List<float>();

bbox.Add(results[i_box * c_values + 0]);

bbox.Add(results[i_box * c_values + 1]);

bbox.Add(results[i_box * c_values + 2]);

bbox.Add(results[i_box * c_values + 3]);

detections.Add(new DetectionResult()

{

label = _labels[label_index],

bbox = bbox,

prob = max_prob

});

}

}

return detections;

}

- 다음 메서드를 추가하여 프레임에서 검색된 개체 주위에 상자를 그립니다.

private async Task DrawBoxes(float[] results, VideoFrame frame)

{

List<DetectionResult> detections = ParseResult(results);

Comparer cp = new Comparer();

detections.Sort(cp);

IReadOnlyList<DetectionResult> final_detetions = NMS(detections);

for (int i=0; i < final_detetions.Count; ++i)

{

int top = (int)(final_detetions[i].bbox[0] * WebCam.Height);

int left = (int)(final_detetions[i].bbox[1] * WebCam.Width);

int bottom = (int)(final_detetions[i].bbox[2] * WebCam.Height);

int right = (int)(final_detetions[i].bbox[3] * WebCam.Width);

var brush = new ImageBrush();

var bitmap_source = new SoftwareBitmapSource();

await bitmap_source.SetBitmapAsync(frame.SoftwareBitmap);

brush.ImageSource = bitmap_source;

// brush.Stretch = Stretch.Fill;

this.OverlayCanvas.Background = brush;

var r = new Rectangle();

r.Tag = i;

r.Width = right - left;

r.Height = bottom - top;

r.Fill = this._fill_brush;

r.Stroke = this._line_brush;

r.StrokeThickness = this._line_thickness;

r.Margin = new Thickness(left, top, 0, 0);

this.OverlayCanvas.Children.Add(r);

// Default configuration for border

// Render text label

var border = new Border();

var backgroundColorBrush = new SolidColorBrush(Colors.Black);

var foregroundColorBrush = new SolidColorBrush(Colors.SpringGreen);

var textBlock = new TextBlock();

textBlock.Foreground = foregroundColorBrush;

textBlock.FontSize = 18;

textBlock.Text = final_detetions[i].label;

// Hide

textBlock.Visibility = Visibility.Collapsed;

border.Background = backgroundColorBrush;

border.Child = textBlock;

Canvas.SetLeft(border, final_detetions[i].bbox[1] * 416 + 2);

Canvas.SetTop(border, final_detetions[i].bbox[0] * 416 + 2);

textBlock.Visibility = Visibility.Visible;

// Add to canvas

this.OverlayCanvas.Children.Add(border);

}

}

- 이제 필요한 인프라를 처리했으므로 평가 자체를 통합할 시간입니다. 이 메서드는 현재 프레임에 대해 모델을 평가하여 개체를 검색합니다.

private async Task<List<float>> EvaluateFrame(VideoFrame frame)

{

_binding.Clear();

_binding.Bind("input_1:0", frame);

var results = await _session.EvaluateAsync(_binding, "");

Debug.Print("output done\n");

TensorFloat result = results.Outputs["Identity:0"] as TensorFloat;

var shape = result.Shape;

var data = result.GetAsVectorView();

return data.ToList<float>();

}

- 앱을 시작해야 합니다. 사용자가

Go단추를 누를 때 웹캠 스트림과 모델 평가를 시작하는 메서드를 추가합니다.

private void button_go_Click(object sender, RoutedEventArgs e)

{

InitModelAsync();

InitCameraAsync();

}

- 메서드를 추가하여 Windows ML API를 호출하여 모델을 평가합니다. 먼저 모델이 스토리지에서 로드된 다음, 세션을 만들고 메모리에 바인딩합니다.

private async Task InitModelAsync()

{

var model_file = await StorageFile.GetFileFromApplicationUriAsync(new Uri("ms-appx:///Assets//Yolo.onnx"));

_model = await LearningModel.LoadFromStorageFileAsync(model_file);

var device = new LearningModelDevice(LearningModelDeviceKind.Cpu);

_session = new LearningModelSession(_model, device);

_binding = new LearningModelBinding(_session);

}

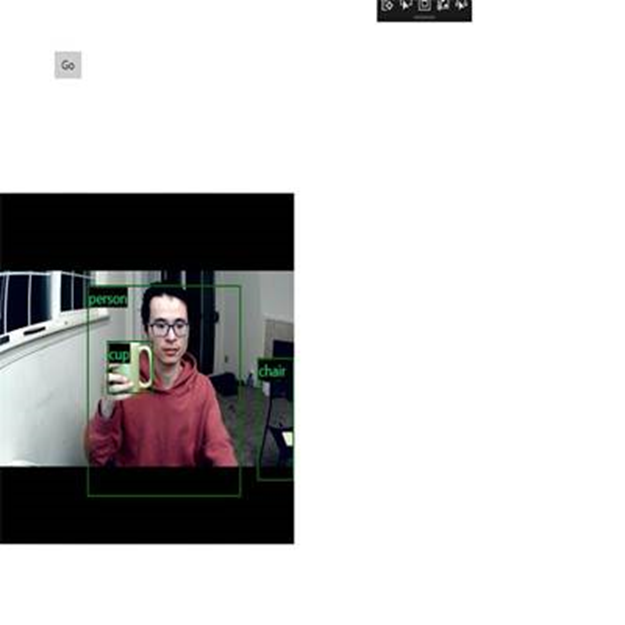

응용 프로그램 시작

이제 실시간 개체 검색 애플리케이션을 성공적으로 만들었습니다. Visual Studio의 위쪽 막대에서 Run 단추를 선택하여 앱을 시작합니다. 앱은 다음과 같이 표시되어야 합니다.

추가 리소스

이 자습서에서 언급한 항목에 대한 자세한 내용은 다음 리소스를 참조하세요.

- Windows ML 도구: Windows ML 대시보드 , WinMLRunner 및 mglen Windows ML 코드 생성기와 같은 도구에 대해 자세히 알아봅니다.

- ONNX 모델: ONNX 형식에 대해 자세히 알아봅니다.

- Windows ML 성능 및 메모리: Windows ML을 사용하여 앱 성능을 관리하는 방법에 대해 자세히 알아봅니다.

- Windows Machine Learning API 참조: Windows ML API의 세 가지 영역에 대해 자세히 알아봅니다.