Configurar a computação (herdada)

Observação

Estas instruções se aplicam à interface do usuário do cluster de criação herdada e são incluídas apenas para precisão histórica. Todos os clientes devem estar usando a interface do usuário do cluster de criação atualizada.

Este artigo explica as opções de configuração disponíveis quando você cria e edita clusters do Azure Databricks. Ele se concentra na criação e na edição de clusters com a interface do usuário. Para ver outros métodos, confira a CLI do Databricks, a API de Clusters e o provedor do Databricks Terraform.

Para decidir qual combinação das opções de configuração atende melhor às suas necessidades, confira as práticas recomendadas de configuração de cluster.

Política de cluster

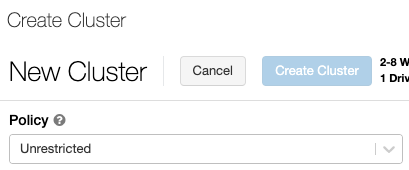

Uma política de cluster limita a capacidade de configurar clusters com base em um conjunto de regras. As regras de política limitam os atributos ou os valores de atributo disponíveis para a criação do cluster. As políticas de cluster têm ACLs que limitam seu uso a usuários e grupos específicos e, portanto, limitam quais políticas você pode selecionar na criação de um cluster.

Para configurar uma política de cluster, selecione a política de cluster na lista suspensa Política.

Observação

Se nenhuma política tiver sido criada no workspace, a lista suspensa Política não será exibida.

Se você tem:

- A permissão para criação de cluster, pode selecionar a política Irrestrita e criar clusters totalmente configuráveis. A política Irrestrita não limita os atributos de cluster ou valores de atributo.

- Tanto a permissão para criação de cluster quanto a de acesso às políticas de cluster, pode selecionar a política Irrestrita e as políticas às quais ele tem acesso.

- Acesso somente a políticas de cluster, pode selecionar as políticas às quais tem acesso.

Modo de cluster

Observação

Este artigo descreve a interface do usuário dos clusters herdados. Para obter informações sobre a nova interface do usuário de cluster (em pré-visualização), consulte Referência de configuração de computação. Isso inclui algumas alterações na terminologia dos tipos e modos de acesso do cluster. Para obter uma comparação dos tipos de cluster novos e herdados, consulte Alterações na interface do usuário dos clusters e modos de acesso do cluster. Na interface do usuário da versão prévia:

- Os clusters de modo padrão agora são chamados de Clusters de modo de acesso compartilhado sem isolamento.

- A alta simultaneidade com ACLs de tabelas agora é chamada de Clusters de modo de acesso compartilhado.

O Azure Databricks dá suporte a três modos de cluster: Padrão, Alta Simultaneidade e Nó Único. O modo de cluster padrão é o Padrão.

Importante

- Se o workspace estiver atribuído a um metastore do Catálogo do Unity, clusters de Alta Simultaneidade não estarão disponíveis. Em vez disso, você usa o modo de segurança para garantir a integridade dos controles de acesso e impor garantias de isolamento forte. Confira também Modos de acesso.

- Não é possível alterar o modo de cluster após sua criação. Se você quiser um modo de cluster diferente, deverá criar outro cluster.

A configuração de cluster inclui uma configuração de término automático cujo valor padrão depende do modo de cluster:

- Os clusters Padrão e Nó Único são terminados automaticamente após 120 minutos por padrão.

- Os clusters de Alta Simultaneidade não são terminados automaticamente por padrão.

Clusters padrão

Aviso

Os clusters de modo padrão (às vezes chamados de Clusters sem isolamento compartilhado) podem ser compartilhados por vários usuários, sem isolamento entre os usuários. Se você usar o modo de cluster de alta simultaneidade sem configurações de segurança adicionais, como ACLs de tabela ou Passagem de Credenciais, as mesmas configurações serão usadas como clusters de modo padrão. Os administradores da conta podem impedir que credenciais internas sejam geradas automaticamente para administradores de workspace do Databricks nesses tipos de cluster. Para opções mais seguras, o Databricks recomenda alternativas como clusters de alta simultaneidade com ACLs de tabela.

Um cluster padrão é recomendado apenas para um único usuário. Os clusters Padrão podem executar cargas de trabalho desenvolvidas no Python, SQL, R e Scala.

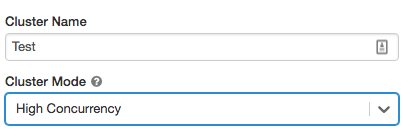

Clusters de Alta Simultaneidade

Um cluster de Alta Simultaneidade é um recurso de nuvem gerenciado. O principal benefício dos clusters de Alta Simultaneidade é o fornecimento de compartilhamento granular para a utilização máxima de recursos e latências de consulta mínimas.

Os clusters de Alta Simultaneidade podem executar cargas de trabalho desenvolvidas em SQL, Python e R. O desempenho e a segurança dos clusters de Alta Simultaneidade são concretizados pela execução do código do usuário em processos separados, o que não é possível em Scala.

Além disso, somente os clusters de Alta Simultaneidade dão suporte ao controle de acesso à tabela.

Para criar um cluster de Alta Simultaneidade, defina o modo de cluster como Alta Simultaneidade.

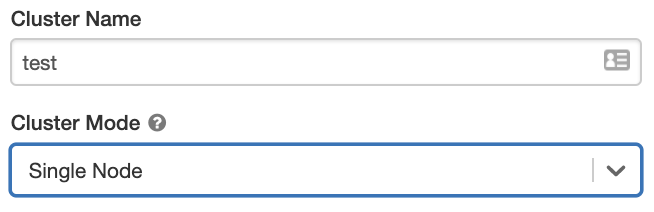

Clusters de nó único

Um cluster de nó único não tem trabalhos e executa trabalhos do Spark no nó do driver.

Por outro lado, um cluster Padrão requer pelo menos um nó de trabalho do Spark além do nó de driver para executar trabalhos do Spark.

Para criar um cluster de Nó Único, defina o modo de cluster como Nó Único.

Para obter mais informações sobre como trabalhar com clusters de nó único, confira Computação de nó único ou de vários nós.

Pools

Para reduzir a hora de início do cluster, você pode anexar um cluster a um pool predefinido de instâncias ociosas, para o driver e para os nós de trabalho. O cluster é criado pelas instâncias nos pools. Se um pool não tiver recursos ociosos em quantidade suficiente para criar o driver de nós de trabalho solicitado, ele se expandirá com a alocação de novas instâncias do provedor de instâncias. Quando um cluster anexado é encerrado, as instâncias usadas por ele são retornadas para os pools e podem ser reutilizadas por outro cluster.

Se você selecionar um pool para nós de trabalho, mas não para o nó do driver; o nó do driver herdará o pool da configuração do nó de trabalho.

Importante

Se você tentar selecionar um pool para o nó do driver, mas não para os nós de trabalho, ocorrerá um erro e seu cluster não será criado. Esse requisito impede uma situação em que o nó do driver tenha que aguardar a criação de nós de trabalho ou vice-versa.

Confira Referência de configuração de pools para saber mais sobre como trabalhar com pools no Azure Databricks.

Databricks Runtime

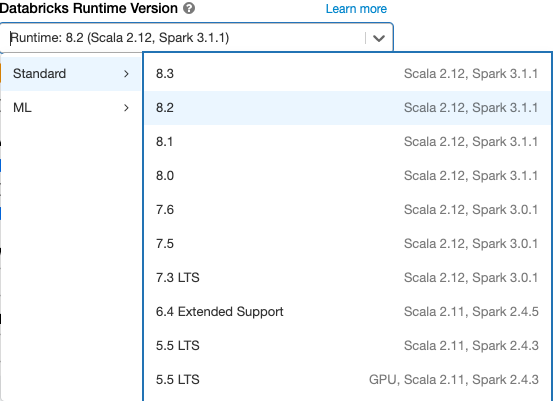

Os tempos de execução do Databricks são o conjunto de componentes principais executados em seus clusters. Todos os tempos de execução do Databricks incluem o Apache Spark e adicionam componentes e atualizações que melhoram a usabilidade, o desempenho e a segurança. Para obter mais detalhes, consulte Versões e compatibilidade das notas de versão do Databricks Runtime.

O Azure Databricks oferece vários tipos de tempos de execução e várias versões desses tipos de tempo de execução na lista suspensa Versão do Databricks Runtime durante a criação ou a edição de um cluster.

Aceleração do Photon

O Photon está disponível para clusters que executam o Databricks Runtime 9.1 LTS e superiores.

Para habilitar a aceleração do Photon, marque a caixa de seleção Usar Aceleração do Photon.

Se desejar, você pode especificar o tipo de instância na lista suspensa Tipo de Trabalho e Tipo de Driver.

O Databricks recomenda os seguintes tipos de instância para ter melhor preço e desempenho:

- Standard_E4ds_v4

- Standard_E8ds_v4

- Standard_E16ds_v4

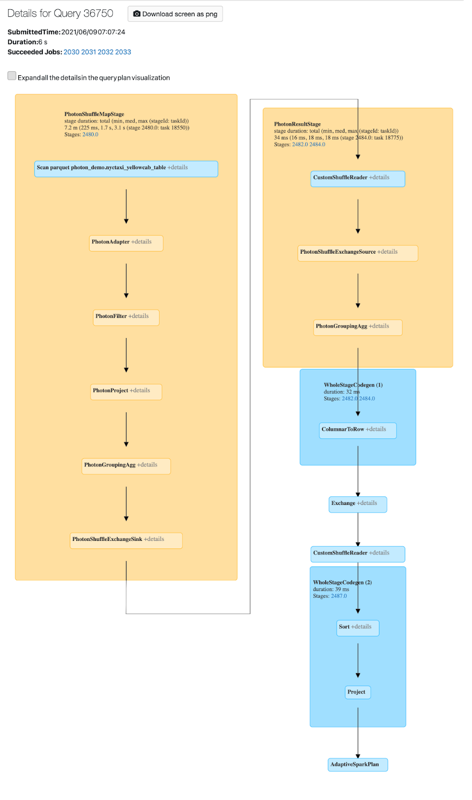

Você pode exibir a atividade do Photon na interface do usuário do Spark. A captura de tela a seguir mostra os detalhes da consulta do DAG. Há duas indicações de Photon no DAG. Primeiro, os operadores do Photon começam por “Photon”, por exemplo, PhotonGroupingAgg. Em segundo lugar, no DAG, os operadores e as fases do Photon têm cor de pêssego; já os não Photon são azuis.

Imagens do Docker

Para algumas versões do Databricks Runtime, você pode especificar uma imagem do Docker na criação de um cluster. Os casos de uso de exemplo incluem personalização de biblioteca, ambiente de contêiner final que não muda e integração CI/CD com o Docker.

Use também imagens do Docker para criar ambientes de aprendizado profundo personalizados em clusters com dispositivos de GPU.

Para obter instruções, consulte Personalizar contêineres com o Serviço de Contêiner do Databricks e Serviço de Contêiner do Databricks na computação de GPU.

Tipo de nó de cluster

Um cluster consiste em um nó de driver e zero ou mais nós de trabalho.

Você pode escolher tipos de instância de provedor de nuvem diferentes para o driver e os nós de trabalho, embora, por padrão, o nó do driver use o mesmo tipo de instância que o nó de trabalho. Diferentes famílias de tipos de instância se ajustam a diferentes casos de uso, como cargas de trabalho com uso intensivo de memória ou com uso intensivo de computação.

Observação

Se os requisitos de segurança incluírem isolamento de computação, selecione uma instância Standard_F72s_V2 como o tipo de trabalho. Esses tipos de instância representam as máquinas virtuais isoladas que consomem todo o host físico e fornecem o nível necessário de isolamento necessário para dar suporte, por exemplo, às cargas de trabalho IL5 (Nível de Impacto 5) do Departamento de Defesa dos EUA.

Nó do driver

O nó do driver mantém informações de estado de todos os notebooks anexados ao cluster. O nó do driver também mantém o SparkContext, interpreta todos os comandos que você executa de um notebook ou uma biblioteca no cluster e executa o mestre do Apache Spark que coordena com os executores do Spark.

O valor padrão do tipo de nó do driver é o mesmo do tipo de nó de trabalho. Você pode escolher um tipo de nó do driver maior com mais memória se está planejando collect() muitos dados de trabalhados do Spark e analisá-los no notebook.

Dica

Como o nó do driver mantém todas as informações de estado dos notebooks anexados, lembre-se de desanexar os notebooks não utilizados do nó do driver.

Nó de trabalho

Os nós de trabalho do Azure Databricks executam os executores do Spark e outros serviços necessários para o funcionamento adequado dos clusters. Quando você distribui sua carga de trabalho com o Spark, todo o processamento distribuído ocorre nos nós de trabalho. O Azure Databricks executa um executor por nó de trabalho. Portanto, os termos executor e trabalho são usados de maneira intercambiável no contexto da arquitetura do Azure Databricks.

Dica

Para executar um trabalho do Spark, você precisará de pelo menos um nó de trabalho. Se um cluster não tiver trabalhos, você poderá executar comandos que não sejam do Spark no nó do driver, mas os comandos do Spark falharão.

Tipos de instância de GPU

Para tarefas difíceis em termos de computação que exigem alto desempenho, como aquelas associadas ao aprendizado profundo, o Azure Databricks dá suporte a clusters acelerados com GPUs (unidades de processamento gráfico). Para obter mais informações, consulte Computação habilitada para GPU.

Instâncias spot

Para economizar custos, você pode optar por usar instâncias spot, também conhecidas como VMs spot do Azure, marcando a caixa de seleção Instâncias spot.

A primeira instância sempre será sob demanda (o nó do driver é sempre sob demanda) e as instâncias subsequentes serão instâncias spot. Se as instâncias spot são removidas devido à indisponibilidade, as instâncias sob demanda são implantadas para substituir as instâncias removidas.

Tamanho do cluster e dimensionamento automático

Ao criar um cluster do Azure Databricks, você pode fornecer um número fixo de trabalhos para o cluster ou fornecer um número mínimo e máximo de trabalhos para o cluster.

Com o fornecimento de um cluster de tamanho fixo, o Azure Databricks faz com que o cluster tenha o número especificado de trabalhos. Quando você fornece um intervalo como número de trabalhos, o Databricks escolhe o número apropriado de trabalhos necessários para executar seu trabalho. Isso é chamado de dimensionamento automático.

Com o dimensionamento automático, o Azure Databricks realoca dinamicamente trabalhos para atender às características do seu trabalho. Determinadas partes do pipeline podem ser mais exigentes computacionalmente do que outras, e o Databricks adiciona automaticamente outros trabalhos durante essas fases do seu trabalho (e as remove quando não são mais necessárias).

Dimensionamento automático torna mais fácil de obter alta utilização do cluster, porque você não precisa provisionar o cluster de acordo com uma carga de trabalho. Isso se aplica especialmente a cargas de trabalho cujos requisitos mudam ao longo do tempo (como explorar um conjunto de dados ao longo de um dia), mas também pode se aplicar a uma carga de trabalho única e menor cujos requisitos de provisionamento sejam desconhecidos. Assim, o dimensionamento automático oferece duas vantagens:

- As cargas de trabalho podem ser executadas mais rapidamente em comparação com um cluster subconfigurado de tamanho constante.

- Os clusters de dimensionamento automático podem reduzir os custos gerais em comparação com um cluster de tamanho estático.

Dependendo do tamanho constante do cluster e da carga de trabalho, o dimensionamento automático fornece um ou ambos benefícios ao mesmo tempo. O tamanho do cluster pode ficar abaixo do número mínimo de trabalhos selecionados quando o provedor de nuvem termina as instâncias. Nesse caso, o Azure Databricks tenta continuamente reprovisionar instâncias para manter o número mínimo de trabalhos.

Observação

O dimensionamento automático não está disponível para trabalhos spark-submit.

Como o dimensionamento automático se comporta

- Escala verticalmente de mínimo para máximo em duas etapas.

- Poderá reduzir verticalmente mesmo se o cluster não estiver ocioso com o exame do estado do arquivo em ordem aleatória.

- Reduz verticalmente com base em uma porcentagem dos nós atuais.

- Em clusters de trabalho, reduzirá verticalmente se o cluster estiver subutilizado nos 40 segundos anteriores.

- Em clusters de uso geral, reduzirá verticalmente se o cluster estiver subutilizado nos 150 segundos anteriores.

- A propriedade de configuração do Spark

spark.databricks.aggressiveWindowDownSespecifica em segundos com que frequência um cluster faz decisões de redução vertical. O aumento do valor faz com que um cluster seja reduzido verticalmente de forma mais lenta. O valor máximo é 600.

Habilitar e configurar o dimensionamento automático

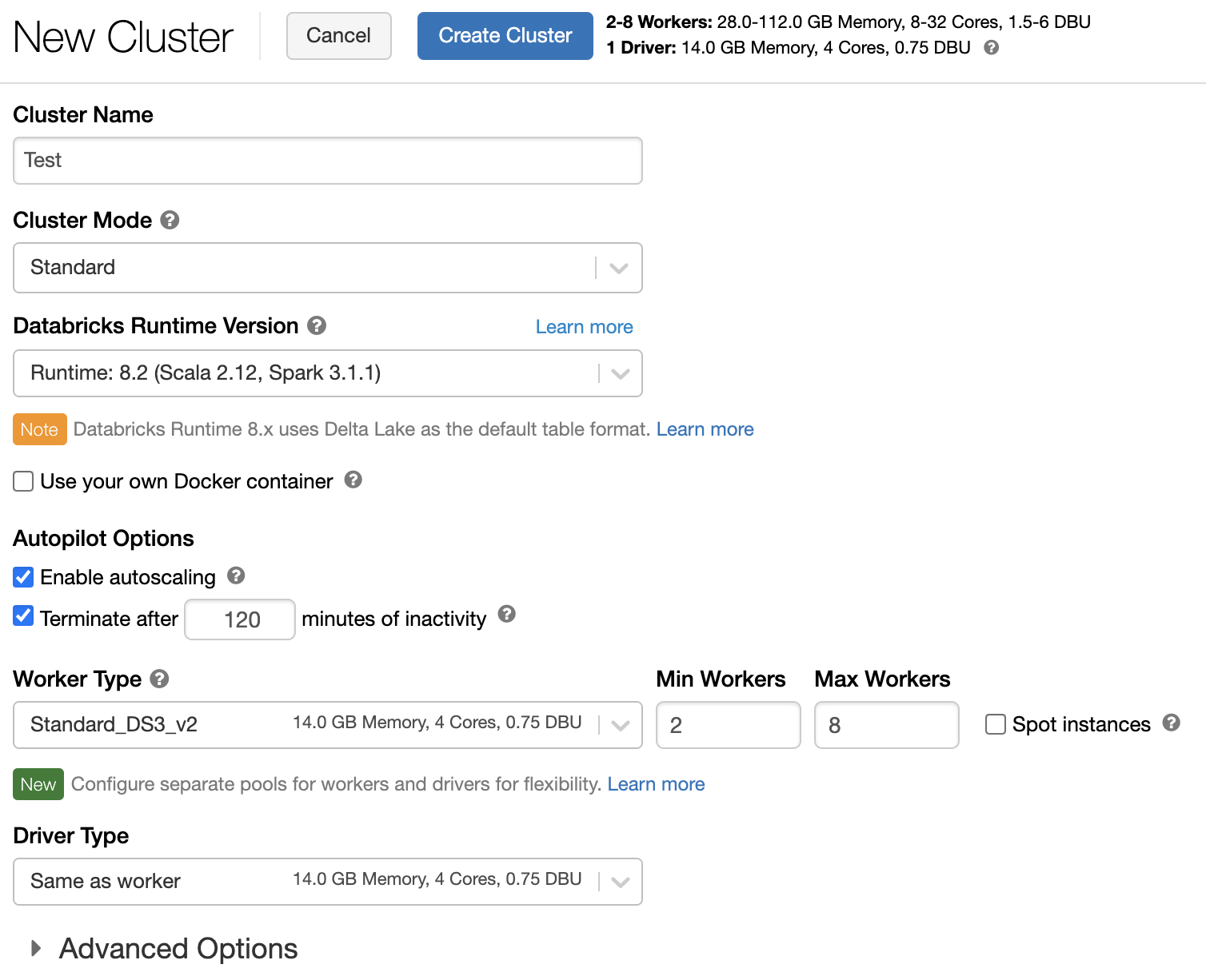

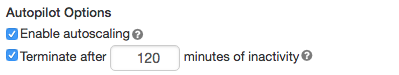

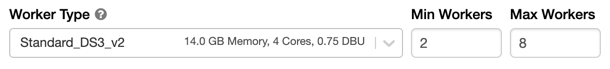

Para permitir que o Azure Databricks redimensione o cluster automaticamente, habilite o dimensionamento automático para o cluster e forneça os intervalos mínimo e máximo de trabalhos.

Habilite o dimensionamento automático.

Cluster de uso geral – Na página Criar Cluster, marque a caixa de seleção Habilitar dimensionamento automático nas Opções do Autopilot:

Cluster de trabalho – Na página Configurar Cluster, marque a caixa de seleção Habilitar dimensionamento automático nas Opções do Autopilot:

Configure os trabalhos mínimo e máximo.

Quando o cluster estiver em execução, a página de detalhes do cluster exibirá o número de trabalhos alocados. Você pode comparar o número de trabalhos alocados com a configuração do trabalho e fazer ajustes conforme a necessidade.

Importante

Se você estiver usando um pool de instâncias:

- Verifique se o tamanho do cluster solicitado é menor ou igual ao número mínimo de instâncias ociosas no pool. Se for maior, o tempo de inicialização do cluster será equivalente a um cluster que não usa um pool.

- Verifique se o tamanho máximo do cluster é menor ou igual à capacidade máxima do pool. Se for maior, a criação do cluster falhará.

Exemplo de dimensionamento automático

Se você reconfigurar um cluster estático para ser um cluster de dimensionamento automático, o Azure Databricks redimensionará imediatamente o cluster dentro dos limites mínimo e máximo e, em seguida, iniciará o dimensionamento automático. Por exemplo, a tabela a seguir demonstra o que acontece com clusters com determinado tamanho inicial se você reconfigura um cluster para dimensionamento automático entre 5 e 10 nós.

| Tamanho inicial | Tamanho após a reconfiguração |

|---|---|

| 6 | 6 |

| 12 | 10 |

| 3 | 5 |

Dimensionamento automático do armazenamento local

Em geral, pode ser difícil estimar quanto espaço em disco um trabalho específico usará. Para poupar você de precisar estimar quantos gigabytes de disco gerenciado devem ser anexados ao cluster no momento da criação, o Azure Databricks habilita automaticamente o armazenamento local com dimensionamento automático em todos os clusters do Azure Databricks.

Com o armazenamento local com o dimensionamento automático, o Azure Databricks monitora a quantidade de espaço livre em disco disponível nos trabalhos Spark do cluster. Se um trabalho começar a ser executado com muito pouco disco, o Databricks anexará automaticamente um novo disco gerenciado ao trabalho antes que ele fique sem espaço em disco. Os discos são anexados até um limite de 5 TB de espaço total em disco por máquina virtual (incluindo o armazenamento local inicial da máquina virtual).

Os discos gerenciados anexados a uma máquina virtual só são desanexados quando a máquina virtual é retornada ao Azure. Ou seja, os discos gerenciados nunca são desanexados de uma máquina virtual, desde que ela faça parte de um cluster em execução. Para reduzir o uso do disco gerenciado, o Azure Databricks recomenda usar esse recurso em um cluster configurado com Tamanho e dimensionamento automático de cluster ou Terminação automática.

Criptografia de disco local

Importante

Esse recurso está em uma versão prévia.

Alguns tipos de instância que você usa para executar clusters podem ter discos anexados localmente. O Azure Databricks pode armazenar dados aleatórios ou efêmeros nesses discos conectados localmente. Para garantir que todos os dados inativos ficarão criptografados para todos os tipos de armazenamento, incluindo dados aleatórios armazenados temporariamente nos discos locais do cluster, você poderá habilitar a criptografia em disco local.

Importante

Suas cargas de trabalho podem ser executadas mais lentamente devido ao impacto no desempenho por conta da leitura e da gravação de dados criptografados entre volumes locais.

Quando a criptografia de disco local está habilitada, o Azure Databricks gera uma chave de criptografia localmente que é exclusiva para cada nó de cluster e é usada para criptografar todos os dados armazenados em discos locais. O escopo da chave é local para cada nó de cluster e é destruído junto com o próprio nó de cluster. Durante seu tempo de vida, a chave reside na memória para criptografia e descriptografia e é armazenada criptografada no disco.

Para habilitar a criptografia de disco local, você precisa usar a API de Clusters. Durante a criação ou edição do cluster, defina:

{

"enable_local_disk_encryption": true

}

Confira a API de Clusters para obter exemplos de como invocar essas APIs.

Aqui está um exemplo de uma chamada de criação de cluster que habilita a criptografia de disco local:

{

"cluster_name": "my-cluster",

"spark_version": "7.3.x-scala2.12",

"node_type_id": "Standard_D3_v2",

"enable_local_disk_encryption": true,

"spark_conf": {

"spark.speculation": true

},

"num_workers": 25

}

Modo de segurança

Se o workspace estiver atribuído para um metastore do Catálogo do Unity, você usará o modo de segurança em vez do modo de cluster de Alta Simultaneidade para garantir a integridade dos controles de acesso e impor garantias de isolamento forte. O modo de cluster de Alta Simultaneidade não está disponível com o Catálogo do Unity.

Em Opções avançadas, selecione entre os seguintes modos de segurança de cluster:

- Nenhum: sem isolamento. Não impõe o controle de acesso à tabela local do workspace nem a passagem de credenciais. Não pode acessar os dados do Catálogo do Unity.

- Usuário Único: pode ser usado somente por um usuário (por padrão, o usuário que criou o cluster). Os outros usuários não podem fazer anexações ao cluster. Ao acessar uma exibição em um cluster com o modo de segurança Usuário Único, a exibição é executada com as permissões do usuário. Os clusters de usuário único oferecem suporte a cargas de trabalho usando Python, Scala e R. Scripts de inicialização, instalação de biblioteca e montagens DBFS são compatíveis com clusters de usuário único. Os trabalhos automatizados devem usar clusters de usuário único.

- Isolamento do Usuário: pode ser compartilhado por vários usuários. Há suporte para cargas de trabalho SQL. A instalação da biblioteca, os scripts de inicialização e as montagens do DBFS são desabilitados para impor o isolamento estrito entre os usuários do cluster.

- Somente ACL de Tabela (herdada): impõe o controle de acesso à tabela local do workspace, mas não pode acessar os dados do Catálogo do Unity.

- Somente passagem (herdada): impõe a passagem de credenciais local do workspace, mas não pode acessar os dados do Catálogo do Unity.

Os únicos modos de segurança compatíveis com as cargas de trabalho do Catálogo do Unity são Isolamento do Usuário e Usuário Único.

Para obter mais informações, confira Modos de acesso.

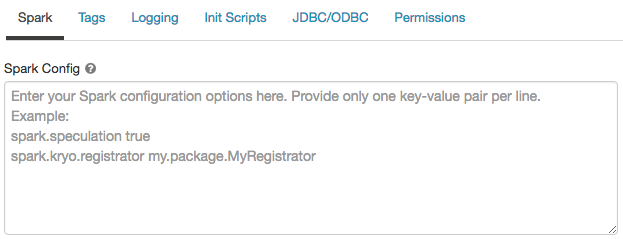

Configuração do Spark

Para ajustar os trabalhos do Spark, você pode fornecer Propriedades de configuração do Spark personalizadas em uma configuração de cluster.

Na página de configuração do cluster, clique na alternância Opções Avançadas.

Clique na guia Spark.

Na configuração do Spark, insira as propriedades de configuração como um par chave-valor por linha.

Ao configurar um cluster usando a API de Clusters, defina as propriedades do Spark no campo spark_conf em Criar nova API de cluster ou na API de atualização da configuração de cluster.

O Databricks não recomenda usar scripts de inicialização globais.

Para definir as propriedades do Spark para todos os clusters, crie um script init global:

dbutils.fs.put("dbfs:/databricks/init/set_spark_params.sh","""

|#!/bin/bash

|

|cat << 'EOF' > /databricks/driver/conf/00-custom-spark-driver-defaults.conf

|[driver] {

| "spark.sql.sources.partitionOverwriteMode" = "DYNAMIC"

|}

|EOF

""".stripMargin, true)

Recuperar uma propriedade de configuração do Spark de um segredo

O Databricks recomenda o armazenamento de informações confidenciais, por exemplo senhas, como segredo em vez de texto não criptografado. Para fazer referência a um segredo na configuração do Spark, use a seguinte sintaxe:

spark.<property-name> {{secrets/<scope-name>/<secret-name>}}

Por exemplo, para definir uma propriedade de configuração do Spark chamada password como o valor do segredo armazenado em secrets/acme_app/password:

spark.password {{secrets/acme-app/password}}

Para obter mais informações, consulte Gerenciar segredos.

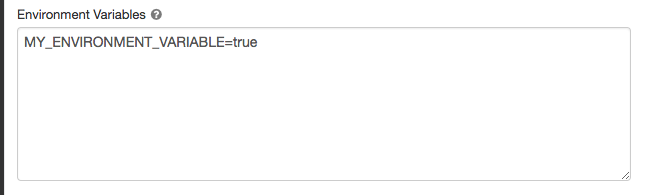

Variáveis de ambiente

Você pode definir variáveis de ambiente personalizadas que podem ser acessadas de scripts init em execução em um cluster. Databricks também fornece variáveis de ambiente predefinidas que você pode usar em scripts init. Não é possível substituir essas variáveis de ambiente predefinidas.

Na página de configuração do cluster, clique na alternância Opções Avançadas.

Clique na guia Spark.

Defina as variáveis de ambiente no campo Variáveis de Ambiente.

Você também pode definir variáveis de ambiente usando o campo spark_env_vars na API de criação de novo cluster ou na API de atualização da configuração de cluster.

Tags de cluster

As marcas de cluster permitem que você monitore facilmente o custo dos recursos de nuvem usados por vários grupos em sua organização. Você pode especificar marcas como pares de chave-valor ao criar um cluster, e o Azure Databricks aplica essas marcas a recursos de nuvem, como VMs e volumes de disco, além de relatórios de uso da DBU.

Para clusters iniciados de pools, as marcas de cluster personalizadas são aplicadas somente a relatórios de uso da DBU e não se propagam para recursos de nuvem.

Para obter informações detalhadas sobre como os tipos de marca de pool e cluster funcionam juntos, confira Monitorar o uso usando marcas.

Para sua conveniência, o Azure Databricks aplica quatro marcas padrão a cada cluster: Vendor, Creator, ClusterName e ClusterId.

Além disso, em clusters de trabalho, o Azure Databricks aplica duas marcas padrão: RunName e JobId.

Nos recursos usados pelo Databricks SQL, o Azure Databricks também aplica a marca padrão SqlWarehouseId.

Aviso

Não atribua uma marca personalizada com a chave Name a um cluster. Cada cluster tem uma marca Name cujo valor é definido pelo Azure Databricks. Se você alterar o valor associado à chave Name, o cluster não poderá mais ser acompanhado pelo Azure Databricks. Como consequência, o cluster pode não ser encerrado depois de ficar ocioso e continuará a incorrer em custos de uso.

Você pode adicionar marcas personalizadas na criação de um cluster. Para configurar marcas de cluster:

Na página de configuração do cluster, clique na alternância Opções Avançadas.

Na parte inferior da página, clique na guia Marcas.

Adicione um par chave-valor a cada marca personalizada. Adicione até 43 marcas personalizadas.

Acesso SSH a clusters

Por motivos de segurança, no Azure Databricks a porta SSH está fechada por padrão. Se você quiser habilitar o acesso SSH aos clusters do Spark, contate o suporte do Azure Databricks.

Observação

O SSH pode ser habilitado somente se o workspace for implantado em sua própria rede virtual do Azure.

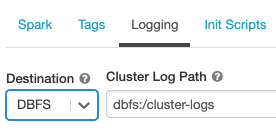

Entrega de log de cluster

Ao criar um cluster, você poderá especificar um local a fim de entregar os logs para o nó do driver do Spark, os nós de trabalho e os eventos. Os logs são entregues a cada cinco minutos no destino escolhido. Quando um cluster é terminado, o Azure Databricks garante a entrega de todos os logs gerados até que o cluster seja terminado.

O destino dos logs depende do ID do cluster. Se o destino especificado for dbfs:/cluster-log-delivery, os logs de cluster para 0630-191345-leap375 serão entregues em dbfs:/cluster-log-delivery/0630-191345-leap375.

Para configurar o local de entrega de logs:

Na página de configuração do cluster, clique na alternância Opções Avançadas.

Clique na guia Registrar em log.

Selecione um tipo de destino.

Insira o caminho para o log do cluster.

Observação

Esse recurso também está disponível na API REST. Consulte a API de clusters.

Scripts de inicialização

Um script de inicialização de nó de cluster, ou init, é um script shell que é executado durante a inicialização para cada nó de cluster antes da inicialização do driver do Spark ou da JVM do trabalho. Você pode usar scripts init para instalar pacotes e bibliotecas não incluídos no tempo de execução do Databricks, modificar o classpath do sistema JVM, definir propriedades do sistema e variáveis de ambiente usadas pela JVM ou modificar parâmetros de configuração do Spark, dentre outras tarefas de configuração.

Você pode anexar os scripts init a um cluster expandindo a seção Opções Avançadas e clicando na guia Scripts Init.

Para obter instruções detalhadas, consulte O que são scripts de inicialização?.