Come configurare filtri di contenuto con il servizio OpenAI di Azure.

Il sistema di filtro del contenuto integrato nel servizio OpenAI di Azure viene eseguito insieme ai modelli di base, inclusi i modelli di generazione immagini DALL-E. Usa un insieme di modelli di classificazione multiclasse per rilevare quattro categorie di contenuto dannoso (violenza, odio, sesso e autolesionismo) in base a quattro livelli di gravità (sicuro, basso, medio e alto) e classificatori binari facoltativi per rilevare il rischio di jailbreak, testo esistente e codice nei repository pubblici. La configurazione di filtro del contenuto predefinita è impostata per filtrare in base alla soglia di gravità media per tutte e quattro le categorie di contenuti pericolosi sia per le richieste che per i completamenti. Ciò significa che il contenuto rilevato a livello di gravità medio o alto viene filtrato, mentre il contenuto rilevato a livello di gravità basso o sicuro non viene filtrato in base ai filtri di contenuto. Altre informazioni sulle categorie di contenuto, i livelli di gravità e il comportamento del sistema di filtro del contenuto sono disponibili qui. Il rilevamento dei rischi di jailbreak e i modelli di testo e codice protetti sono facoltativi e disattivati per impostazione predefinita. Per il rilevamento dei rischi di jailbreak e i modelli di testo e codice protetti, la funzionalità di configurabilità consente a tutti i clienti di attivare e disattivare i modelli. I modelli sono disattivati per impostazione predefinita e possono essere attivati in base allo scenario. Per alcuni scenari è necessario che alcuni modelli siano attivati per mantenere la copertura in base all'Impegno per il copyright del cliente.

Nota

Tutti i clienti hanno la possibilità di modificare i filtri del contenuto e configurare le soglie di gravità (bassa, media, alta). L'approvazione è necessaria per disattivare parzialmente o completamente i filtri di contenuto. I clienti gestiti possono richiedere il controllo completo solo del filtro del contenuto tramite questo modulo: Verifica di accesso limitato di Azure OpenAI: filtri di contenuto modificati. In questo momento, non è possibile diventare un cliente gestito.

I filtri di contenuti possono essere configurati a livello di risorsa. Dopo aver creato una nuova configurazione, può essere associata a una o più distribuzioni. Per altre informazioni sulla distribuzione del modello, vedere la guida alla distribuzione delle risorse.

Prerequisiti

- È necessario disporre di una risorsa di Azure OpenAI e una distribuzione di un modello linguistico di grandi dimensioni per configurare i filtri di contenuti. Per iniziare, seguire una guida di avvio rapido.

Comprendere la configurabilità dei filtri di contenuti

Servizio OpenAI di Azure include le impostazioni di sicurezza predefinita applicata a tutti i modelli, escluso Whisper di Azure OpenAI. Queste configurazioni offrono un'esperienza responsabile per impostazione predefinita, tra cui modelli di filtro dei contenuti, elenchi di elementi bloccati, trasformazione di prompt, credenziali del contenuto e altro ancora. Per altre informazioni, leggere qui.

Tutti i clienti possono anche configurare filtri di contenuto e creare criteri di sicurezza personalizzati in base ai requisiti dei casi d'uso. La funzionalità di configurabilità consente ai clienti di modificare le impostazioni (separatamente per prompt e completamenti) in modo da filtrare contenuto per ogni categoria di contenuto a livelli di gravità diversi, come descritto nella tabella seguente. Il contenuto rilevato con il livello di gravità "sicuro" è etichettato nelle annotazioni, ma non è soggetto al filtro e non è configurabile.

| Intensità del filtro | Configurabile per richieste | Configurabile per completamenti | Descrizione |

|---|---|---|---|

| Basso, medio, elevato | Sì | Sì | Configurazione di filtraggio più intenso. Il contenuto rilevato a livelli di gravità basso, medio e alto viene filtrato. |

| Medio, alto | Sì | Sì | Il contenuto rilevato con livello di gravità basso non viene filtrato, il contenuto a livello medio e alto viene filtrato. |

| Alto | Sì | Sì | Il contenuto rilevato a livelli di gravità basso e medio non viene filtrato. Viene filtrato solo il contenuto a livello di gravità elevato. |

| Nessun filtro | Se approvato1 | Se approvato1 | Nessun contenuto viene filtrato indipendentemente dal livello di gravità rilevato. Richiede approvazione1. |

| Solo annotazione | Se approvato1 | Se approvato1 | Disabilita la funzionalità di filtro, quindi il contenuto non verrà bloccato, ma le annotazioni vengono restituite tramite risposta dell’API. Richiede approvazione1. |

1 Per i modelli di Azure OpenAI, solo i clienti che sono stati approvati per il filtro dei contenuti modificato hanno il controllo completo dei filtri dei contenuti e possono disattivarli. Applicare per i filtri di contenuto modificati tramite questo modulo: Verifica di accesso limitato di Azure OpenAI: Filtri di contenuto modificati. Per Azure per enti pubblici clienti, richiedere filtri di contenuto modificati tramite questo modulo: Azure per enti pubblici - Richiedi filtro contenuto modificato per il servizio OpenAI di Azure.

I filtri di contenuti configurabili per input (prompt) e output (completion) sono disponibili per i modelli Azure OpenAI seguenti:

- Serie di modelli GPT

- Disponibilità generale di Visione basata su GPT-4 Turbo* (

turbo-2024-04-09) - GPT-4o

- GPT-4o mini

- DALL-E 2 e 3

I filtri di contenuto configurabili non sono disponibili per

- o1-preview

- o1-mini

*Disponibile solo per GPT-4 Turbo Vision GA, non si applica all'anteprima di GPT-4 Turbo Vision

Le configurazioni di filtraggio del contenuto vengono create all'interno di una risorsa in Azure AI Studio e possono essere associate a distribuzioni. Ulteriori informazioni sulla configurabilità sono disponibili qui.

I clienti sono tenuti ad accertarsi che le applicazioni che integrano Azure OpenAI siano conformi al Codice di comportamento.

Comprendere gli altri filtri

È possibile configurare le categorie di filtro seguenti oltre ai filtri di categoria di danni predefiniti.

| Categoria del filtro | Status | Impostazione predefinita | Applicato a prompt o completamento? | Descrizione |

|---|---|---|---|---|

| Prompt Shields per attacchi diretti (jailbreak) | Disponibilità generale | Attivato | Prompt utente | Filtra/annota i prompt degli utenti che potrebbero presentare un rischio di jailbreak. Per altre informazioni sulle annotazioni, vedere Filtro del contenuto del servizio OpenAI di Azure. |

| Prompt Shields per attacchi indiretti | Disponibilità generale | Attivato | Prompt utente | Filtra/annota gli attacchi indiretti, noti anche come attacchi con prompt indiretti o attacchi di prompt injection tra domini. Rappresentano una potenziale vulnerabilità in cui soggetti terzi inseriscono istruzioni dannose all'interno di documenti accessibili ed elaborabili dal sistema di intelligenza artificiale generativa. Obbligatorio: formattazione documento . |

| Materiale protetto - codice | Disponibilità generale | Attivato | Completamento | Filtra codice protetto o ottiene le informazioni di citazione e licenza di esempio nelle annotazioni per frammenti di codice che corrispondono a qualsiasi origine di codice pubblica, con tecnologia GitHub Copilot. Per altre informazioni sull'utilizzo delle annotazioni, vedere la guida sui concetti relativi al filtro del contenuto |

| Materiale protetto - testo | Disponibilità generale | Attivato | Completamento | Identifica e blocca la visualizzazione del contenuto di testo noto nell'output del modello (ad esempio, testi di brani musicali, ricette e contenuto Web selezionato). |

| Terra terra* | Anteprima | Disattivato | Completamento | Rileva se le risposte testuali dei modelli linguistici di grandi dimensioni (LLM) sono fondate sui materiali di origine forniti dagli utenti. L’espressione “non fondatezza” si riferisce a istanze in cui i modelli linguistici di grandi dimensioni producono informazioni non concrete o imprecise rispetto a ciò che era presente nei materiali di origine. |

*Richiede l'incorporamento di documenti nella richiesta. Altre informazioni.

Configurare i filtri di contenuto con Azure AI Studio

I passaggi seguenti illustrano come configurare una configurazione di filtro del contenuto personalizzata per la risorsa OpenAI di Azure in AI Studio. Per indicazioni sui filtri di contenuto nel progetto di Azure AI Studio, vedere Filtro del contenuto di Azure AI Studio.

Passare ad Azure AI Studio e passare alla pagina Sicurezza e sicurezza nel menu a sinistra.

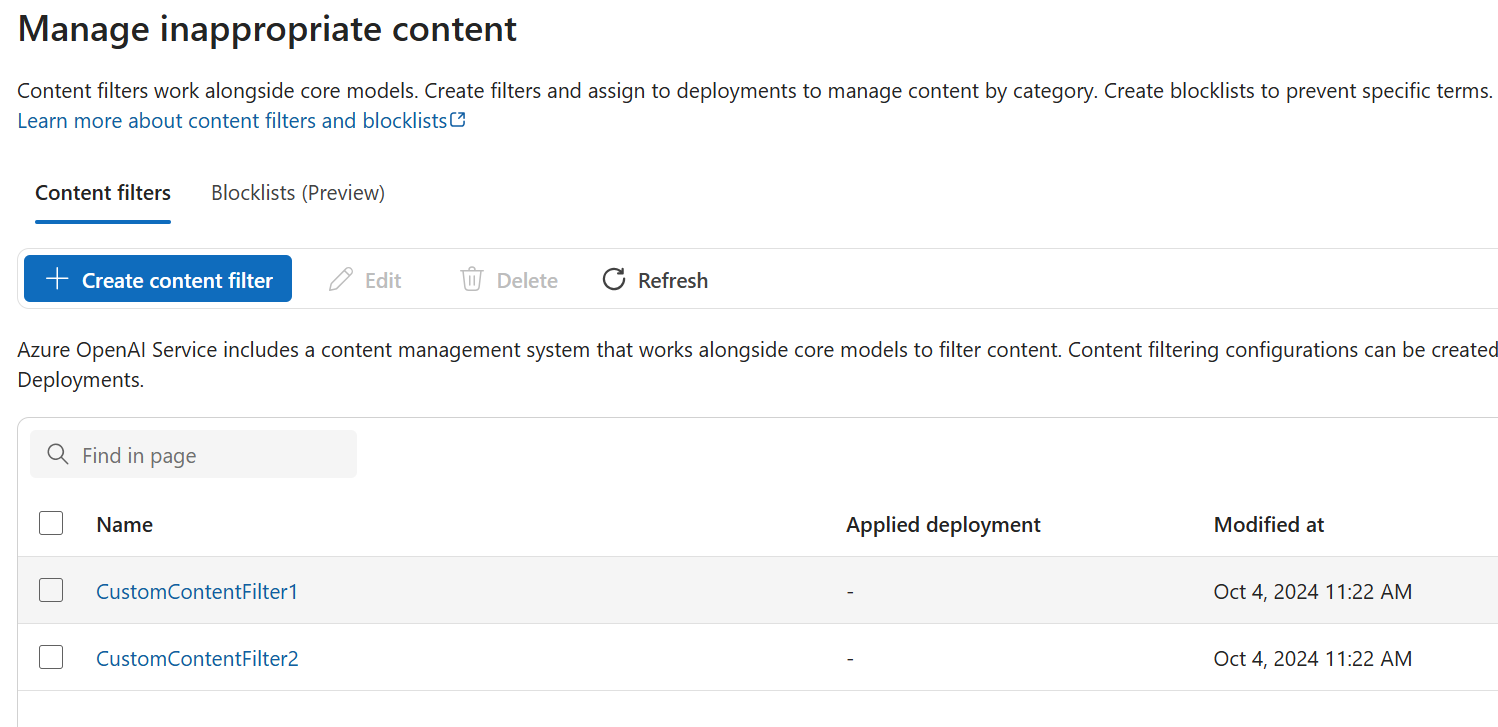

Passare alla scheda Filtri contenuto e creare una nuova configurazione di filtro contenuto personalizzata.

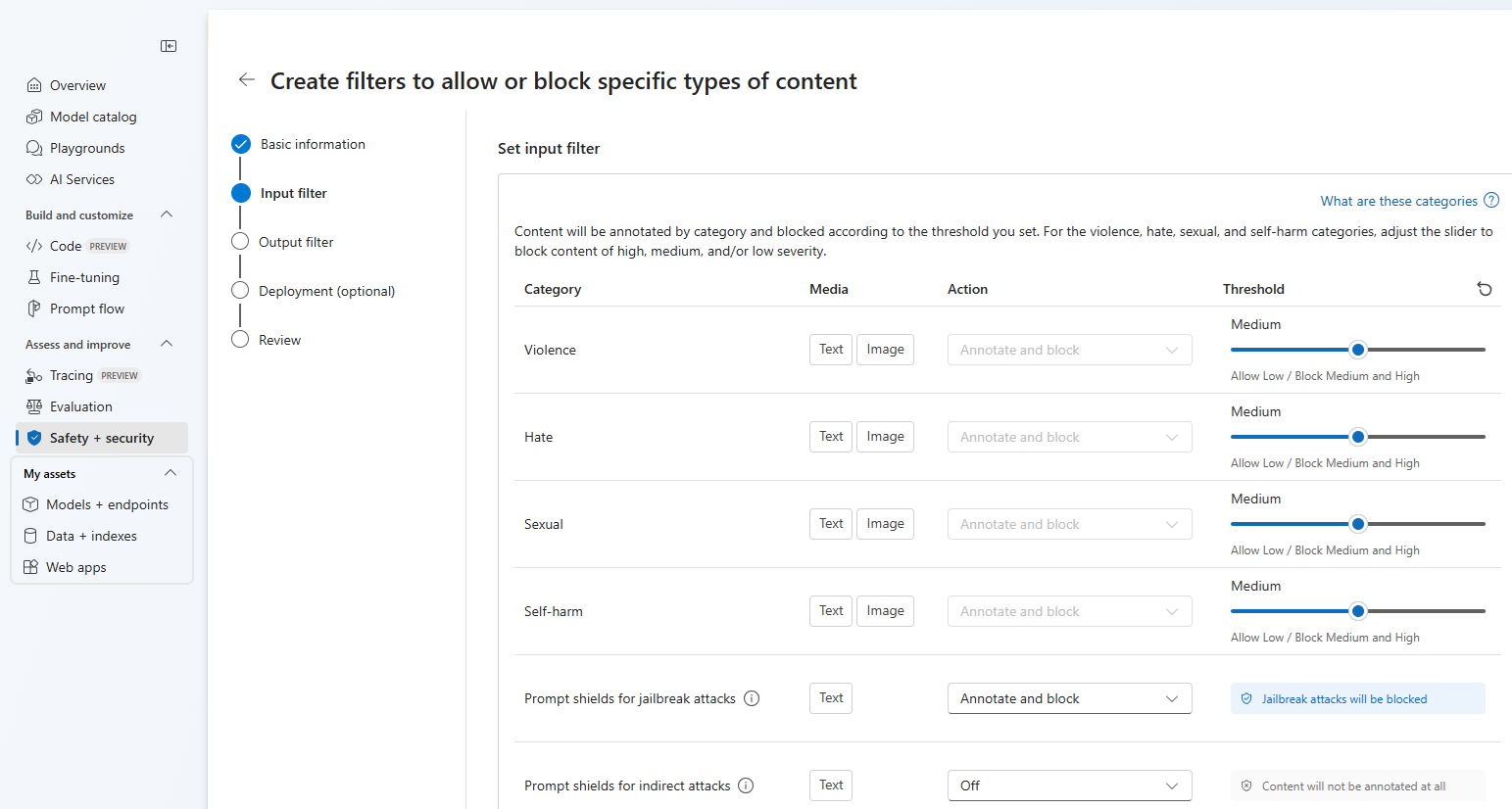

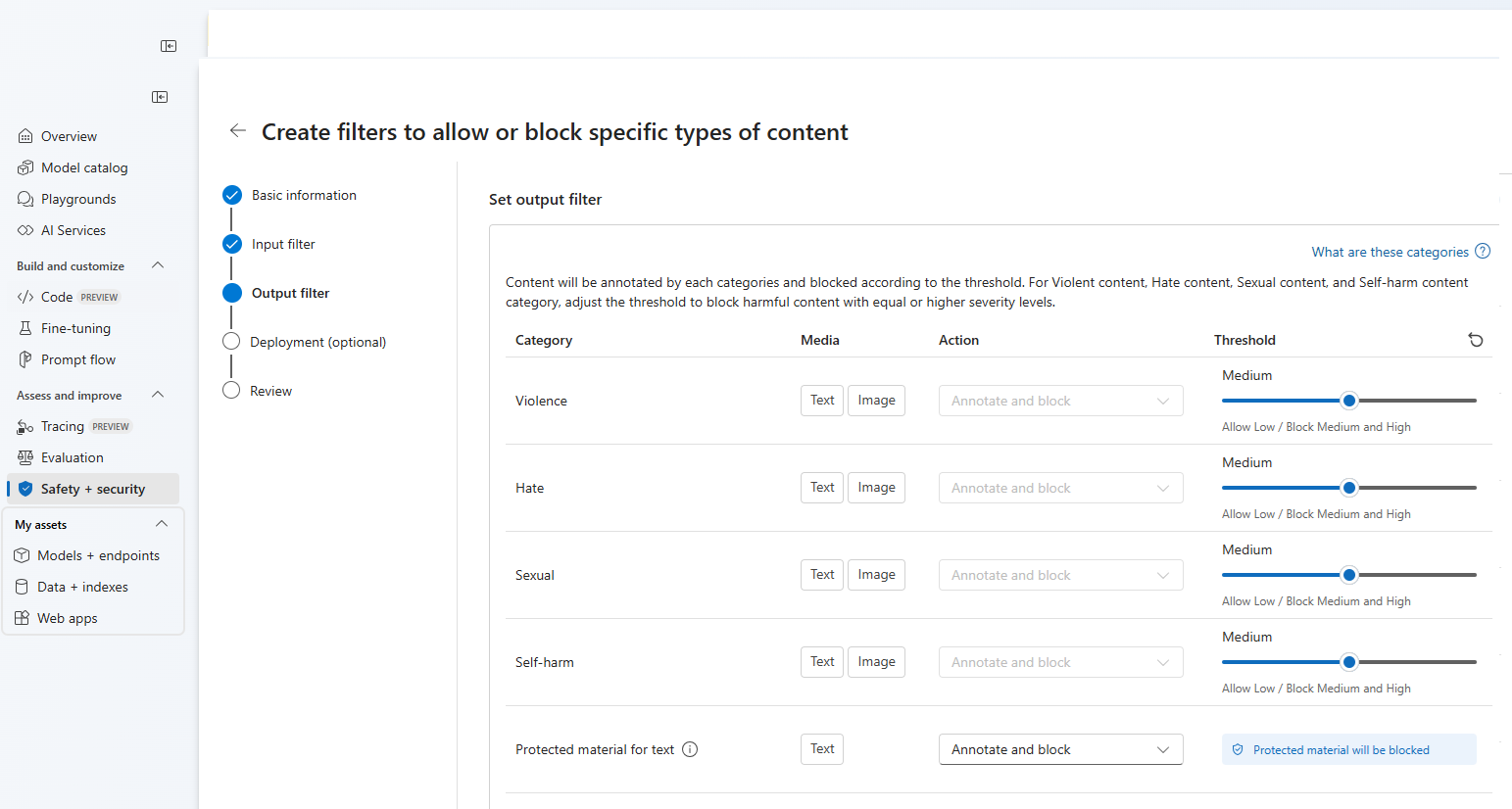

In questo modo viene visualizzata la visualizzazione di configurazione seguente, in cui è possibile scegliere un nome per la configurazione del filtro del contenuto personalizzato. Dopo aver immesso un nome, è possibile configurare i filtri di input (per le richieste degli utenti) e i filtri di output (per il completamento del modello).

Per le prime quattro categorie di contenuto sono disponibili tre livelli di gravità configurabili: basso, medio e alto. È possibile usare i dispositivi di scorrimento per impostare la soglia di gravità se si determina che l'applicazione o lo scenario di utilizzo richiede filtri diversi rispetto ai valori predefiniti.

Alcuni filtri, ad esempio Prompt Shields e Protected material detection, consentono di determinare se il modello deve annotare e/o bloccare il contenuto. Selezionando Annotazioni viene eseguito solo il rispettivo modello e vengono restituite annotazioni tramite risposta API, ma non verrà filtrato il contenuto. Oltre a aggiungere annotazioni, è anche possibile scegliere di bloccare il contenuto.

Se il caso d'uso è stato approvato per i filtri di contenuto modificati, si riceve il controllo completo sulle configurazioni di filtro dei contenuti e può scegliere di disattivare parzialmente o completamente il filtro oppure abilitare l'annotazione solo per le categorie di danni al contenuto (violenza, odio, sesso e autolesionismo).

È possibile creare più configurazioni di filtro del contenuto in base alle esigenze.

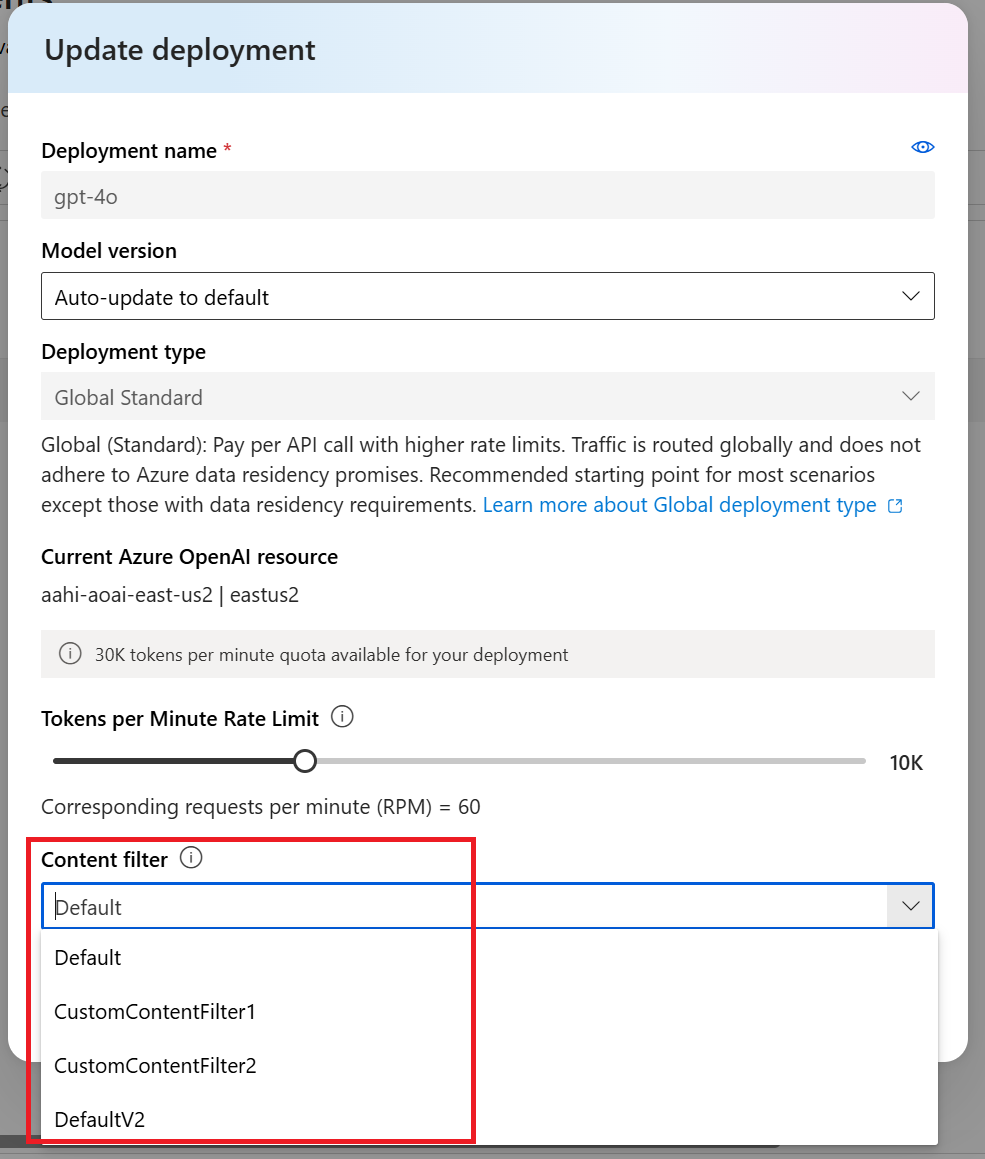

Successivamente, per usare una configurazione di filtro del contenuto personalizzata, assegnarla a una o più distribuzioni nella risorsa. A tale scopo, passare alla scheda Distribuzioni e selezionare la distribuzione. A questo punto selezionare Modifica.

Nella finestra Aggiorna distribuzione visualizzata selezionare il filtro personalizzato dal menu a discesa Filtro contenuto. Selezionare quindi Salva e chiudi per applicare la configurazione selezionata alla distribuzione.

Se necessario, è anche possibile modificare ed eliminare una configurazione del filtro contenuto.

Prima di eliminare una configurazione di filtro del contenuto, è necessario annullare l'assegnazione e sostituirla da qualsiasi distribuzione nella scheda Distribuzioni .

Commenti e suggerimenti sui filtri dei contenuti del report

Se si verifica un problema di filtro del contenuto, selezionare il pulsante Invia commenti e suggerimenti nella parte superiore del playground. Questa opzione è abilitata nel playground Immagini, Chat e Completamenti .

Quando viene visualizzata la finestra di dialogo, selezionare il problema di filtro del contenuto appropriato. Includere il maggior numero di dettagli possibile relativi al problema di filtro del contenuto, ad esempio l'errore specifico di filtro del contenuto e prompt. Non includere informazioni private o riservate.

Per il supporto, inviare un ticket di supporto.

Seguire le procedura consigliate

È consigliabile informare le decisioni di configurazione del filtro del contenuto tramite un'identificazione iterativa (ad esempio, test red team, test di stress e analisi) e un processo di misurazione per risolvere i potenziali danni rilevanti per uno scenario specifico di modello, applicazione e distribuzione. Dopo aver implementato mitigazioni come il filtro del contenuto, ripetere la misurazione per testare l'efficacia. Le raccomandazioni e le procedure consigliate per l'intelligenza artificiale responsabile per Azure OpenAI, riportate in Microsoft Responsible AI Standard sono disponibili nella Panoramica dell'intelligenza artificiale responsabile per Azure OpenAI.

Contenuto correlato

- Altre informazioni sulle procedure di intelligenza artificiale responsabile per Azure OpenAI: Panoramica delle procedure di intelligenza artificiale responsabili per i modelli OpenAI di Azure.

- Altre informazioni su categorie di filtro del contenuto e livelli di gravità con il servizio OpenAI di Azure.

- Per altre informazioni sul red teaming, vedere l'articolo Introduzione al red teaming di modelli di linguaggio di grandi dimensioni.